智能汽车三维目标检测算法发展综述及三维物体检测数据集————文献总结

本文章是2021年EI收录的一篇文章,

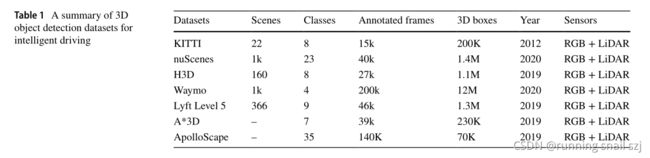

在文章的2.4阐述了常见的 “三维物体检测数据集”,包括 Lyft Level 5、 KITTI、 ApolloScape等。

原文可以在我的资源中下载:智能车辆开发中的三维目标检测算法综述.pdf

![]()

正文开始!

本文的结构如下。第2节描述智能驾驶中感知工作常用的传感器和数据集。第3节列出了自动驾驶中三维目标检测的代表性框架。第四节比较和总结了不同的三维目标检测算法的结果。第5节简要总结了三维物体检测算法。

摘要

随着计算机视觉人工智能算法的快速发展,二维物体检测取得了巨大的成功,并在各种工业产品中得到了应用。在过去的几年里,二维物体检测的精度有了很大的提高,甚至超过了人眼的检测能力。然而,对于智能驾驶的应用,二维目标检测仍然存在一定的局限性。一辆安全可靠的自动驾驶汽车需要检测周围物体的3D模型,从而使智能驾驶汽车具有感知真实驾驶情况的能力。本文系统地综述了应用于智能驾驶技术的三维目标检测方法的发展。本文还分析了现有三维检测算法的不足,以及智能驾驶三维检测算法的未来发展方向。

1、介绍

全球每天有近3700人死于涉及汽车、公共汽车、摩托车或行人的撞车事故。一半以上的遇难者是行人、摩托车手或骑自行车的人。据估计,车祸伤害是全球所有年龄组的第八大死亡原因,也是儿童和年轻人的第一大死亡原因。根据美国交通部的报告,超过90%的车祸是由司机的失误造成的。自动驾驶汽车的采用有望提高驾驶安全和交通效率。因此,一个准确的环境感知系统是减少交通事故的必要条件。

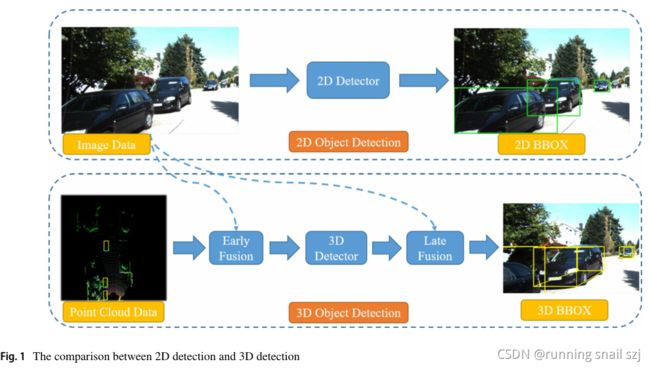

智能驾驶是智能汽车和智能交通系统的重要发展方向之一。一辆安全可靠的自动驾驶汽车需要检测周围物体的3D模型,从而使智能驾驶汽车具有感知真实驾驶情况的能力。配备单目摄像头、立体摄像头或激光雷达的智能驾驶汽车可以获取各种类型的信息。这些传感器的迅速发展为智能驾驶做出了巨大的贡献。此外,基于二维目标检测算法的三维目标检测算法也得到了快速发展。特别是在这两年里,一些不受传统算法结构启发的优秀3D检测作品也取得了良好的表现。3D检测算法的改进,结合传统汽车的智能升级,使智能驾驶更贴近人类生活。二维与三维目标检测对比如图1所示。

2智能驾驶硬件准备

2.1智能驾驶所需要的技术

自动驾驶技术涉及很多技术领域。成熟的自动驾驶汽车需要各种传感器、高精度地图、车联网(IoV)和高性能芯片。如图2所示。

自动驾驶汽车是现代社会讨论最多的技术之一。自动驾驶的发展可以分为6个层次。从2020年到2030年,所有的制造商和研究机构都在推动自动驾驶从3级发展到4级。

- 第0级:司机负责所有的驾驶:转向,刹车,动力等。

- 第1级:这些车一次只能处理一项任务,比如自动刹车。

- 第2级:这些汽车至少有两种自动功能。

- 第3级:在必要时,司机仍然是必不可少的干预,但可以将所有功能转移到车辆。

- 第4级:这些车在某些环境下是无人驾驶的。

- 第5级:预计全自动驾驶系统的功能与人类驾驶员一样好,可以应对各种不受约束的驾驶场景

2.2目前智能汽车的生产厂家

自动驾驶是人工智能技术应用于人类现实生活的最重要场所。特别是在新冠肺炎疫情期间,非接触式机器人应用变得尤为重要。许多汽车制造商在自动驾驶技术方面取得了良好的成绩。

2020年,Waymo在美国亚利桑那州推出了完全无人驾驶的出租车。就目前而言,Waymo是唯一一个用全自动车辆运送乘客的平台,它被视为行业领导者。特斯拉的自动驾驶汽车放弃了昂贵的激光雷达,转而使用摄像头组合开发特斯拉视觉。这使得自动驾驶汽车更便宜,更多的消费者能够体验最新的自动驾驶技术。本田研究所计划在2022年推出L3自动驾驶汽车,在2025年推出L4自动驾驶汽车。宝马计划到2024年生产L4自动驾驶汽车,能够在某些地理位置自动驾驶,如高速公路或双车道。

2.3三维物体检测传感器

在自动驾驶领域,智能汽车中的检测传感器是为智能驾驶系统提供准确、实时信息的最重要设备。在三维物体检测算法中可以使用多种检测传感器,图3列出了最常用的检测传感器。传感器根据探测到的信息种类不同,一般可分为三大类。首先,视觉传感器,如单目相机和立体相机,可以检测颜色信息和像素级图像。深度信息也可以通过三角测量法来计算。其次,激光雷达和雷达可以直接测量深度信息,获取三维场景的点云图。但地图中的点云分布不规则且稀疏,这给以后的神经网络计算带来了一定的困难。第三类传感器是上述两类传感器的融合。融合的传感器可以提供更全面的数据,包括像素级图像和点云地图。理论上,传感器提供的信息越多,探测器的检测精度就越高。

图3、不同传感器的比较

2.4三维目标检测数据集

自2012年以来,已经创建了越来越多的数据集来训练和评估对象检测框架。在三维物体检测研究领域,根据应用场景,数据集可以分为室内和室外。本文综述了智能驾驶场景下主要使用的三维目标检测框架,因此本节重点介绍了几个广泛使用的户外数据集,尤其是自动驾驶数据集,如表1所示。这里列出的这些著名的3D物体检测数据集倾向于使用RGB相机和激光雷达来检测不同类型的数据。这些融合数据集不仅可以提供彩色像素级图像,还可以提供具有深度信息的点云图。

表1、智能驾驶三维目标检测数据集摘要

所有的数据集都包含多个不同的自动驾驶场景,多种对象分类,以及大量的3D标注边界盒,可以保证足够的3D训练和评估数据对象探测器。下面介绍一些最常用的数据集。

2.4.1 KITTI

KITTI数据集是世界上最大的自动驾驶场景计算机视觉算法评估数据集。该数据集用于评估计算机视觉技术的性能,如光流、视觉里程计、3D对象检测和自动驾驶环境中的3D跟踪。KITTI包含从城市、农村和高速公路等场景收集的真实世界图像数据。基蒂的一张图像可以获得多达15辆汽车和30名行人。原始数据集分为道路、城市、住宅、校园和人。对于三维物体检测,标签细分为轿车、货车、卡车、行人、自行车、有轨电车等。

2.4.2 ApolloScape

ApolloScape数据集由百度公司提供。三维LiDAR目标检测和跟踪数据集由点云和高质量标签组成。它是在北京各种照明条件和交通状况下收集的。更具体地说,ApolloScape数据集包含非常复杂的交通流,包括车辆、自行车和行人。

2.4.3 H3D

H3D是本田为自动驾驶场景提供的点云数据集。H3D数据集包含HDD数据集,它也是旧金山湾区采集的大型自然驾驶数据集。H3D拥有完整的360度激光雷达数据集,带有3D边界盒标签。该数据集还包含视频数据,手动注释从2到10赫兹线性。

2.4.4 Waymo

Waymo是谷歌公司旗下的一家自动驾驶汽车公司。Waymo公司发布了Waymo Open Dataset,这是一个基于奖金的基准,与以往的学术基准相比。另外,Waymo包含3000条行车记录,60万帧,3D边界框约2500万个,2D边界框约2200万个。Waymo拥有各种自动驾驶场景的海量数据。

2.4.5 Lyft Level 5

Lyft Level 5也像KITTI数据集一样广为人知。Lyft Level 5数据集由64线雷达和多摄像头获取。Level 5数据集包括超过55,000个人类标记的3D标注框架、表面地图和一个底层高清空间语义地图。我们将三维物体检测方法分为基于视觉的、基于点云的和基于多传感器融合的三种方法。下面将概述这些方法的方法、优点和局限性。下面的小节分别针对每个类别,如图4所示。

图4三维物体检测框架分类

3.1基于视觉的三维检测框架

视觉传感器,特别是单目摄像机,是二维目标检测的重要设备。同时,立体相机和深度相机由于它们的距离测量能力,更适合于在现实世界中检测三维物体。深度信息是第四个图像通道,它包含从物体表面到视点的距离信息。深度图类似于灰度图像,但它的每个像素值都是传感器与目标的实际距离。通常情况下,RGB图像和深度图像具有像素与像素之间的对应关系。

本小节重点介绍基于RGB图像和深度信息估计3D边界框的框架。根据相机的不同,框架主要分为两部分。

3.1.1单眼相机框架

由于缺乏精确的深度信息,在没有激光雷达的情况下,单图像三维目标检测是一项具有挑战性的任务。传统的二维卷积框架无法捕获三维物体及其尺度信息,而这些信息对于三维物体的检测是非常重要的。为了更好地表示三维结构,Ding[1]将二维图像估计的深度图转换为伪激光雷达(PL)表示。然后利用现有的三维物体探测器对物体进行检测。该方法可以从单目相机拍摄的正常图像中预测点云信息。但在预测的点云和实际的点云之间确实存在误差。

3.1.2立体相机框架

激光雷达的三维目标检测总是比相机的精确得多。而PL已经导致了基于激光雷达传感器和那些基于廉价相机的方法之间的精度差距的急剧减少。PL将用于三维深度估计的高级深度神经网络与用于三维目标检测的高级深度神经网络相结合,性能良好。

然而,PL的两个网络需要逐一训练。为了获得端到端PL框架,Qian[2]引入了一个基于可微分表示变化(CoR)模块的新框架,可以对PL进行端到端训练。最终的框架与Point R-CNN结合,得到了比PL更好的结果。在2020年提交时,这项工作在KITTI基于图像的3D物体检测排行榜上获得了最高的排名。然而,立体相机可以通过视差图测量深度信息。而许多最近的工作仍然试图恢复点云的差距估计,然后应用三维探测器基于激光雷达传感器。2020年,Sun[3]提出了一个名为Disp R-CNN的新框架,用于使用立体图像进行三维物体检测。为了解决训练中差异标注不足的挑战,Sun j提出在不需要激光雷达传感器的情况下使用统计真相,这大大降低了智能驾驶的成本。视差图是为整个图像计算的,这在计算上是昂贵的。

因此,Sun j设计了一个实例视差估计网络(iDispNet),它只预测感兴趣对象上的像素的视差,并学习一个类别特定的形状先验,以更准确的视差估计。Disp R-CNN实现了具有竞争力的性能,比持续的先进方法的平均精度高出20%。在过去的几年里,众所周知,基于激光雷达的3D检测框架比基于视觉的方法表现得更好。但是使用激光雷达传感器的三维检测框架在没有图像帮助的情况下无法提取语义信息。因此,Chen[4]提出了一种叫做深立体几何网络(Deep Stereo Geometry Network, DSGN)的方法。通过检测可微体表示上的三维物体,显著地减少了这种差距:三维几何体积,它有效地编码了三维规则空间的三维几何结构。该方法可以同时获取深度信息和语义信息。Chen y提供了一种简单有效的单级立体三维检测管道,通过端到端学习的方式联合估计深度和检测三维物体。DSGN方法优于之前的基于立体的3D检测器,甚至在KITTI 3D物体检测排行榜上的几种基于激光雷达的方法中实现了相当的性能。

3.2基于激光雷达的三维检测框架

目前,基于点云的方法在三维检测方法中实现了最先进的性能。由于点云数据集深度测量准确,许多框架采用基于3D的方法对三维边界盒进行回归,具有较高的检测精度。但基于3D的方法也会带来大量的计算负担。而计算量大的缺点成为实时自动驾驶应用的挑战。因此很多研究者倾向于使用基于二维的检测算法来实现三维目标检测。本小节将基于激光雷达的框架分为两类:二维间接法和三维直接法。

3.2.1二维间接方法框架

Martin等人[5]在2018年利用YOLOv2检测网络实现了一个3D物体检测框架,称为Complex-YOLO。实现了良好的检测速度,满足了自动驾驶的实时三维检测。这项工作将3D点云转化为BEV(鸟瞰)图像,包括高度、密度和强度信息。本工作的主要思路是将三维点云数据转化为二维图像形状,然后使用二维探测器完成三维目标检测。

Li等人在2021年提出了一种称为6DOF-YOLO的2.5D目标检测框架。这项工作还将3D点云转化为BEV(鸟瞰)图像。但与Complex-YOLO不同的是,李的工作做了一个2.5D检测,这可以回归车辆的高度。而Complex-YOLO实际上做了一个二维检测使用点云消息计算三维边界框。李的工作还使用了最先进的YOLOv4[7],在检测效率和准确性之间取得了很大的平衡。

3.2.2三维直接法框架

2018年,Shi等人[8]提出了一种名为PointRCNN的3D检测器,这是一种两阶段3D点云目标检测框架。第一阶段网络通过将整个场景的点云划分为前景和背景,直接从点云中生成少量高质量的3D提案。第二阶段网络通过结合语义特征和局部空间特征,在规范坐标上细化建议。PointRCNN实际上是使用PointNet[9]来完成三维卷积的,在精度上有很大的提高,但效率却没有提到。

2019年,Yang等人[10]提出了一种新的两阶段三维物体检测框架,名为稀疏到密集的三维物体检测器(STD)。该两阶段网络采用pointnet++网络作为三维检测的骨干。新颖的是一种新的球形锚点和三维交叉超联合(IoU),具有较高的查全率和定位精度。这种方法优于其他先进的方法,特别是在硬数据集上,但推理速度只有大约10帧/秒。

3.3传感器融合框架

融合技术对于平衡不同传感器的不同特性起着重要的作用,它可以整合不同传感器的所有优势。目前,多传感器融合三维检测方法分为两种:单级融合和多级融合。

3.3.1单-融合阶段

单级融合是指在特征提取层或数据预处理阶段,对不同传感器的不同特征进行一次融合。其中一个代表作品是PointPainting[11]。

在融合网络结构设计中,不采用端到端的训练,而是分为两个阶段:第一阶段是对摄像机数据进行语义分割;第二阶段是结合激光雷达点云和语义信息进行三维目标检测。这两个阶段通过特征投影连接起来。

3.3.2多-融合阶段

多阶段融合是指在整个融合算法过程中,不同传感器的不同特征将在不同的特征提取层进行多次融合。ContFusion[12]是多阶段融合方法的一个例子。与单级融合相比,该方法更为复杂,主要体现在融合特征的提取上。整体网络结构为端到端网络,分为摄像头特征提取、特征融合、LiDAR特征提取和检测输出四个部分。本设计的特点是两种信息的融合在每个特征检测层进行。所以检测精度可能会非常高。Chen[13]在2017年提出了一种名为MV3D的两阶段3D检测网络。MV3D使用点云和图像作为输入。整个网络可分为两个阶段:第一个阶段是三维提案网络生成感兴趣区域(ROI);二是基于区域的融合网络,将激光雷达鸟瞰图、前视图和图像数据进行融合。MV3D综合分析了不同融合阶段对检测结果的影响。MV3D最终在融合网络的不同层采用了多阶段融合。

4总结

从表2可以看出,上述框架的结果是使用KITTI排行榜上的新评估指标进行评估的。在排行榜上,有几种经过旧评估的方法无法使用。首先,总的来说,所有的鸟瞰(BEV)检测在平均精度(AP)方面都比3D检测有更好的性能。其次,从表中可以看出,使用不同传感器的框架在AP中也有很大的差距。基于视觉传感器的框架总是得到最低的精度,而多传感器融合框架则达到了最先进的性能。但是当我们考虑到传感器的价格时,多传感器融合框架在这三种工作中花费最多,而相机传感器是最便宜的。最优秀的可视化3D检测框架已经实现了与最佳性能非常接近的结果。因此,基于视觉传感器的智能驾驶系统具有广阔的发展前景。

2021年2月,加州机动车辆管理局(Department of Motor Vehicles)发布了新的2020年自动驾驶数据。加州机动车辆管理局的年度每干预英里数(MPI)是自动驾驶的关键测量指标之一,反映了每年每干预的平均英里数。业内普遍认为,这是一种比驾驶体验测试更客观、更定量、更准确的测量方法。由于对不同智能汽车厂商的分析,以及优秀的研发机构,到目前为止最好的测试结果如表3所示。如表所示,这里列出了前10个测试结果,并智能威莫公司的驱动技术具有最好的性能。

本文还总结了自动驾驶中三维目标检测系统存在的一些不足。首先,在无人驾驶汽车的实际应用中,障碍物和周围环境的混乱会导致探测器在交通中错过目标物体。其次,在交通中会有大量的数据需要处理,而大多数算法都不能满足自动驾驶的实时性要求。第三,在无人驾驶中,三维目标检测的实时性难以保证,三维目标检测的准确性不够高,无法保证安全的自动驾驶。智能驾驶的最终目标是自动驾驶技能需要超过人类的平均驾驶技能。因此,智能驾驶需要使用更精确的3D物体检测算法和更快的处理芯片,使自动驾驶汽车更安全、更流畅。使用视觉摄像机的框架是最具竞争力的方法,因为其成本低,具有更高的检测精度的潜力。有人认为,使用摄像头的自动驾驶汽车只有安全保障能力,因为人类只使用眼睛。自动驾驶最重要的是拥有一个聪明的大脑——一个智能的3D探测器。

5、结论

本文系统地综述了应用于智能驾驶技术的三维目标检测方法的发展。本文还讨论了不同传感器获取的不同类型的信息,如RGB图像、点云图和多源信息融合。在详细分析了有效的、有代表性的三维检测作品后,根据不同的实现算法将这些作品归纳为不同的类型。对不同类型的三维检测框架在KITTI基准上的实验数据进行了讨论和比较。并分析了这些检测器在实际交通环境中的实际应用。研究了检测精度与安全驾驶要求精度的关系。最后讨论了现有三维目标检测框架的不足以及智能驾驶的未来发展方向。