使用Keras搭建神经网络(Keras是基于TensorFlow的一个架构)(tf.keras是Tensorflow的API)

使用Keras搭建神经网络(Keras是基于TensorFlow的一个架构)(tf.keras是Tensorflow的API)

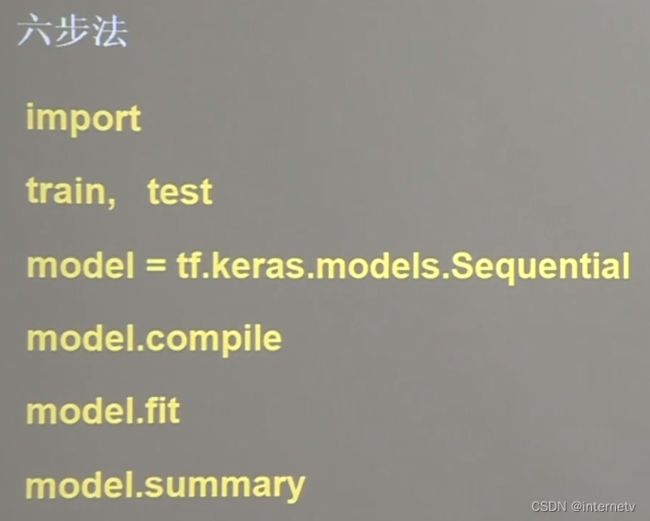

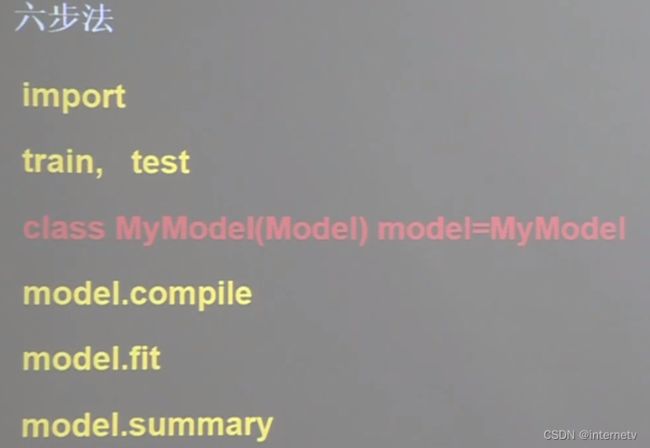

神经网络搭建八股

第一步,导入相关依赖

第二步,告知要喂入网络的训练集和测试集是什么,也就是要指定训练集的输入特征x_train和训练集的标签y_train,还可以指定测试集的输入特征x_test和测试集的标签y_test

第三步,在Sequential()中搭建网络结构,逐层描述每层网络,相当于走了一遍前向传播

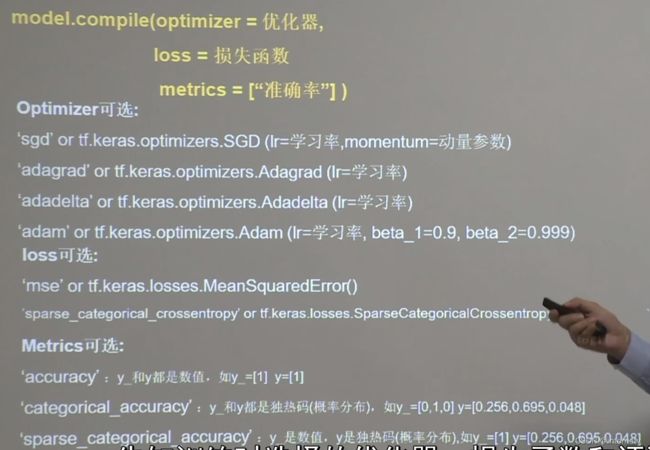

第四步,在compile配置训练方法,告知训练时选择哪种优化器,选择哪种损失函数,选择哪种评测指标

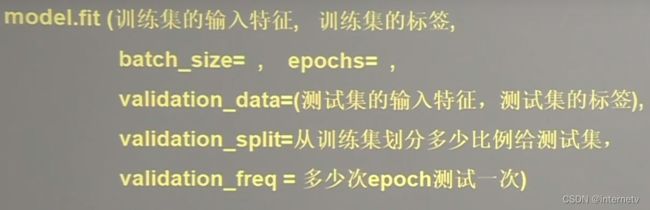

第五步,在fit中执行训练过程,告知训练集和测试集的输入特征和标签,告知每个batch是多少,告知要迭代多少次数据集

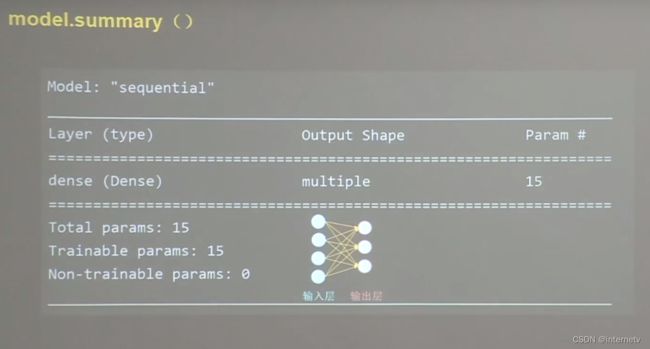

第六步,用summary()打印出网络的结构和参数统计

###########################################################################

Sequential()可以认为是个容器,内部封装了一个神经网络结构

拉直层:这一层不含计算,只是形状转换,把输入特征拉直变成一维数组

全连接层:告知神经元个数,激活函数,正则化方式

卷积层:

告知训练时选择的优化器,损失函数,评测指标

在设置损失函数loss时,tf.keras.losses.SparseCategoricalCrossentropy(from_logits=False)

from_logits:有些神经网络的输出是经过softmax等函数的概率分布,有些则不经概率分布直接输出。因此from_logits代表询问是否是原始输出,也就是没有经过概率分布的输出,

如果输出前经过了softmax等函数的概率分布,则from_logits=False

如果输出没有经过概率分布直接输出,则这里是True

后续例子都是以数值形式给出标签,以概率分布形式表示输出,所以应该选择sparse_categorical_accuracy作为评测指标

#############################################################################

对于二分类问题,评价指标可以用 binary_accuracy,就是最直观上讲的准确率。 当面对多分类或者多标签的任务时,评价度量可能会用到这两个 categorical_accuracy和 sparse_categorical_accuracy

举个栗子

如果有四个类,该样本属于第三类,那么在 categorical_accuracy 中 y_true =(0,0, 1, 0) , 而在 sparse_categorical_accuracy中 y_true = 2 (0-based计数)。但是,y_pred是一样的,均为softmax输出的vector,比如 y_pred = (0.02, 0.05, 0.83, 0.1),于是

y_true = (0, 0, 1, 0)

y_pred = (0.02, 0.05, 0.83, 0.1)

acc = categorical_accuracy(y_true, y_pred)

y_true = 2

y_pred = (0.02, 0.05, 0.83, 0.1)

acc = sparse_categorical_accuracy(y_true, y_pred)

#############################################################################

告知训练集的输入特征,告知训练集的标签,每次喂入神经网络的样本数batch_size数值,要迭代多少次数据集epochs总次数

validation_data:告知测试集的输入特征和测试集的标签

validation_split(两者二选一): 告知从训练集中划分多少比例数据给测试集

validation_freq:告知每迭代多少次数据集,使用测试集验证一下结果

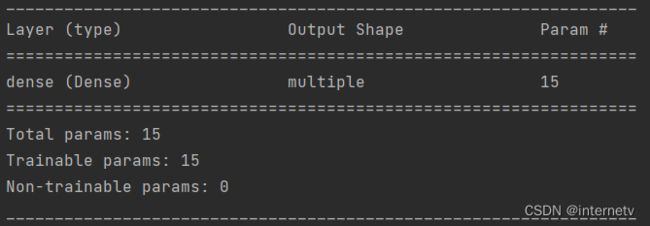

用summary()打印出网络的结构和参数统计

iris代码复现

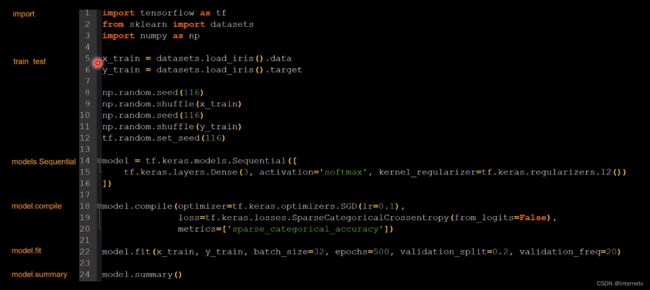

import tensorflow as tf

from sklearn import datasets

import numpy as np

# train test 标记训练集与测试集,此处应有的测试集分类放在了fit中

x_train = datasets.load_iris().data

y_train = datasets.load_iris().target

# 实现数据集乱序

np.random.seed(116)

np.random.shuffle(x_train)

np.random.seed(116)

np.random.shuffle(y_train)

tf.random.set_seed(116)

# models sequential 设置神经元个数 激活函数 正则化方式

model = tf.keras.models.Sequential([

tf.keras.layers.Dense(3, activation='softmax', kernel_regularizer=tf.keras.regularizers.l2())

])

# model compile 设置优化器(随机梯度下降法和学习率0.1),loss为交叉熵损失函数,评测指标 sparse_categorical_accuracy

model.compile(optimizer=tf.keras.optimizers.SGD(lr=0.1),

loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=False),

metrics=['sparse_categorical_accuracy'])

# model fit batch尺寸 500次数据集循环 validation_split:告知从训练集中划分多少比例数据给测试集 validation_freq:告知每迭代多少次数据集,使用测试集验证一下结果

model.fit(x_train, y_train, batch_size=32, epochs=500, validation_split=0.2, validation_freq=20)

model.summary()

############################################################################

这个地方的输出参数看不懂

loss损失率是0.3486,sparse_categorical_accuracy准确率是0.9583

############################################################################

使用sequential可以搭建出上层输出就是下层输入的顺序网络结构,但不能写出一些带有跳连的非顺序网络结构,这个时候我们可以选用类Class搭建神经网络结构

这个地方类似于java中的继承 继承了Python中的Model类

init函数搭建神经网络,call函数 调用实现神经网络前向传播

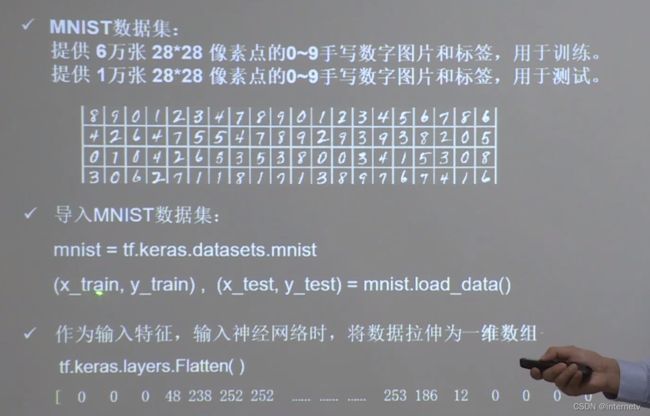

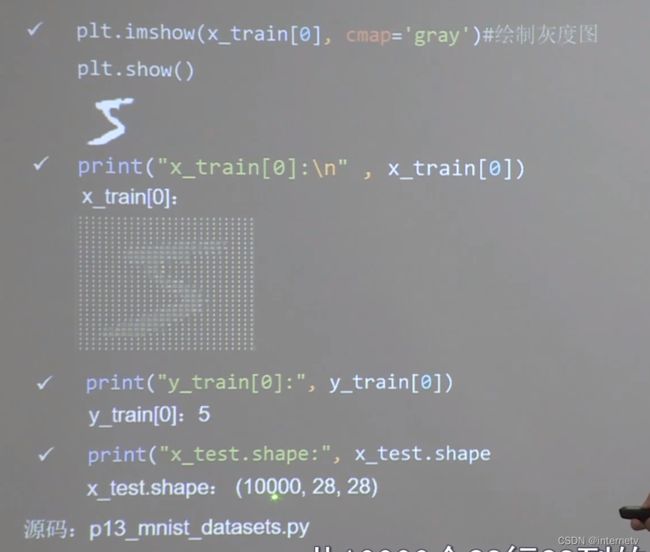

MNIST数据集

可以使用load_data()直接从mnist中读取MNIST数据集

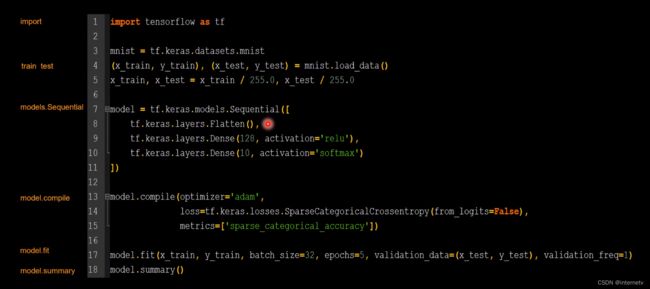

用Sequential实现手写数字识别训练仅用18行代码

import tensorflow as tf

mnist = tf.keras.datasets.mnist

(x_train, y_train), (x_test, y_test) = mnist.load_data()

# 对输入网络的输入特征进行归一化,使原本0~255的灰度值变为0~1之间的数值

x_train, x_test = x_train / 255.0, x_test / 255.0

# 用Sequential搭建神经网络,先把输入特征拉直为一维数组,也就是拉直为748个数值

# 定义第一个神经元128个 用relu激活函数

# 定义第二个神经元10个 用softmax使输出符合概率分布

model = tf.keras.models.Sequential([

tf.keras.layers.Flatten(),

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# model compile 设置优化adam,loss为交叉熵损失函数,评测指标 sparse_categorical_accuracy

# 注意:如果输出不是softmax不满足概率分布,则这里是true

model.compile(optimizer='adam',

loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=False),

metrics=['sparse_categorical_accuracy'])

model.fit(x_train, y_train, batch_size=32, epochs=5, validation_data=(x_test, y_test), validation_freq=1)

model.summary()

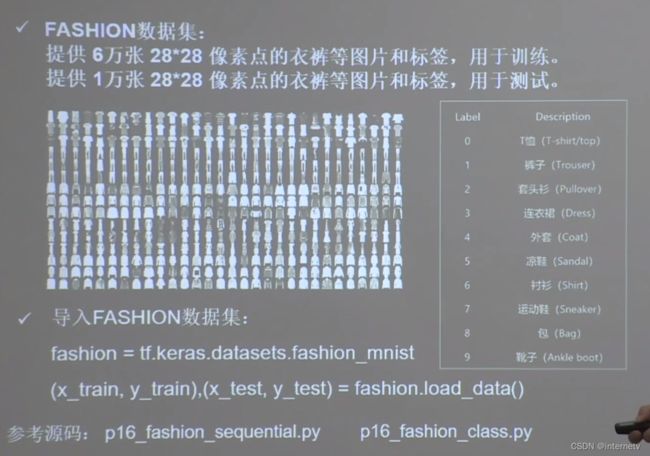

Fashion数据集

import tensorflow as tf

fashion = tf.keras.datasets.fashion_mnist

(x_train, y_train),(x_test, y_test) = fashion.load_data()

x_train, x_test = x_train / 255.0, x_test / 255.0

model = tf.keras.models.Sequential([

tf.keras.layers.Flatten(),

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

model.compile(optimizer='adam',

loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=False),

metrics=['sparse_categorical_accuracy'])

model.fit(x_train, y_train, batch_size=32, epochs=5, validation_data=(x_test, y_test), validation_freq=1)

model.summary()