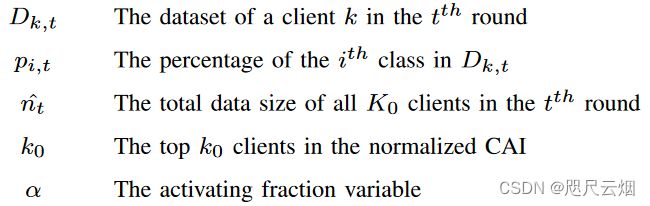

TrisaFed:异步联邦学习框架

A triple-step asynchronous federated learning mechanism for client activation, interaction optimization, and aggregation enhancement

每日一诗 《山中暮归·林端鸦阵横》

清·张廷玉

林端鸦阵横,烟外樵歌起。

疲驴缓缓行,斜阳在溪水。

-

- A triple-step asynchronous federated learning mechanism for client activation, interaction optimization, and aggregation enhancement

-

- 1.同步/异步联邦学习

- 2 AFL起步阶段三大挑战

-

-

- 2.1 如何合理地利用客户端(本地数据库不断扩充)来避免过度拟合?

-

- 2.1.1过度拟合

- 2.1.2欠拟合

- 2.2 如何在降低通信成本和提高模型性能的同时合理管理客户端-服务器交互

- 2.3 如何高效地聚合服务器接收到的异构参数来构建全局模型

-

- 3 Counter measures

-

-

- 3.1 Client Activation

- 3.2 Communication Optimization

- 3.3 Aggregation Enhancement

-

- TWF

- IWE

-

- 4.Algorithm

-

-

- 4.1 用户端

- 4.2 服务器端:

-

1.同步/异步联邦学习

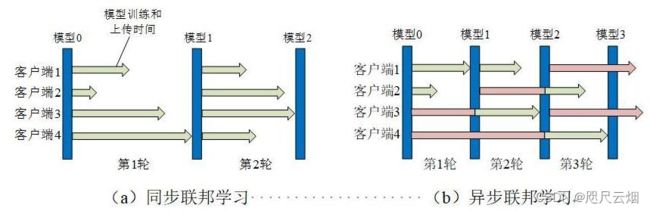

如图(a)所示,在同步联邦学习(SFL)中,每一轮训练需要等到所有参与设备的模型上传完成后,再进行模型汇聚。由于设备资源的差异和设备上训练数据的差异,速度较快的设备在每轮训练中必须等待速度较慢的设备,这极大降低了联邦学习训练效率。

如图(b)所示,在异步联邦学习(AFL)中,其模型汇聚服务器在收集到少量本地模型后立即进行全局聚合,避免受到速度较慢设备的拖累。

即同步FL (SFL),要求所有参与者步调一致; 异步FL (AFL),它使其参与者独立工作。

AFL在实际应用中更具有普适性,它能适应于设备不断变化(单个设备自身的硬件性能、添加去除设备、多异构设备协同)的现实场景,并极大地提升联邦学习的训练效率。

本文针对异步联邦学习固有的过度拟合、通讯受限、加权聚合等问题,提出了提出TrisaFed,针对三大挑战分别提出应对策略:ICA根据信息型客户端激活策略激活具有丰富信息的客户端、MLU多层更新策略来优化客户端和服务器的交互、时权退减策略(TWF)和丰富权重增强策略(IWE) 增强聚合函数。

2 AFL起步阶段三大挑战

2.1 如何合理地利用客户端(本地数据库不断扩充)来避免过度拟合?

在4V(volume, velocity, variety, and value)特征不同的客户端间收集的局部数据异构,解决过学习问题是具有挑战性的。

通过度量局部数据的多样性和局部模型的异质性来提高模型的准确性

2.1.1过度拟合

Overfitting 也被称为过度学习,过度拟合,它不能成功的表达除了训练数据以外的其他数据。该现象会对训练数据集有良好的适应性(损失函数小),但对新测试数据(测试集合)的适应性较差。

增加数据量,避免多次重复训练相同数据

正规化,添加惩罚函数或者dropout(在某轮次中随机弃用部分节点)

简化模型,防止模型过于复杂

多模型平均

减弱非独立同分布的影响

2.1.2欠拟合

所谓欠拟合(也就是神经网络不收敛),它的表现就是训练集上的性能表现很差,测试集的表现同样很差。

数据归一化处理

正则化方法

适当减小batch

| 训练集性能 | 测试集性能 | 改进 | |

|---|---|---|---|

| 欠拟合 | 差 | 差 | 归一化处理、正则化处理、减小batch |

| 过度拟合 | 好 | 差 | 增加数据量、正则化处理、简化模型、多模型参数平均 |

| 适度拟合 | 好 | 好 |

2.2 如何在降低通信成本和提高模型性能的同时合理管理客户端-服务器交互

在Iot中的通信资源有限,而设备数量众多

通过降低数据包大小(压缩)和数据上传频率来节省通信成本,在提升准确性和降低通信费用间做均衡。

2.3 如何高效地聚合服务器接收到的异构参数来构建全局模型

本地训练的模型的重要性、对全局模型的贡献度可能会不同,需要在服务器上充分测量,以高效有效地支持模型聚合

3 Counter measures

提出TrisaFed框架:

1)通过使用适当的数据激活客户端来解决过学习问题,

2)通过优化客户端-服务器交互模式来降低通信成本,

3)通过解决局部模型的异构性来增强模型聚合。

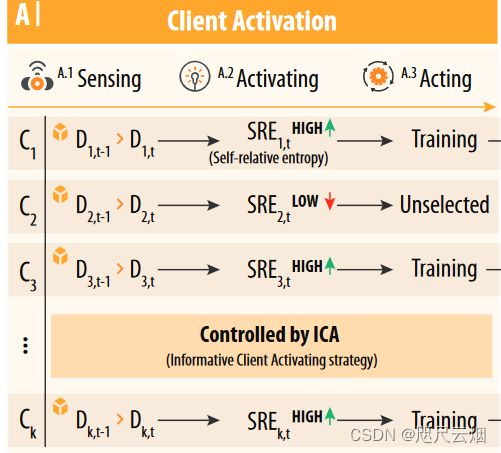

3.1 Client Activation

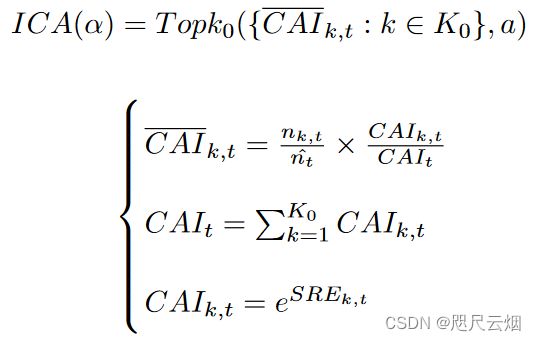

它根据信息客户端激活策略(ICA)从一个AFL聚类中选择感知数据逐渐增长的客户端,

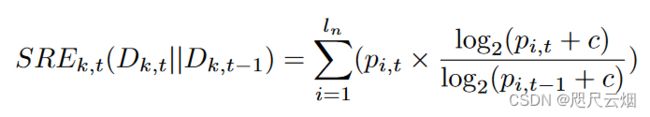

该策略基于自相对熵(SRE)排序的索引来衡量相邻迭代轮次间数据增长量的变化,SRE越大表示当前轮的数据集合比上一轮次变化更大。

选取top-k客户端参与后续进程。

如图所示,该步骤由三个阶段组成,即1)在每个客户端中积累数据的感知阶段,2)在具有足够新信息的客户端中选择激活阶段,3)在选定客户端中开始本地培训的行动阶段。值得注意的是,如果客户端没有被选中,它将继续感知数据,并等待后续回合的激活。

使用Kullback–Leibler Divergence量化信息丰富度来避免过度拟合。

SRE表示客户端k在t轮次中本地数据量相对于t-1轮次的数据增长情况。

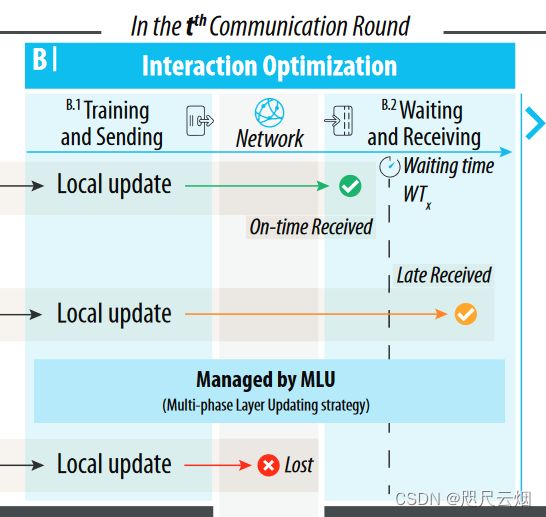

3.2 Communication Optimization

在深度神经网络学习中,采用多相层更新策略(MLU)优化了浅层和深层的更新频率,简化了客户端与服务器的交互。

如图所示,AFL客户端和服务器的发送和接收行为是无上限的。

有三种可能的情况,分别是:

1)未知故障,数据包丢失(对应的客户端无法对全局模型做出贡献); 图示Lost

2)准时成功,即在TTH通信轮的默认等待时间内接收到本地参数,并将在当前轮中用于模型聚合;

3)延迟成功,其中参数在默认时间之后接收。Late Received

为了优化客户端与服务器的交互,减少对本地资源的消耗,引入了区分浅层和深层DNN更新频率的多阶段层更新策略(Multi-phase Layer update strategy, MLU)。具体来说,MLU (M, M, n)将总共的M个通信轮分为M/m个阶段。此外,在每个阶段中,深度层只在最后n轮进行周期性更新以学习特定特征,而浅层层在所有m轮进行持续更新以学习一般特征。

通过深层次迭代次数的减少来较少通信开销

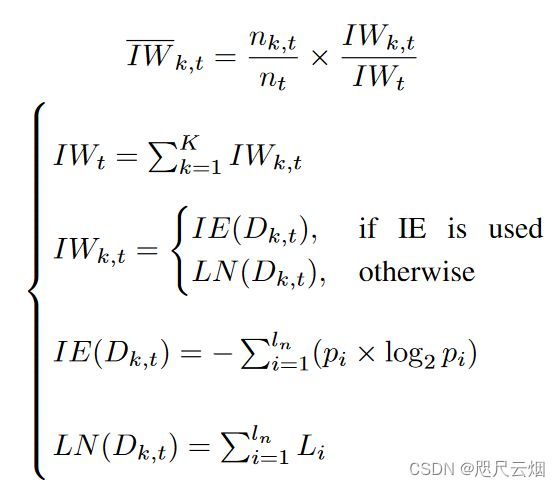

3.3 Aggregation Enhancement

它根据两种加权策略处理局部参数,即时间加权衰落策略(TWF)和信息加权增强策略(IWE),前者将局部参数根据创建时间的不同,以一个衰落的权值进行聚集,后者通过标签号(LN)或信息熵(IE)度量的权值来提取含有丰富信息的局部参数。

如图所示,对于M个层次(M, m, n),有两种聚合模式,即当前回合为1 ~ M - n个MLU阶段时浅层单独更新,当前回合为最后n个MLU阶段时浅层和深层联合更新。

此外,无论采用何种聚合方式,AFL服务器在一个通信回合中都会处理两种本地参数,

1)前几轮通信中生成的、至今未使用的参数,(Late Received)

2)当前回合接收到的参数。在此基础上,设计并实现两种加权策略,时间加权衰落策略(TWF)和信息加权增强策略(IWE)来聚合局部参数。

TWF

IWE

综上所述,TWF可以基于一种归一化的权值对客户端参数进行聚合,该权值根据参数生成时间与接收时间的时间差异而减小。此外,IWE与LN或IE可以根据相关参数的信息丰富程度提升其权重。最后,使用TWF和IWE-LN/IE可以显著提高学习性能。

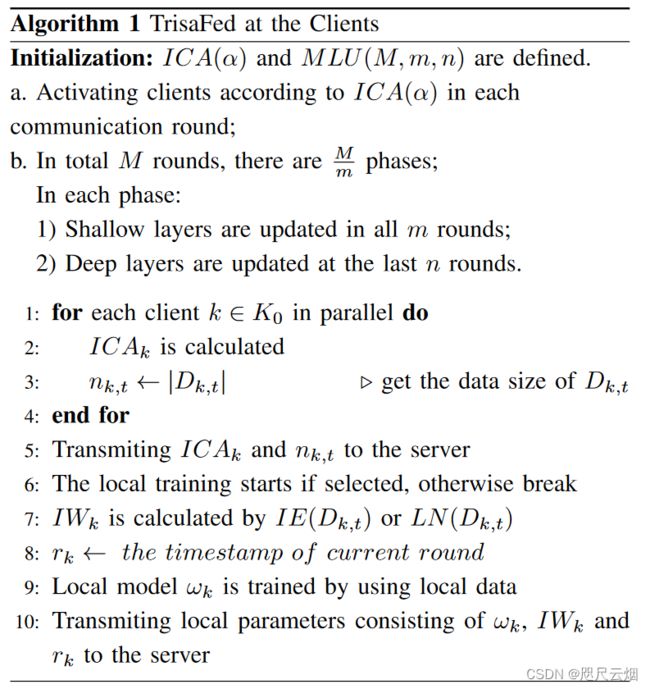

4.Algorithm

算法分为两个部分: 用户端和服务器端

4.1 用户端

初始化 ICA(α) 和 MLU(M,m,n)

根据ICA为每一轮更新选择top-k个客户端

共计M轮次,将他分成M/m个阶段: 在每一个阶段内 m轮次全部更新浅层神经网络, 最后n层更新浅层神经网络

1-4: 计算出t轮次的选中客户端和对应的数据集合大小

5:将ICA和n的值传递到服务器

6:如果客户端被选择 则开始本地更新 否则继续收集数据

7:计算IW

8:计算出完成传递后的时刻

9:本地模型更新

10:将更新参数传递给服务器,以便其聚合

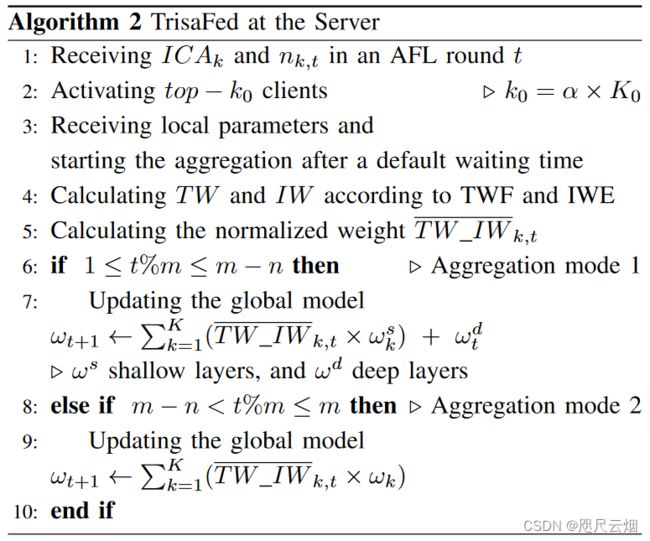

4.2 服务器端:

1-3: 接受参数、激活本轮次客户端、开始聚合

4-5: 计算TW 和IW 方便后续聚合、计算标准参数

6-10: 判断所处轮次 来对深层网咯和浅层网络进行聚合更新。

联邦学习的其它框架可以参考博主主页,感谢点赞支持!

链接点击跳转

Reference:

You, Linlin, et al. “A triple-step asynchronous federated learning mechanism for client activation, interaction optimization, and aggregation enhancement.” IEEE Internet of Things Journal (2022).

【概念学习】联邦学习的三个类别+【论文阅读】异步联邦学习

论文笔记—一种面向边缘计算的高效异步联邦学习机制