干货!浅谈文本生成的当下与未来

点击蓝字

关注我们

AI TIME欢迎每一位AI爱好者的加入!

6月26日,PhD Debate-3 就文本生成邀请了来自CMU、Mila 、阿里达摩院以及德克萨斯大学奥斯汀分校的博士们,与大家一起探讨文本生成的当下与未来。

一、文本生成能做什么?有哪些比较受关注的应用和任务?

图 1. 文本生成的任务

刘鹏飞博士从三个方面介绍文本生成任务:首先是主流任务,包括机器翻译、对话生成、文本摘要,其特点在于数据量大、标注多、应用面广;然后是新兴任务,包括对话摘要、会议摘要或基于会议的审稿生成,特点在于任务适应于当前新形势的需要,比如疫情导致线上会议增多,需要做自动生成摘要,或者投稿量增加,需要做自动审稿等新型任务;最后是类文本生成任务,由于文本生成框架通常是序列到序列的生成模型,而目前很多任务也都可以转为该形式,比如信息抽取任务也可以看做文本生成任务。

刘大一恒博士一方面从产业界应用的角度讨论了文本生成,比如AI写作,自动撰写新闻稿、金融财报、营销方案,或者电商行业对商品描述的改写、润色等,或是交互式写作,通过人机交互的方式撰写文章。另一方面从生成式数据增广的角度讨论了可利用文本生成的技术构建自然语言理解的训练数据,在一定程度上可提高模型鲁棒性。此外生成式检索也是一个应用方向。

徐嘉诚博士认为文本生成任务的衍生不仅得益于大量数据,同时新的模型结构也十分重要,比如在Transformer提出之前,编码或解码长文本或超长文本序列几乎是不可能的。此外,文本生成可看作是很多任务的载体,比如问答或者信息抽取任务,这主要得益于文本生成模型,可将结构化或预测形式的任务转化成对话或者问答形式。比如近期工作,Long Form QA通过读一篇或几篇长文章来回答问题,生成式问答也将成为一个热门研究方向。

付杰博士则从进化选择的角度讨论人类语言序列和生物序列生成异同,可将蛋白质看作句子,采用各种形式的语言模型来生成蛋白质序列或者新的蛋白质。2020年Salesforce 研究组提出的ProGen模型就是使用2.8亿条的蛋白质序列训练一个自回归语言模型,可用于生成新的蛋白质。

刘大一恒博士针对自然语言文本生成与生物信息生成总结了两点不同:

1)相较于自然语言文本生成,由于蛋白质种类较少则生物信息生成的字典量较小;

2)生物信息生成的序列较自然语言文本会非常长。

徐嘉诚则从评价指标上阐明两者的不同,自然语言文本生成通常采用ROUGE,BLUE等n-gram的方式评价某些词的符合度或者语义距离,而蛋白质结构更注重精度,比如某些序列子串的符合度。

刘鹏飞认为NLP在生物信息生成应用是具有前景的研究方向。

二、文本生成有哪些新的技术及特点?

图 2. 文本生成的新技术及特点

徐嘉诚博士认为可将文本生成分为回归模型和非回归模型两种形式,且以sequence-to-sequence为主流框架,模型结构上有强化学习,对抗生成网络等,在任务上可用于机器翻译、摘要或对话生成,以及视频或图像的描述生成等多模态任务。

近年来,新的技术无疑是大预训练模型,比如BART,T5等NLG型模型,其训练目标是预测第一句话或下一句话;经典的BERT等NLU型预训练模型更关注于去预测被mask的词。这使能预测一句话或者一段话的NLG型预训练模型在零样本、少样本或开放域场景应用上具有一定优势。同时,受制于模型结构和训练方式,依旧存在很多问题,比如训练时n-gram是否被提到,基于ground truth的训练方式导致模型在训练和测试时存在不一致性等问题。

刘鹏飞博士基于自身研究背景介绍了他们组在CNN/Daily Mail榜单上的三项工作,均排名前三且都是两阶段系统,这主要包含两点:第一点,鹏飞博士认为在摘要生成中端到端模型可能是非必需的,并且目前最强的预训练模型也不能达到最好的结果;第二点,可根据平行语料对生成监督信号,监督信号可用两次,两次学习是互补的。即,在第一阶段使用预训练模型+微调,采用传统ML1 loss训练,在第二阶段使用对比学习,采用Ranking loss训练。

刘大一恒博士针对模型结构进行补充,认为当前文本生成可分为多个阶段,常用的是采用sequence-to-sequence预训练模型作为底座,然后如文章《Do not stop pre-training》的思想,基于通用场景的文本预训练模型在特定领域语料上进行continue pre-training,最后根据具体任务再设计自监督学习的训练目标。

比如,在金融领域的文本摘要任务上,首先在金融领域语料上进行预训练,然后采用抽取式摘要的方法抽取摘要中关键句子,使模型预测该句子,最后采用真实数据进行微调。此外,如鹏飞提到的两阶段模型生成任务,可先抽取关键词或通过检索的方法抽取类似template的文本,以此作为模型输入。在解码层面上,若需要多样化生成或对文本生成有特殊属性上的要求,也可在解码层做很多工作,比如可控式文本生成。还有一部分类似无监督的生成任务,可对文本隐空间进行编辑,如PPLM。

付杰博士针对模型结构谈到,目前大多数模型都基于Transformer进行研究,但模型结构很大且参数量很多,很难训练全部参数。LSTM的提出者Schmidhuber认为任何一个大的网络实则有很多小网络,这说明小网络之间参数可互用,如果可以找到小网络,并经过预训练,可对某个小的子部分做微调,则不会更新其他无关参数,这在一定程度上可以防止遗忘。

刘大一恒博士补充到,针对零样本场景的摘要生成,通常人为给一个提示,比如“请翻译这句话”,再使用GPT3,BART,T5等预训练模型生成;而近期的工作P-tuning,其思想是固定预训练模型的参数,通过梯度优化只优化前缀,相当于将前缀作为随机初始化的word-embedding或者小网络,插到预训练模型之前进行训练,可实现即插即用,一定程度上也能缓解遗忘。

徐嘉诚博士补充到,在做可控式文本生成时,通常将主模型微调到一个小数据集上,或者增加小模型修改主模型预测的结果,这两种方式可作为一种载体,承接多种形式,比如classifier。

刘鹏飞博士认为,类似Prefix-tuning或者P-tuning,只需微调模型的一部分参数,更像是一个适配器,但这种做法未必使模型的性能变的更好 (往往是基于其它动机,比如节省参数,加速训练),而微调模型的全部参数往往能使模型性能更好,但很多时候不能获得模型全部参数。

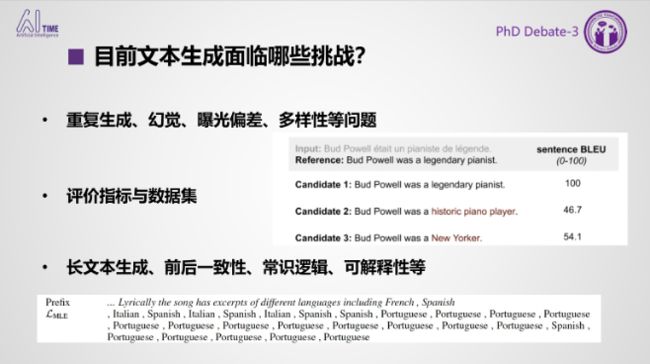

三、目前文本生成面临哪些挑战?

图 3. 文本生成面临的挑战

刘大一恒博士认为,第一是重复生成,一方面在输入端过度复制上下文,另一方面会局部反复出现一些n-grams,导致文本多样性差,可读性差;第二是生成文本缺乏逻辑一致性,或者生成不符合事实常识的文本,比如在翻译,Table-to-Text的一些任务上;第三是生成结果自动化的评价标准,常用的是BLUE或者ROUGE,这样的评价标准,然而通过字词层面的共现评价生成结果,不能准确表达同一个字词在不同语境中的意思,影响评价结果。

刘鹏飞博士则基于文本生成的评估做了补充,鹏飞博士认为主要存在以下四点挑战:

第一,在评估文本时,往往只关注一个方面,比如语义接近度,而判断生成结果好坏应该有很多标准,即多角度评估,比如事实准确性,连贯性。目前已经存在单独一个指标解决一个角度评估,而设计一个指标就能解决多角度评估问题仍待研究,这也是目前我们研究的重点。

第二,开发包的开发,现在的评价工具包欠发展,可考虑在开发包上做一些工作,比如ROUGE评价包。

第三,可解释的评估方法,现有的评估方法是整体结果的理解,但没有反映出模型好坏,则需要指标可更好理解模型的内容。

第四,类似Meta-evaluation,评价评价指标的可靠性。

徐嘉诚博士补充到,一方面,评价评价指标的工作十分有影响力,将通用型指标分解成不同角度的评价,可提高对文本生成模型的认识;另一方面,相比较于使用ROUGE这种基于规则的评价方式,基于模型的评价方式例如BERTScore也是评价方面有意思的研究点。

此外,嘉诚博士针对模型的可解释性展开讨论,当模型生成一句话时,则希望理解模型为什么说这句话,这是一个非常复杂的序列化决策过程,难度也超过NLU,其意义在于能更好理解模型作出决策的原因。

付杰博士则从生成多样性的角度讨论目前的挑战:第一,与人类自然语言不同,在生物领域,比如需要根据一个很短的输入生成一万个多样化的序列,即便每一个序列的有效性比较高,但一旦预测错误,整个batch生成的序列全都没有用,代价十分之大。如何生成一个非常大batch的多样化序列,且每一个序列在语义层面都是不同的,而不仅仅是每一个字段不一样,也是十分具有挑战性。第二,与文本多样化评估不同,在生物领域如何去评估生成序列多样化,这需要的是将一万个序列作为一个popularity进行评估。

刘大一恒博士针对文本多样性补充到,主要存在三种方式:第一,引入额外的限制或条件,比如额外考虑特定的关键字、属性、主题等;第二,在解码层面上来增加多样性,比如,diverse decoding或对解码做一定限制,或类似采样Top-P等方法;第三,修改模型的表示,在输出的时候引入噪音或有指导性的信息对隐变量编辑。

四、畅享文本生的未来

图 4. 文本生成的未来

付杰博士,基于自身研究工作探讨了蛋白质、药物生成任务。近两年,Facebook,Salesforce等大公司也将标准的自然语言模型直接用于生成蛋白质或蛋白质补全。一方面,较新的任务如ProGen文章提出,即便语言模型只见过很长的蛋白质序列而没有见过三维结构,通过在2.8亿蛋白质序列上训练一个很大的自回归模型,也能学习到一定蛋白质三维结构知识。另一方面,类似经典任务DTI,基于conditional 目标如何生成新的药物也会成为未来发展趋势。

刘大一恒博士主要从输入-模型-输出的角度探讨未来发展方向。首先,在输入端,会有更新颖的输入方式,比如多模态,结构化数据,图表、数值等;其次,输出端的输出方式更加多样化,比如,单/多语言、音乐、蛋白质、代码等特定语言生成;最后,研究更具有可解释,对显存更友好,计算更高效,更有利于长文本生成的模型,会成为模型层面的发展方向。

徐嘉诚博士认为起初文本摘要任务多集中在新闻文本摘要,但近两年,随着新问题新任务新数据集的衍生,带来了很多文本生成新的挑战,比如,会议摘要。目前最值得关注的点会是生成文章是否符合文章意思或者常识等。此外,在工业界,文本生成在短期内可能还是以一种template based slot filling的形式存在,因此完成从纯模板到有神经网络模型,NLG,NLU几个模块写作生成,以及未来完全开放式生成,这其中的转型十分excited 。

刘鹏飞博士认为,一方面,未来文本生成的方向应该会是基于大规模预训练模型构建一个具有适配的微调策略,基于此,值得的研究点包括:第一,数据集的收集,根据任务不同也会面临常规问题和新型问题,比如如果要训练一个自动审稿系统,就要考虑如何收集高质量的人工审稿意见。第二,评估问题,结合具体任务做评估(这个一般需要从多角度对生成文本进行评估);第三,相较而言模型建模并不显得特别重要,但需保证有足够GPU计算资源。

另一方面,根据目前新型技术需要、新型数据生成,尝试探索未来新型文本生成任务,比如,meeting 摘要。此外,多语言文本生成也是未来发展方向。

整理:刘美珍

审稿:刘鹏飞、付杰、刘大一恒、徐嘉诚

AI TIME欢迎AI领域学者投稿,期待大家剖析学科历史发展和前沿技术。针对热门话题,我们将邀请专家一起论道。同时,我们也长期招募优质的撰稿人,顶级的平台需要顶级的你!

请将简历等信息发至[email protected]!

微信联系:AITIME_HY

AI TIME是清华大学计算机系一群关注人工智能发展,并有思想情怀的青年学者们创办的圈子,旨在发扬科学思辨精神,邀请各界人士对人工智能理论、算法、场景、应用的本质问题进行探索,加强思想碰撞,打造一个知识分享的聚集地。

更多资讯请扫码关注

(点击“阅读原文”查看精彩回放)