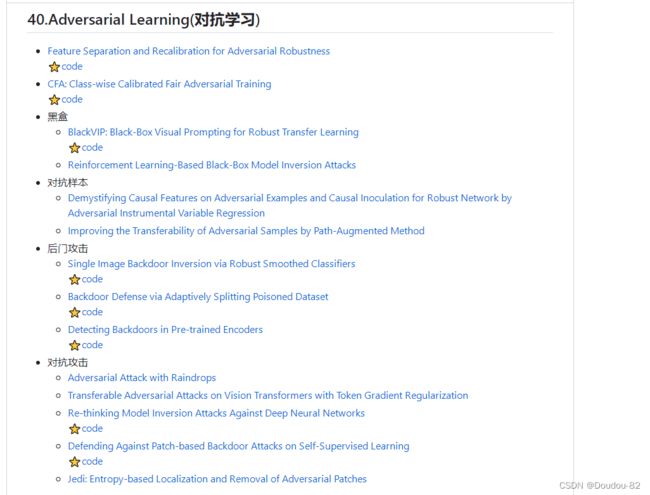

CVPR2023对抗攻击相关论文

Feature Separation and Recalibration for Adversarial Robustness

论文链接:http://arxiv.org/abs/2303.13846v1

代码地址:GitHub - wkim97/FSR: Feature Separation and Recalibration (CVPR 2023)

摘要:由于特征层面的扰动积累,深度神经网络容易受到对抗性攻击,许多研究通过停用导致模型错误预测的非鲁棒特征激活来提高模型的鲁棒性。然而,我们声称这些恶意激活仍然包含判别线索,并且通过重新校准,它们可以捕获额外的有用信息以进行正确的模型预测。为此,我们提出了一种新颖的,易于插件的方法,称为特征分离和重新校准(FSR),它通过分离和重新校准来重新校准恶意的,非鲁棒的激活,以获得更鲁棒的特征映射。分离部分将输入特征映射分解为具有帮助模型做出正确预测的激活的鲁棒特征和具有在对抗性攻击时导致模型错误预测的激活的非鲁棒特征。然后,重新校准部分调整非鲁棒激活,以恢复模型预测的潜在有用线索。大量的实验验证了FSR与传统失活技术相比的优越性,并表明它在计算开销较小的情况下将现有对抗性训练方法的鲁棒性提高了8.57%。

CFA: Class-wise Calibrated Fair Adversarial Training

论文链接:http://arxiv.org/abs/2303.14460v1

代码地址:GitHub - PKU-ML/CFA

摘要:对抗训练被广泛认为是提高深度神经网络(DNN)对对抗示例的对抗鲁棒性的最有效方法。到目前为止,大多数现有的工作都集中在增强整体模型的鲁棒性上,在训练和测试阶段平等地对待每个类。虽然揭示了类之间鲁棒性的差异,但很少有作品试图在不牺牲整体鲁棒性的情况下使类水平上的对抗性训练公平。在本文中,我们首先从理论上和经验上研究了不同类别对对抗配置的偏好,包括扰动边际、正则化和加权平均。受此启发,我们进一步提出了一个分类校准公平对抗训练框架,命名为CFA,它自动为每个类别定制特定的训练配置。在基准数据集上的实验表明,与其他最先进的方法相比,我们提出的CFA可以显著提高整体鲁棒性和公平性。

BlackVIP: Black-Box Visual Prompting for Robust Transfer Learning

论文链接:http://arxiv.org/abs/2303.14773v1

代码地址:GitHub - changdaeoh/BlackVIP: Official implementation for CVPR'23 paper "BlackVIP: Black-Box Visual Prompting for Robust Transfer Learning"

摘要:随着大规模预训练模型(PTMs)的激增,对这些模型进行微调以适应众多下游任务成为一个关键问题。因此,大型模型的参数高效迁移学习(PETL)受到了广泛的关注。虽然最近的PETL方法展示了令人印象深刻的性能,但它们依赖于乐观的假设:1)PTM的整个参数集是可用的,2)为微调配备了足够大的内存容量。然而,在大多数现实世界的应用程序中,PTM 被用作黑盒API或专有软件,没有明确的参数可访问性。此外,现代 PTM 很难满足大容量的内存需求。在这项工作中,我们提出了黑盒视觉提示(BlackVIP),它可以在不了解模型体系结构和参数的情况下有效地适应PTM 。BlackVIP有两个组成部分;1)协调器 和2)梯度校正同步摄动随机逼近(SPSA-GC)。协调器设计了依赖于输入的图像形视觉提示,提高了对分布/位置移动的少镜头适应和鲁棒性。SPSA-GC可以有效地估计目标模型的梯度来更新协调器。在16个数据集上进行的大量实验表明,BlackVIP能够在不访问PTMs参数的情况下对不同领域进行鲁棒适应,并且内存需求最小。

Reinforcement Learning-Based Black-Box Model Inversion Attacks

论文链接:http://arxiv.org/abs/2304.04625v1

摘要:模型反转攻击是一种隐私攻击,仅通过访问模型来重建用于训练机器学习模型的私有数据。近年来,利用生成对抗网络(GANs)从公共数据集中提取知识的白盒模型反转攻击因其优异的攻击性能而受到广泛关注。另一方面,目前利用gan的黑盒模型反转攻击存在无法保证在预定的查询访问次数内完成攻击过程或无法达到与白盒攻击相同的性能水平等问题。为了克服这些限制,我们提出了一种基于强化学习的黑盒模型反转攻击。我们将潜在空间搜索描述为马尔可夫决策过程(MDP)问题,并使用强化学习来解决它。我们的方法利用生成图像的置信度分数为代理提供奖励。最后,利用在MDP中训练的智能体找到的潜在向量来重构私有数据。在各种数据集和模型上的实验结果表明,我们的攻击成功地恢复了目标模型的私有信息,达到了最先进的攻击性能。我们通过提出一种更先进的黑盒模型反转攻击来强调隐私保护机器学习研究的重要性。

Demystifying Causal Features on Adversarial Examples and Causal Inoculation

for Robust Network by Adversarial Instrumental Variable Regression

论文链接:https://arxiv.org/abs/2303.01052

摘要:对抗样本的起源在研究领域仍然是一个难以解释的问题,虽然研究比较全面,但也引起了各种观点的争论。在本文中,我们提出了一种从因果角度深入研究对抗训练网络中意外脆弱性的方法,即对抗工具变量(IV)回归。通过部署它,我们估计了在与未知混杂因素分离的无偏环境下对抗性预测的因果关系。我们的方法旨在通过利用随机特征估计器(即假设模型)和最坏情况反事实(即测试函数)之间的零和优化游戏来寻找因果特征,从而揭开对抗性示例中固有因果特征的神秘面纱。通过广泛的分析,我们证明了估计的因果特征与对抗性鲁棒性的正确预测高度相关,而反事实表现出明显偏离正确预测的极端特征。此外,我们提出了如何有效地将因果特征(CAFE)接种到防御网络中以提高对抗鲁棒性。

Improving the Transferability of Adversarial Samples by Path-Augmented Method

论文链接:http://arxiv.org/abs/2303.15735v1

摘要:深度神经网络在多种视觉任务上取得了前所未有的成功。然而,它们很容易受到人类无法察觉的敌对噪音的影响。这种现象会对它们在实际场景中的部署产生负面影响,尤其是与安全相关的场景。为了在实践中评估目标模型的鲁棒性,基于迁移的攻击利用局部模型制作对抗样本,并因其高效率而越来越受到研究人员的关注。最先进的基于迁移的攻击通常是基于数据增强的,它通常在学习对抗样本时从线性路径增强多个训练图像。然而,这些方法启发式地选择了图像增强路径,并且可能会增强与目标图像语义不一致的图像,这损害了生成的对抗样本的可迁移性。为了克服这一缺陷,我们提出了路径增强方法(PAM)。具体来说,PAM首先构造一个候选增强路径池。然后用贪婪搜索确定对抗样本生成过程中所使用的增强路径。此外,为了避免增强语义不一致的图像,我们训练了一个语义预测器(SP)来约束增强路径的长度。大量的实验证实,在攻击成功率方面,与最先进的基线相比,PAM可以实现平均超过4.8%的改进。

Adversarial Attack with Raindrops

论文链接:https://arxiv.org/pdf/2302.14267.pdf

摘要:众所周知,深度神经网络(DNN)容易受到对抗样本的攻击,这些对抗样本通常是人为设计来欺骗DNN的,但在现实世界中很少存在。在本文中,我们研究了由雨滴引起的对抗样本,以证明存在大量的自然现象能够作为DNN的对抗性攻击者。此外,我们提出了一种新的方法来生成对抗雨滴,表示为AdvRD,使用生成对抗网络(GAN)技术来模拟自然雨滴。我们的AdvRD制作的图像看起来与现实世界的雨滴图像非常相似,在统计上接近真实雨滴图像的分布,更重要的是,它可以对最先进的DNN模型进行强烈的对抗攻击。另一方面,我们证明了使用AdvRD图像的对抗性训练可以显著提高DNN对现实世界雨滴攻击的鲁棒性。大量的实验表明,AdvRD制作的图像在视觉上和统计上接近自然雨滴图像,可以作为DNN模型的强攻击者,也有助于提高DNN对雨滴攻击的鲁棒性。

Transferable Adversarial Attacks on Vision Transformers with Token Gradient Regularization

论文链接:http://arxiv.org/abs/2303.15754v1

摘要:Vision transformers(ViTs)已经成功地部署在各种计算机视觉任务中,但它们仍然容易受到对抗样本的攻击。基于迁移的攻击是利用局部模型生成对抗样本,并将其直接迁移攻击目标黑盒模型。基于迁移的攻击效率高,对基于虚拟网关的应用构成了严重的安全威胁。因此,在安全敏感的场景下,设计有效的基于迁移的攻击,提前识别ViT的不足是至关重要的。现有的工作一般集中在正则化输入梯度以稳定对抗样本的更新方向方面。然而,在ViT的中间块中,反向传播梯度的方差仍然可能很大,这可能会使生成的对抗样本专注于某些特定于模型的特征,而陷入较差的局部最优。为了克服现有方法的不足,我们提出了Token Gradient Regularization(TGR)方法。根据ViT的结构特点,TGR以标记方式减少ViT内部各块中反向传播梯度的方差,并利用正则化梯度生成对抗性样本。大量攻击ViT和CNN的实验证实了我们方法的优越性。值得注意的是,与最先进的基于迁移的攻击相比,我们的TGR平均提供了8.8%的性能改进。

Re-thinking Model Inversion Attacks Against Deep Neural Networks

论文链接:http://arxiv.org/abs/2304.01669v1

代码地址:Re-thinking Model Inversion Attacks Against Deep Neural Networks

摘要:模型反转(MI)攻击的目的是通过滥用对模型的访问来推断和重构私有训练数据。人工智能攻击引起了人们对敏感信息泄露的担忧(例如,在训练人脸识别系统时使用的私人人脸图像)。近年来,为了提高攻击性能,人们提出了几种机器学习算法。在这项工作中,我们重新审视了智能智能,研究了与所有最先进的(SOTA)智能智能算法相关的两个基本问题,并提出了解决这些问题的方案,这些问题导致所有SOTA智能智能的攻击性能显著提高。特别是,我们的贡献有两个方面:1)我们分析了SOTA智能智能算法的优化目标,认为该目标对于实现智能智能来说是次优的,并提出了一个改进的优化目标,显著提高了攻击性能。2)我们分析了“MI过拟合”,发现它会阻碍重建图像学习训练数据的语义,并提出了一种新的“模型增强”思想来克服这一问题。我们提出的解决方案简单,并显着提高了所有SOTA MI攻击的准确性。例如,在标准的CelebA基准测试中,我们的解决方案将准确率提高了11.8%,并首次实现了超过90%的攻击准确率。我们的研究结果表明,从深度学习模型中泄露敏感信息存在明显的风险。我们敦促认真考虑对隐私的影响。

Defending Against Patch-based Backdoor Attacks on Self-Supervised Learning

论文链接:http://arxiv.org/abs/2304.01482v1

代码地址:GitHub - UCDvision/PatchSearch: Code for the CVPR '23 paper, "Defending Against Patch-based Data Poisoning Backdoor Attacks on Self-Supervised Learning"

摘要:最近,自监督学习(SSL)被证明容易受到基于补丁的数据中毒后门攻击。攻击者可以毒害一小部分未标记的数据,以便当受害者在其上训练SSL模型时,最终模型将具有攻击者可以利用的后门。这项工作旨在保护自监督学习免受此类攻击。我们使用三步防御管道,首先在有毒数据上训练模型。在第二步中,我们提出的防御算法(PatchSearch)使用训练好的模型来搜索训练数据中的有毒样本,并将它们从训练集中移除。第三步,在清理后的训练集上训练最终模型。我们的结果表明,PatchSearch是一种有效的防御方法。作为一个样本,它将模型对包含触发器的图像的准确率从38.2%提高到63.7%,非常接近clean模型的准确率64.6%。此外,我们还表明,PatchSearch优于基线和最先进的防御方法,包括那些使用额外干净、可信数据的方法。

Jedi: Entropy-based Localization and Removal of Adversarial Patches

论文链接:http://arxiv.org/abs/2304.10029v1

摘要:在各种计算机视觉应用中,现实世界的对抗性物理补丁被证明在妥协最先进的模型中是成功的。基于输入梯度或特征分析的现有防御已经被最近基于 GAN 的攻击所破坏,这些攻击会产生自然补丁。在本文中,我们提出了Jedi,这是一种针对对抗性补丁的新防御,它对现实补丁攻击具有弹性。Jedi从信息论的角度解决了补丁定位问题;利用两个新的思想:(1)利用熵分析改进了潜在斑块区域的识别:我们发现即使在自然斑块中,对抗斑块的熵也很高;(2)使用能够从高熵核中完成补丁区域的自编码器,提高了对抗性补丁的定位。Jedi实现了高精度的对抗性补丁定位,这对于成功修复图像至关重要。由于Jedi依赖于输入熵分析,因此它是模型不可知的,并且可以应用于预训练的现成模型,而无需更改受保护模型的训练或推理。Jedi在不同的基准测试中平均检测到90%的对抗补丁,并恢复高达94%的成功补丁攻击(相比之下,LGS和Jujutsu分别为75%和65%)。

Single Image Backdoor Inversion via Robust Smoothed Classifiers

论文链接:https://arxiv.org/pdf/2303.00215.pdf

Backdoor Defense via Adaptively Splitting Poisoned Dataset

论文链接:http://arxiv.org/abs/2303.12993v1

代码地址:GitHub - KuofengGao/ASD: [CVPR 2023] Backdoor Defense via Adaptively Splitting Poisoned Dataset

Detecting Backdoors in Pre-trained Encoders

论文链接:http://arxiv.org/abs/2303.15180v1

代码地址:https://github.com/GiantSeaweed/DECREE