联想基于OpenStack的高可用企业云平台实践

本文转自CSDN首页,如有侵权请及时和我联系,马上删除。

原文地址: http://www.csdn.net/article/2015-09-17/2825729

摘要: 联想IT选择了基于OpenStack承载其“互联网”战略的企业云平台。经过半年多的实践,联想已经建设成为规模超过3000 Core的OpenStack生产级环境,数据以最高10TB/天的速度快速增长,并计划在年内将20% IT系统迁移到云。

【编者按】在《InfoWorld》评选的年度最佳开源平台、基础设施、管理和编排软件中,Container相关的软件上榜无数,而OpenStack榜上无名,但这并不意味着IaaS的没落,它仍是云的基石,只是在国外已经比较成熟。但在中国市场,说得上的OpenStack案例,往往来自互联网公司,尽管有企业就绪的呼声,传统行业对OpenStack仍然观望居多。本文介绍了IT大厂联想集团基于OpenStack构建私有云的转型实践,从技术架构和业务应用层面,验证了OpenStack的企业级高可用。尽管OpenStack承载的仍是互联网业务,但联想计划在年内将20%的IT系统迁移到云,这是难能可贵的一大步。

在走向移动化、社交网络的过程中,无论传统的PC与手机都经历着激烈的竞争及快速的技术转变。在面临市场的飞速演变与竞争中,联想集团提出了从产品导向到用户导向转型的新战略。而只有可快速迭代、弹性扩展的企业云平台才能够支撑联想这种业务创新的需求。经过慎重研究与评估后,联想IT选择了基于OpenStack承载其“互联网”战略的企业云平台。经过半年多的实践,已经建设成为规模超过3000 Core的OpenStack生产级环境,数据以最高10TB/天的速度快速增长,并计划在年内将10%~20% IT负载迁移到云环境。

转型与云选型

以往的联想的内部IT主要面向大型客户以及渠道为主,系统架构以包括IBM Power小机、AIX、PowerVM、DB2及近年普遍使用的VMware虚拟化的传统IT架构构建而成。在向互联网企业转型的过程中,首先在用户数与交易量就远远无法支撑全新的B2C的业务。其次在成本方面,联想以往的IT架构是大规模采用商用化的解决方案,可靠但不便扩展且成本昂贵。

此外,对于IT团队的效率与安全合规性,传统的IT架构仍然无法支撑起联想面向电商与移动新业务转型。2015年,联想IT进入到基础架构再造的阶段——需要采用新的云计算平台来支撑新的业务。

在选型过程中,联想对主流的x86虚拟化技术、私有云平台、公有云进行了全面分析与对比后,联想从稳定性、可用性、开放性、以及生态系统的全面与活跃度等因素考虑,最终认为OpenStack云平台技术可以满足联想的企业需求,联想确定采用OpenStack作为其业务持续创新的基础云平台。

在OpenStack架构设计之初,联想就考虑了容灾方案,包括虚机、云硬盘、数据库等,确保在发生故障时可以迅速切换,确保业务的高可靠性。

高可用的架构设计

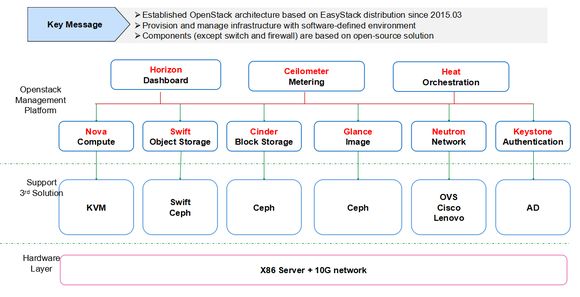

在逻辑架构上,联想企业云平台完全通过软件定义环境的方式来管理基础架构,底层采用x86服务器以及10Gb网络,引入互联网式的监控运维解决方案,并用OpenStack平台来管理所有资源。

联想企业云逻辑架构

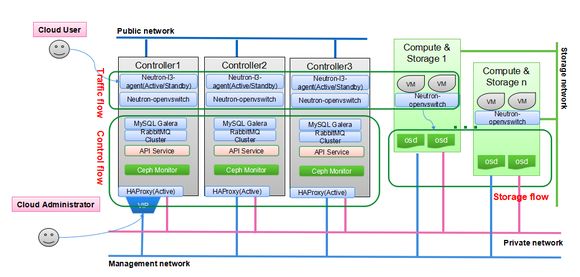

出于高可用角度、最大化的提升云平台的系统效率,联想设计了云平台的物理架构,并采用高配置的服务器来构成计算、存储与网络一体的超融合系统,通过OpenStack整合为统一的资源池,将计算节点和存储节点放在同一个物理节点上。

联想企业云物理架构

硬件层面,双路的System X3650服务器,以及四路的ThinkServer RQ940,成为了联想企业云平台的硬件支柱。每节点用5个SSD硬盘与12个SAS硬盘来构成存储模块;SSD不仅用来做存储的缓冲,也是高性能存储池资源;并通过VM访问分布式存储,来实现系统的高可用性。

为了将OpenStack提升至企业级服务水平,联想在计算、网络、存储等方面解决了很多挑战。

计算

在计算方面,联想采用高密度的虚机部署方式,底层基于KVM 虚拟化技术,通过多种优化手段,发挥物理机最大性能,在计算存储融合架构下对CPU,内存等硬件资源做隔离。最终实现在每台双路CPU计算节点上保证50+虚机仍能平稳高效运行。

另外,在云环境里面一般提倡应用程序自身高可用来应对硬件故障,但仍然有一些应用属于传统应用,对于单个主机的可用性还有要求。对于不能做高可用的传统应用,联想通过Compute HA技术实现了计算节点的高可用,通过多种检测手段判定计算结点是否发生故障,将故障物理机上的虚机迁到其它可用的物理机上,整个过程无人值守,最大程度减少因为物理机故障导致的业务中断。

网络

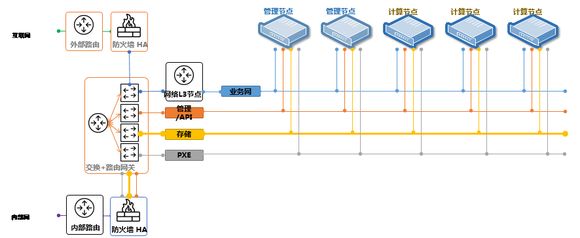

l 网络隔离

使用不同网卡,不同交换机或不同VLAN将各种网络隔离,如:单独的OpenStack管理网,虚机生产网络,存储网络,公网,PXE网络。避免网络相互干扰,达到提高整体带宽和更好监控网络的目的。

联想OpenStack企业云平台网络架构

l 多Public网络

通过多个Public网络实现网络灵活性,便于管理安全策略。比如联通Public网络,电信Public网络,办公Public网络。

l 网络及优化

使用VLAN网络模式,与传统数据中心网络更好的整合,通过优化VLAN数据包处理,达到很好的网络数据包处理能力,让虚机网络带宽接近物理网络带宽。

l 双网卡绑定,多交换机

通过双网卡绑定到不同的交换机达到物理网络的高可用。

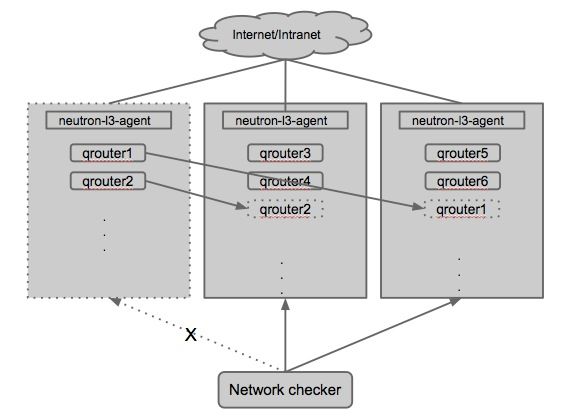

l 网络节点HA

通过多个网络节点,实现公网的负载均衡及HA,实现高性能和高可用, 网络节点使用Router级别的Active/Standby方式实现HA,使用独立的网络路由监控服务确保网络HA的稳定性。

存储

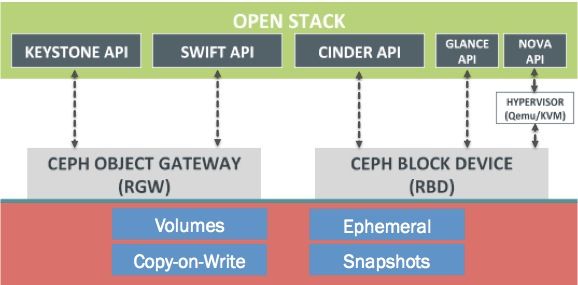

联想OpenStack云平台采用Ceph作为统一存储后端,其中Glance镜像、Nova虚拟机系统盘、Cinder云硬盘的数据存储由Ceph RBD提供,利用Ceph的Copy on Write特性,通过修改OpenStack代码,可做到秒级虚拟机部署。

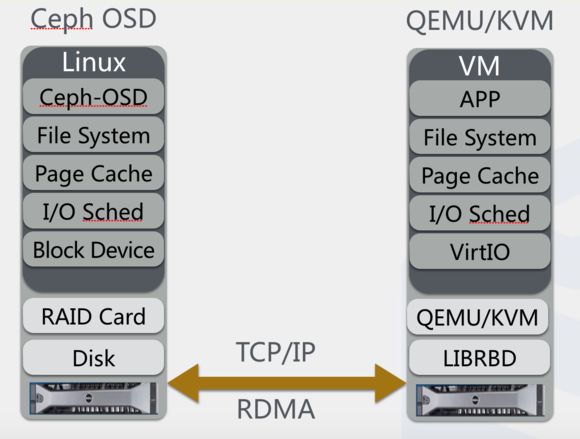

Ceph作为统一存储后端,其性能无疑是企业核心应用是否虚拟化、云化的关键指标之一。在计算存储共同运行的超融合部署架构中,存储性能调优既要最大化存储性能、又要保证计算和存储资源的隔离,保证系统的稳定性。针对如下图所示的整个IO栈,联想从下往上,对各层进行了优化:

l 网络方面

打开Jumbo帧,提高数据传输效率;同时可采用10Gb以太网络来承载Ceph Cluster网络的流量,提高Ceph数据复制效率。

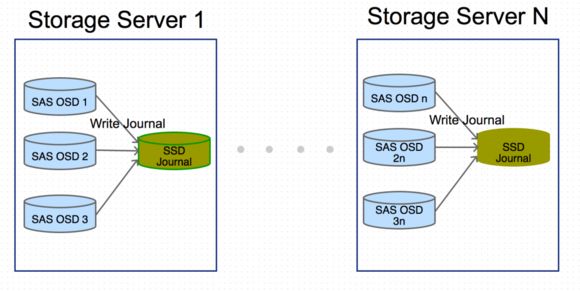

l 性能方面

利用SSD固态盘作为Ceph OSD日志盘来提高整个集群IO性能,来达到关键业务(如电商系统的数据库业务等)对性能的要求,做到性能和成本的最佳平衡点。SSD 具有低功耗,响应时间短,高IOPS,高吞吐量的特点。在Ceph的日志系统,对应的是多线程访问,采用SSD来代替机械硬盘,可以充分发挥,SSD随机读写响应时间短,高IO吞吐量的特点。通过调整IO调度策略,使之更适合于SSD盘,降低了整个IO的延时。

l 合理规划

根据服务器上虚拟机的密度,合理规划超融合节点下Ceph OSD的数量,并为OSD预分配CPU和内存等资源,同时,为保证系统稳定性,采用cgroup、taskset等工具对QEMU-KVM和Ceph OSD进行资源隔离。

l 参数调优

Ceph参数调优方面,通过调整Journal,FileStore的默认队列、OSD的OP线程数等参数,可有效提高性能。其它更多调优参数,可通过迭代测试,找到当前硬件环境的最佳参数。

l 数据高可用

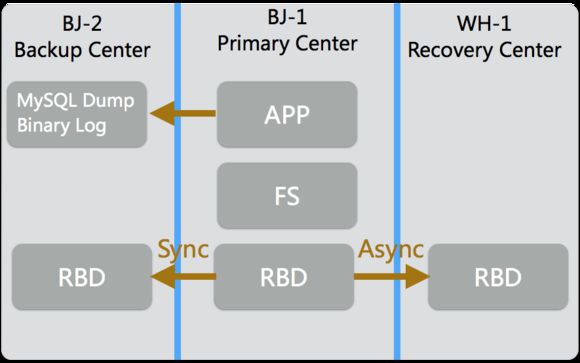

数据高可用方面,除了OpenStack已有的数据保护措施之外,联想未来规划中的两地三中心也做了数据灾备方案的准备:

通过专有的低延迟的光纤专线,数据可同步存储在同城备份中心,可异步存储在异地灾备中心,最大限度保证数据安全性。

AD集成

此外,联想还将自身的业务需求融入到了OpenStack企业云平台中,作为一个拥有数万名员工的大企业,需要通过AD活动目录来进行认证,员工就不用单独再建用户、记口令等;通过协作方的定制开发,联想已将AD功能融入OpenStack企业云平台之中。

应用成果

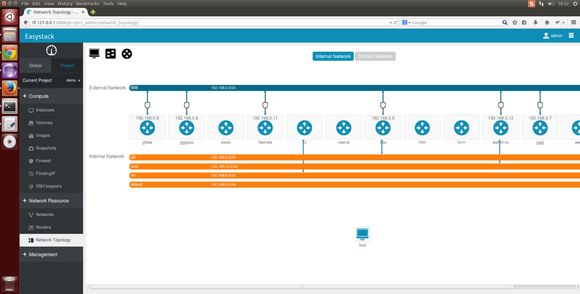

在构建好整个OpenStack企业云平台之后,联想面向“互联网”转型的关键才得以展开,电子商务、大数据分析、IM、手机在线业务支撑等互联网业务,从测试到生产真正的由联想企业云平台支撑起来。从创新应用的测试团队反馈来看,联想企业云平台目前运行良好。

在联想OpenStack企业云平台的建设过程中,联想选择了国内的OpenStack公司提供专业咨询与服务,帮助联想建设初期平台,培养了OpenStack专家。对联想而言,选择OpenStack合作伙伴的主要考虑因素,就是对社区的兼容和不断的升级,以及企业级服务经验。

作者简介:赵明,联想OpenStack私有云项目经理。(编辑/周建丁)

本文为CSDN原创文章,未经允许不得转载,如需转载请联系market#csdn.net(#换成@)