ML—逻辑回归算法(MATLAB)

华电北风吹

最后修改日期:2015/8/23

统计学习三要素方法=模型+策略+算法,对应于逻辑回归

模型=基于单极型函数(逻辑函数)的条件概率模型

策略=经验损失对应的训练样本先验概率最大化

算法=随机梯度上升法

逻辑回归MATLAB代码比较简单,如下所示,循环对所有的样本,进行梯度上升算法

function [w]=LogisticRegression(x,y,learningRate,maxEpoch)

% Logistic Regression

% x,y 一行为一个样本,y取值{0,1}

% 随机梯度法

[m,n]=size(x);

x=[ones(m,1) x];

w=zeros(1,n+1);

for epoch=1:maxEpoch

for samlendex=1:m

w=w+learningRate*(y(samlendex)-1/(1+exp(-x(samlendex,:)*w')))*x(samlendex,:);

end

end

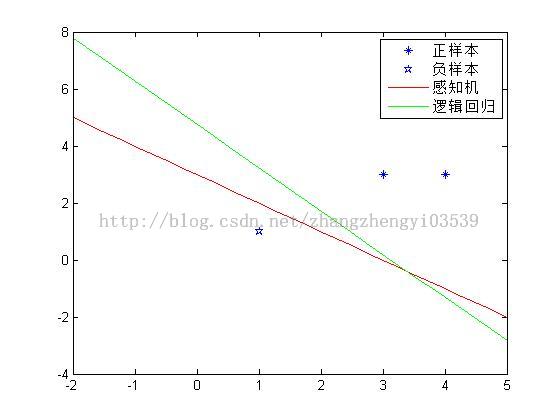

为了与先前的感知机比较,感知机代码http://blog.csdn.net/zhangzhengyi03539/article/details/46565739

把两个函数放在一个文件夹下使用下面的测试代码

clear;clc;

x=[3,3;4,3;1,1;];

y=[1,1,-1];

Pindex=find(y>0);

tIndex=1:length(y);

Nindex=setdiff(tIndex,Pindex);

plot(x(Pindex,1),x(Pindex,2),'*');

hold on;

plot(x(Nindex,1),x(Nindex,2),'p');

[w]=perceptionLearn(x,y,1,20);

xline=linspace(-2,5,20);

yline=-w(2)/w(3).*xline-w(1)/w(3);

plot(xline,yline,'r');

y=[1,1,0];

[w]=LogisticRegression(x,y,0.1,2000);

xline=linspace(-2,5,20);

yline=-w(2)/w(3).*xline-w(1)/w(3);

plot(xline,yline,'g');

legend('正样本','负样本','感知机','逻辑回归')

即可得到结果

一般情况下,逻辑回归结果要比感知机结果好,因为这个在策略比较中就可以看出来。感知机是策略是让分错的样本与分类超平面距离越来越近,如果全部分类正确即停止。而逻辑回归策略是对于训练样本在基于二项分布的假设下取样概率最大。

对于逻辑回归,我觉得可以这样对比感知机形象化的理解。感知机是对于每一个分错的样本,根据距离损失函数,让这个损失越来越小(不考虑w范数的情况下,把wx+b当作误分类点到分类超片面的距离)。逻辑回归是对所有的样本点,但是一次只考虑一个(随机梯度下降法),对正样本和负样本根据不同的概率函数(单极性函数和1-单极性函数),用随机梯度上升法优化w,让这个概率更大。

对于分类超平面的位置与先验概率的关系:换句话说就是分类超平面在哪儿的时候,概率最大。以二维平面为例,在不考虑w范数的情况下,我们也可以把wx+b当作误分类点到分类超片面的距离,就会发现当分类正确的那些点都与分类超平面越远,分类错误的点都与分类超平面越近的时候,先验概率越大。

至于为什么采用单极型函数,将会在后续的一篇关于广义线性模型的博文推导。这个函数是推导出来的,而不是函数形状符合要求就采用的<^_^>

欢迎继续关注。