Eclipse连接Hadoop步骤以及相关问题解决

Eclipse连接Hadoop安装步骤以及相关问题解决

一.通常使用Eclipse作为开发Hadoop程序的开发平台,所以需要用到Eclipse-Hadoop-Plugins插件包,但是由于官方GitHub上面插件包停止更新,最高版本是2.6.0的,所以需要自己根据自己的Hadoop版本编译相应的插件包。

二.如果不使用Eclipse-Hadoop-Plugins插件包,也可以开发,就需要先使用Maven将Hadoop开发相关的包下载到本地,直接使用Eclipse编程,将编好的代码打包成Jar文件,拷贝至虚拟机中,使用linux命令执行Jar文件,这样做相当麻烦。

三.编译插件详细步骤:

(1)下载插件源码,GitHub地址:https://github.com/winghc/hadoop2x-eclipse-plugin

(2)下载ant1.9.7,连接地址:http://mirrors.tuna.tsinghua.edu.cn/apache//ant/binaries/apache-ant-1.9.7-bin.tar.gz

(3)将虚拟机中的Hadoop压缩包拷贝到window系统中,解压到指定文件夹中,这里使用的是Hadoop2.7.3版本

(4)解压插件源码压缩包,解压ant压缩包

(5)在Windows系统中配置Hadoop的环境变量HADOOP_HOME,HADOOP_HOME=hadoop安装路径,将ANT_HOME添加到系统路径PATH

(6)在Windows系统中配置Ant的环境变量ANT_HOME,ANT_HOME=ant安装路径,将ANT_HOME添加到系统路径PATH中,%ANT_HOME%\bin

(7)快捷键Win+r,使用cmd打开终端,输入ant -version,显示出ant的版本信息,即说明配置成功

(8)配置Eclipse-Hadoop-plugins插件,找到hadoop2x-eclipse-plugin-master文件夹,切换目录至D:\Hadoop\hadoop2x-eclipse-plugin-master\src\contrib\eclipse-plugin文件夹中,修改build.xml文件,在

并添加两个新的element:

(9)在

lib/servlet-api-${servlet-api.version}.jar,

lib/commons-io-${commons-io.version}.jar,

并将lib/htrace-core-${htrace.version}.jar替换为lib/htrace-core-${htrace.version}-incubating.jar

(10)hadoop2x-eclipse-plugin-master\src\ivy\libraries.properties文件中,更改下列属性和其值使其对应hadoop2.7.3和当前环境的jar包版本:

hadoop.version=2.7.3

apacheant.version=1.9.7

commons-collections.version=3.2.2

commons-httpclient.version=3.1

commons-logging.version=1.1.3

commons-io.version=2.4

slf4j-api.version=1.7.10

slf4j-log4j12.version=1.7.10

(11)hadoop2x-eclipse-plugin-master\ivy\libraries.properties文件中,属性和值的修改同上面.。另外需要增加一个修改:

htrace.version=3.1.0

(12)进入包括上面配置修改的插件源代码hadoop2x-eclipse-plugin-master\src\contrib\eclipse-plugin目录,运行如下ant命令进行编译:

ant jar -Dversion=2.7.3 -Declipse.home=

其中

其实真正编译的过程还是很快的,主要是ivy下载的时间比较长,占用了整个编译运行的大部分时间。

(13)编译成功完成后,在hadoop2x-eclipse-plugin-master\build\contrib\eclipse-plugin目录下就能看到新生成的hadoop-eclipse-plugin-2.7.2.jar包了,这个就是我们需要的插件。只要把它拷贝到Eclipse安装目录下的plugins目录下,启动Eclipse,就能准备在Eclipse下进行mapreduce程序的开发运行了。

四.相关问题以及解决方法

1.hadoop2x-eclipse-plugin-master\ivy\libraries.properties文件中,原本就有htrace.version=3.0.4,所以需要将原来有的版本删除,使用htrace.version=3.1.0

2.编译一直卡住不动,那就将hadoop2x-eclipse-plugin-master\src\contrib\eclipse-plugin\build.xml中的

3.将插件包放入Eclipse中的plugins文件夹中,有可能也不出会出现DFS Location图标,这里使用最新版本的Eclipse没有出现图标,但是使用Eclipse-Luna版本出现并且可以使用,所以插件和Eclipse的版本有关系。

4.如果版本使用正确还是没有出现DFS Location图标,则使用cmd ,切换到Eclipse的安装目录下面使用eclipse -clean启动,清理一下缓存。

五.成功效果图

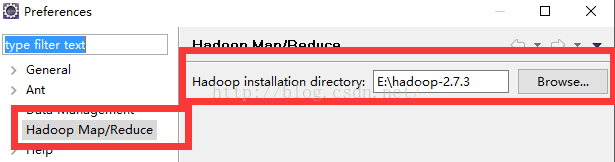

1.出现之后,点击Window-->preference

2.

点击左侧Hadoop Map/Reduce 出现右侧的Hadoop installation directory,点击选择hadoop的安装路径,点击ok。

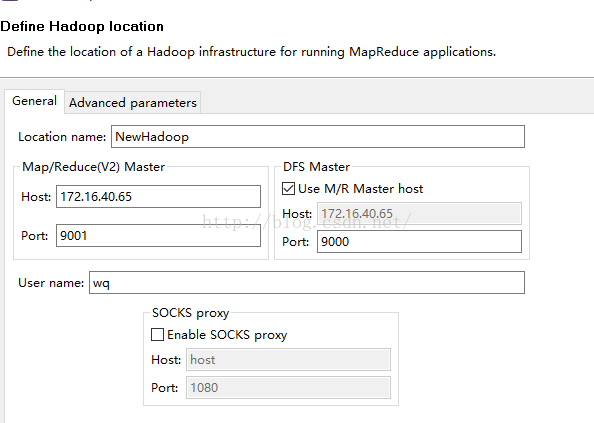

3.配置Map/Reduce 视图

window ->Open Perspective -> other->Map/Reduce -> 点击“OK”

windows → show view → other->Map/Reduce Locations-> 点击“OK”

4.控制台会多出一个“Map/Reduce Locations”的Tab页在“Map/Reduce Locations” Tab页 点击图标<大象+>或者在空白的地方右键,选择“New Hadoop location…”,弹出对话框“New hadoop location…”

5.进行连接配置,location name自己任意填写,host写虚拟机的ip或者主机名(若写主机名,需要配置Windows下面的hosts,原理与虚拟机中一样),port端口号一定要和mapred-site.xml和core-site.xml等配置文件一致

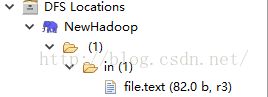

6.打开Project Explorer,查看HDFS文件系统,效果如下(初始文件夹数目是0):

To be continue..........