VQA数据集调研报告

VQA数据集调研报告

2018年3月16日

14:22

一、VQA数据集

1.与问题相关的数据集(related to questions)

1.1.训练集(training set)

(1)基本情况介绍:

name:v2_OpenEnded_mscoco_train2014_questions.json

size:40M

version: 2.0

year: 2017

contributor: VQA Team

date by created: 2017-04-26 17:07:13

task type: Open-Ended

data type: mscoco

url: http://visualqa.org

(2)形式(eg):

Name |

Type 类型 |

Description 描述 |

image_id |

int |

图片ID |

question_id |

|

问题的ID |

question |

str |

图片对应的问题 |

{"image_id": 458752,"question": "What is this photo taken looking through?","question_id": 458752000},{"image_id": 458752, "question": "What position isthis man playing?", "question_id": 458752001},{"image_id": 458752, "question": "What color is theplayers shirt?", "question_id": 458752002},{"image_id": 458752, "question": "Is this man aprofessional baseball player?", "question_id": 458752003}

(3)每张图片有一个编号,每张图片对应有若干个不同的问题,每个问题有一个编号,问题编号在图片编号的基础上增加三位,依次编为xxxxxx000,xxxxxx001 ...等等。

1.2.验证集(val)

(1)基本情况:除size为19.3M外其他情况同上

(2)形式:同上

1.3.测试集(test)

(1)开发测试集:除size为9.57M外其他同上

(2)测试集:除size为39.8M外其他同上

eg:{"image_id": 1, "question":"What is the fence made of?", "question_id": 1000},{"image_id": 1, "question": "What color is thetruck?", "question_id": 1001}, {"image_id": 1,"question": "What service does the car parked at the curbprovide?", "question_id": 1002}

1.4.总结:

(1)数量关系:(train:val:test-dev:test=4:2:1:4)

(2)作用:

train_set:作用是用来拟合模型

val_set:作用是当通过训练集训练出多个模型后,为了能找出效果最佳的模型,使用各个模型对验证集数据进行预测,并记录模型准确率。选出效果最佳的模型所对应的参数,即用来调整模型参数。

test_set:通过训练集和验证集得出最优模型后,使用测试集进行模型预测。用来衡量该最优模型的性能和分类能力。即可以把测试集当做从来不存在的数据集,当已经确定模型参数后,使用测试集进行模型性能评价。对原始数据进行三个数据集的划分,也是为了防止模型过拟合。

test_dev:这部分数据用来调参,选择特征,以及对学习算法做出其他决定。有时也被称为留出交叉验证(hold-outcross validation set)

2.与注释相关的数据集(Annotations)

2.1.训练集(v2_mscoco_train2014_annotations)

(1)基本情况介绍:除size为339M外其他同1.1(1)

(2)形式(eg):

{"question_type":"what color is the", "multiple_choice_answer": "red","answers": [{"answer": "red","answer_confidence": "yes", "answer_id": 1},{"answer": "red", "answer_confidence":"yes", "answer_id": 2}, {"answer":"red & white", "answer_confidence": "yes", "answer_id":3}, {"answer": "black", "answer_confidence":"no", "answer_id": 4}, {"answer":"red", "answer_confidence": "yes","answer_id": 5}, {"answer": "red","answer_confidence": "yes", "answer_id": 6},{"answer": "red", "answer_confidence":"yes", "answer_id": 7}, {"answer":"red", "answer_confidence": "maybe", "answer_id":8}, {"answer": "red", "answer_confidence":"yes", "answer_id": 9}, {"answer":"red and white", "answer_confidence": "yes", "answer_id":10}], "image_id": 262146, "answer_type":"other", "question_id": 262146002}

2.2.验证集(v2_mscoco_val2014_annotations)

(1)基本情况介绍:除size为163M外同1.1(1)

(2)形式(eg):同上,每张图片对应一个问题,每个问题对应十个答案,每张图片对应的每个问题及答案用"{ }"括起来,每个问题对应的十个答案用"[]"括起来

3.与图片特征相关的数据集(image feature)

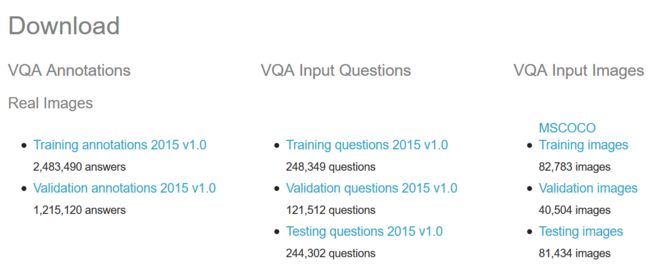

(1)MS-COCO:2014年发布,包含来自Flickr的300K张真实世界的照片,每张照片有五个独立的句子描述照片的场景

(2)VQA:VQA数据集是在MS-COCO数据集的基础上添加了614K问题答案对,VQA1.0发布于2015年,由于这个数据集很新,所以还存在一些问题:你可以用简单的通过死记硬背来回答对很多问题,获得 ok 的效果。比如说 yes/no 问题,如果永远回答 yes,你就能答对大部分。所以这个数据集的答案有一定先验,不是很平衡。

(3)在VQA1.0的基础上,采集了新的数据,发布了 VQA-2.0 的版本,这个版本比之前的版本又大了一倍。一共有 650000 的问题答案对,涉及 120000 幅不同的图片。这个新的数据库主要解决了答案不平衡的问题。对于同一个问题,他们保证,有两张不同的图片,使得他们对这个问题的答案是不同的。这使得VQA系统为了生成正确的答案不得不更多的利用图片特征,从而使视觉特征在VQA中扮演了更重要的角色。

在新的 VQA-2.0 中,对于 yes/no 问题,yes 和 no 的回答是各一半。

关于VQA-2.0数据集的视频介绍:VQA-2.0

二、Visual genome数据集

Visual genome 第一个版本的数据集发布于2015年12月10日最初发布的数据集有七个子文件构成,分别是存储图片的images(分两部分存储part1 9.2G、part2 5.47G),存储图片元数据的image meta data(16.92M)详情如下(VQA任务中只利用了objects 和attributes):

· imagespart 1 (9.2 GB), part 2 (5.47 GB)(全部以JPG格式的图片存储,存储形式:IMAGE_ID.jpg)

· image meta data (16.92 MB)

· region descriptions (988.18 MB)

· question answers (201.09 MB)

· objects (99.14 MB)

· attributes (174.97 MB)

· relationships (406.70 MB)

1.图片元数据

Name |

Type 类型 |

Description 描述 |

image_id |

int |

图片ID |

url |

|

图片URL |

width |

int |

图片宽 pixels |

height |

int |

图片高 |

coco_id |

int |

在 COCO 数据集中的图片ID |

flickr_id |

int |

在 flickr 数据集中的图片ID |

如:

[...

{

"image_id": 2412112,

"url": "https://cs.stanford.edu/people/rak248/VG_100K/2370463.jpg",

"width": 500,

"height": 281,

"coco_id": 547168,

"flickr_id":8505158818

}

...]

2.Objects

Name |

Type 类型 |

Description 描述 |

image_id |

int |

图片ID |

objects |

|

该图片的 object 实例 |

—-.object_id |

int |

object ID |

—-.x |

int |

object bounding box 的 x 坐标值 |

—-.y |

int |

object bounding box 的 y 坐标值 |

—-.w |

int |

object bounding box 的宽 |

—-.h |

int |

object bounding box 的高 |

—-.name |

str |

object 名字 |

—-.synsets |

|

该 object 相关的同义词名字 |

[...

{

"image_id": 2,

"objects": [...

{

"object_id": 1023847,

"x": 405,

"y": 34,

"w": 78,

"h": 438,

"name":"pole",

"synsets":["pole.n.01"]

},

{

"object_id": 1023836,

"x": 239,

"y": 347,

"w": 136,

"h": 126,

"name":"car",

"synsets":["car.n.01"]

},

...]

},

...]

3.Attributes

Name |

Type 类型 |

Description 描述 |

image_id |

int |

图片ID |

attributes |

|

该图片的 object 实例的 attributes 数组 |

—-.object_id |

int |

object ID |

—-.x |

int |

object bounding box 的 x 坐标值 |

—-.y |

int |

object bounding box 的 y 坐标值 |

—-.w |

int |

object bounding box 的宽 |

—-.h |

int |

object bounding box 的高 |

—-.name |

str |

object 名字 |

—-.synsets |

|

该 object 相关的同义词名字 |

如:

[...

{

"image_id": 2,

"attributes": [...

{

"object_id": 1023847,

"x": 405,

"y": 34,

"w": 78,

"h": 438,

"name":"pole",

"synsets":["pole.n.01"],

"attributes":["brown"]

},

{

"object_id": 1023836,

"x": 239,

"y": 347,

"w": 136,

"h": 126,

"name":"car",

"synsets":["car.n.01"],

"attributes":["red", "broken"]

},

...]

},

...]

三、数据集构建过程(大约33,000位不同的workers参与到了数据集的标注中。这个数据集经过6个月的收集,和长达15个月的迭代测试。): 找来亚马逊的众包标注服务,构建了一整套流水线。标注过程分为多个阶段,每一个阶段都是又众包worker完成的。 首先,给定一张图片,worker需要手工撰写“region description”,并且用bounding box框出这个region。得到region description之后,worker开始从这些文本中抽object(通常是名词),同时再用bounding box严格地框住这些object。有了object之后,再根据region description、图片本身等数据,人工抽取这些object的attribute和region内部多个object之间的relationship。将这些东西combine在一起就得到了一个region graph,有了region graph和其他各种数据之后,找到各个region graph中公共的object(可以通过包围框的overlap来判断该标注的object是否对应了同一个object)。用这些公共的object作为纽带,将这些region graph连接在一起,就形成了scene graph。给图片标QA pairs。QA Pairs 有两种。 第一种是freeform QA pairs。把图片给worker,让worker针对这个图片提出至少8个问题(必须是以who, what, where, when, why and how开头的问题)。同时这个8个问题中必须包含这六类中的三类。 第二种是region-based QA pairs。把region给worker,让worker针对这个region提出一个问题。 然后将以上整理校验就得到了Visual Genome

四、备注:Wordnet

Wordnet本身除了是一个词典外,它包含了每个词的语义信息,它会将相同词义的词语分为一个组称为Synset(同义词集合)Wordnet提供了每个词条的语义信息并记录了他们的之间的语义关系。这个词典的每个词组不是独立的是相互有关系的。

数据集中的每张图片平均包括了35个objects,并且都用一个紧密的box指出其位置。除此之外,每一个object都被映射到了WordNet中的synset ID。比如说, man 被映射到了 man.n.03 (the generic use of the word to refer to any human being) 。而 person 被映射到了 person.n.01 (a humanbeing) 。而这两个概念虽然都可以映射到 person.n.01 上(因为它是 man.n.03 的上位词包含的概念更广),也就是说,图片中对object的标注可能出现“一物多名”的情况(例如 man, person, human等)。