- 【华为OD技术面试真题 - 技术面】- python八股文真题题库(1)

算法大师

华为od面试python

华为OD面试真题精选专栏:华为OD面试真题精选目录:2024华为OD面试手撕代码真题目录以及八股文真题目录文章目录华为OD面试真题精选1.数据预处理流程数据预处理的主要步骤工具和库2.介绍线性回归、逻辑回归模型线性回归(LinearRegression)模型形式:关键点:逻辑回归(LogisticRegression)模型形式:关键点:参数估计与评估:3.python浅拷贝及深拷贝浅拷贝(Shal

- 生于八十年代--我的姐姐

自南向北

姐姐大我四岁,幸亏有了她,才有了我。要是头一个是男孩,估计在家里就是另一个孩子了。在我儿时的记忆里,姐姐是一下子蹦出来的,为什么这么说?因为在我五六岁前的印象里是没有她的,五六岁后就突然出现在了我家。上学前的那段时间我俩一直在一起,母亲白天上班,把午饭准备好后,就出门了。屋里就留下两个孩子,由着我们在田间地头,屋前河边到处转悠,现在想来是危险至极,但是在当时却也没有旁的办法。生活是第一位的,父亲在

- python语法——三目运算符

HappyRocking

pythonpython三目运算符

在java中,有三目运算符,如:intc=(a>b)?a:b表示c取两者中的较大值。但是在python,不能直接这样使用,估计是因为冒号在python有分行的关键作用。那么在python中,如何实现类似功能呢?可以使用ifelse语句,也是一行可以完成,格式为:aifbelsec表示如果b为True,则表达式等于a,否则等于c。如:c=(aif(a>b)elseb)同样是完成了取最大值的功能。

- 我家纱窗上全是杨树毛子

viiiiiiiiito

1“所以你脖…嘶…子上的伤不是你自己抓出来的喽?”永河喜欢在说话说到一半的时候吸烟,这总让他产生一些惊人的断句。”恩,不是给你说了么,方易在厕所门口就和别人打起来了,从厕所一路打到酒吧门口,他说我是去劝架,被误伤的。”“后来呢?”“后来就打车回家了啊。”“我是说打…嘶…架,赢了输了?“”完全不记得了,方易连他打的是谁都不知道,我看我这浑身疼的,估计是输了。“”垃圾,要不是我赶飞机昨天我们肯定…”“

- [实践应用] 深度学习之优化器

YuanDaima2048

深度学习工具使用pytorch深度学习人工智能机器学习python优化器

文章总览:YuanDaiMa2048博客文章总览深度学习之优化器1.随机梯度下降(SGD)2.动量优化(Momentum)3.自适应梯度(Adagrad)4.自适应矩估计(Adam)5.RMSprop总结其他介绍在深度学习中,优化器用于更新模型的参数,以最小化损失函数。常见的优化函数有很多种,下面是几种主流的优化器及其特点、原理和PyTorch实现:1.随机梯度下降(SGD)原理:随机梯度下降通过

- 3.1 损失函数和优化:损失函数

做只小考拉

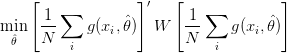

用一个函数把W当做输入,然后看一下得分,定量地估计W的好坏,这个函数被称为“损失函数”。损失函数用于度量W的好坏。有了损失函数的概念后,就可以定量的衡量W到底是好还是坏,要找到一种有效的方法来从W的可行域里,找到W取何值时情况最不坏,,这个过程将会是一个优化过程。损失函数L_i定义:通过函数f给出预测的分数和真实的目标(或者说是标签y),可以定量的描述训练样本预测的好不好,最终的损失函数是在整个数

- 你给予我别人羡慕的一切,我却失去了自己,致敬为家庭付出一切的女神们

跃界一

如果嫁的老公家有万贯,两栋6楼高的房子,家公为你们家买的一套商品房写上了你的名字,还为你买了一辆车,你会开心吗?或许一般的人看起来很开心,可实际上拥有这一切的这个人开心吗?这些财产的拥有者叫北冰,在外人看来,家庭和睦,每天不用为生计烦恼,是多么的幸福。未出嫁前,北冰性格开朗且好玩乐观,喜欢社交,聚会和k歌,是个潮流个性的女生。她有消耗不完精力,能到处跑。出嫁之后,她成了一个规规矩矩的家庭妇女。每天

- JVM源码分析之堆外内存完全解读

HeapDump性能社区

概述广义的堆外内存说到堆外内存,那大家肯定想到堆内内存,这也是我们大家接触最多的,我们在jvm参数里通常设置-Xmx来指定我们的堆的最大值,不过这还不是我们理解的Java堆,-Xmx的值是新生代和老生代的和的最大值,我们在jvm参数里通常还会加一个参数-XX:MaxPermSize来指定持久代的最大值,那么我们认识的Java堆的最大值其实是-Xmx和-XX:MaxPermSize的总和,在分代算法

- 2023-09-21郝晓东教师专业阅读第一讲

每天坚持

20230921六点零三星期四郝晓东教师专业阅读第一讲昨天早上起床比较晚,完成了八九百字,今天早上起床又是有点晚,估计今天早上又是完不成两千字的电子日记了。昨天晚上本来是打算去河里游泳的,但是到了河边感觉有点冷,不想下水了,刚好老表打电话,本来是打电话说去八里滩温泉洗澡的,但是没有人,我们就去河对面转了一圈,见了朱总、李总,走了两万多步,感觉很累,早上起来感觉腰比较不舒服,我就把厚睡衣穿上了,主要

- 外婆的“多动症”

杉水Daisy

2019年2月18日星期一天气:中雨坐标:上海回家一趟,家里只有外婆和大姨在。当时想着主要是看看外婆的身体,听说她最近胃口不好了。到家里之后,我觉得外婆的身体状况还好,只是前段时间吃错东西伤到胃了,养一养应该没什么大问题。我到家的时候,她已经吃了几天粥,基本可以进食了,包括蔬菜、鱼虾之类的。相反,大姨的身体却似乎有些虚弱。了解之后发现她是感冒了,估计还有些发烧。后来吃饭的时候,不知道是吃了什么,还

- 休息了两天,明天继续加油

田木习习

姑且不去管结果了,继续按部就班的准备。放松了两天,精神好多了。有的事,看开真的很重要。准备给栩断奶了。最近她不爱吃饭,整个人瘦了一圈,每天就靠着母乳不上不下的。再这样下去,小丫头要瘦没了。买了奶粉,准备狠狠心,开始断奶,这样自己也能轻松很多。这个过程估计不会很容易,努力吧,总要熬过这一关。最近真的很热,晚上睡觉空调开到24也不觉得凉快。明天开始吃课本,为可能没有的下一步做准备,加油,尽人事听天命!

- 这该死的疫情

婴宁嫣然

我真的是后知后觉,对今年年初的疫情当时只是恐惧,厌恶,现在是严重的憎恨了。因为疫情,领导说上学期学生在家没好好学习,基础不扎实,于是我们从期末考试结束就开始补课,今年的暑假休息了四天,哦不对是四天半。从七月至今,我们已经连续上了五个月课了,如果不是春节,估计我们还会有下一个五个月,还好,春节让我们这学期只用再上两个月。而从期中考试之前两周到现在,已经连续七个周上课了。我知道有人一定说疫情期间,你们

- 赵静,焦点解决网络初级班第14期,郑州分享第114天 夫妻相处

赵静_9264

早上六点多接到科室小朱的微信帮忙处理病号,想着有事晚点来,谁知下午也没见人,今天她值班,问主任也没接到电话,赶紧打电话却关机,给她老公(医院麻醉师)打电话问也不知道在哪,感觉很无语,自己老婆都不知道在哪,估计吵架了,一波三折才知道在她妈家。主任问了她老公才知道缘由,就因为碗谁洗这事吵架,小朱半夜带孩子回娘家。听了也感觉很可笑,多么小的一件事啊,夫妻双方还需要互相迁就、包容、理解,也能使婚姻继续下去

- Python和R均方根误差平均绝对误差算法模型

亚图跨际

Python交叉知识R回归模型误差指标归一化均方根误差生态状态指标神经网络成本误差气体排放气候模型多项式拟合

要点回归模型误差评估指标归一化均方根误差生态状态指标神经网络成本误差计算气体排放气候算法模型Python误差指标均方根误差和平均绝对误差均方根偏差或均方根误差是两个密切相关且经常使用的度量值之一,用于衡量真实值或预测值与观测值或估计值之间的差异。估计器θ^\hat{\theta}θ^相对于估计参数θ\thetaθ的RMSD定义为均方误差的平方根:RMSD(θ^)=MSE(θ^)=E((θ^−θ

- Python(PyTorch)和MATLAB及Rust和C++结构相似度指数测量导图

亚图跨际

Python交叉知识算法量化检查图像压缩质量低分辨率多光谱峰值信噪比端到端优化图像压缩手术机器人三维实景实时可微分渲染重建三维可视化

要点量化检查图像压缩质量低分辨率多光谱和高分辨率图像实现超分辨率分析图像质量图像索引/多尺度结构相似度指数和光谱角映射器及视觉信息保真度多种指标峰值信噪比和结构相似度指数测量结构相似性图像分类PNG和JPEG图像相似性近似算法图像压缩,视频压缩、端到端优化图像压缩、神经图像压缩、GPU变速图像压缩手术机器人深度估计算法重建三维可视化推理图像超分辨率算法模型三维实景实时可微分渲染算法MATLAB结构

- 磁盘性能评价指标—IOPS和吞吐量

???? ??? Frank

一、磁盘I/O的概念I/O的概念,从字义来理解就是输入输出。操作系统从上层到底层,各个层次之间均存在I/O。比如,CPU有I/O,内存有I/O,VMM有I/O,底层磁盘上也有I/O,这是广义上的I/O。通常来讲,一个上层的I/O可能会产生针对磁盘的多个I/O,也就是说,上层的I/O是稀疏的,下层的I/O是密集的。磁盘的I/O,顾名思义就是磁盘的输入输出。输入指的是对磁盘写入数据,输出指的是从磁盘读

- 那些颜色刺痛了我的眼

那头老虎在游泳池里扑腾地像只猫

图片发自App我们总是习惯被习以为常的事物所麻痹,熟视无睹后就认为理所当然。之前的无数次,我都有想过他们的生存状态,每一次都会在脑海里感慨几下,然后仿佛聊以自慰一般,直到渐渐的麻木起来。今天这趟出门,时间是二点四十分,一天中最热的时刻。周末领导安排工作,难免情绪会有问题,又是个大热天,头脑昏沉的就出发了。上了路,车辆并不多,一是因为周末并没有上班的人群,一是这个时间点天气燥热,人们估计都躲在家里不

- 家校共育转化待优生的途径的研究

冰皮石榴

家校共育转化待优生的途径的研究“没有最好,只有更好”。从广义来说,我们每个尚没有挖掘出巨大潜力的个体都是待优生,这里我们只针对陕隘意义的待优生,每个学校、每个班级几乎都会有待优生的身影。待优生是指思想上、行为上、学习上暂时落后于一般学生的那些学生,他们不是生而落后。待优生的产生是家庭教育、学校教育、社会教育和待优生自身等多方面因素综合作用的结果。“孩子没有问题,如果孩子有问题,那一定是父母的问题”

- 我与新媒体

小富yyd

1.我对新媒体的认识我对新媒体的认识就是比如传统媒体、网络媒体、移动端媒体、数字电视、数字报刊。新媒体则是通过现代化移动互联网手段,通过微信、微博等新兴媒体平台进行营销、宣传、推广等的一系列运营活动。新媒体可分为广义和狭义两个方面来理解。广义:新媒体可以看作在各种数字技术和网络技术支持下,以互联网、宽带局域网和无线通信网等为渠道,利用计算机、手机和数字电视等各种网络终端,向用户提供信息和娱乐服务的

- 当野鸡“心理学”变成赚钱的工具

Z小姐不吐不快

今日乘车闲来无事便听起了电台(可在网易云音乐搜索「报刊选读」,点击20180212那一期),听罢,不禁感叹,怪不得「洗稿惯犯」周冲说,“与其教育傻逼,不如赚傻逼点钱。”哎,如果我没啥良心,估计也能赚这钱了。▲图片摘自六神磊磊读金庸《今儿就从头彻底扒一下周冲,看是什么成色》头痛、脚痛,不管是哪里痛,家排疗法总会告诉你,身体的每一处疼痛都喻示着你的“心事”影响身体健康,只要找出病因,无论疼痛还是癌症都

- 圈子不同,有时候不得不强融入

铺盖小面君

我在极少数的情况下会融入集体,就比如说今天老板请我们吃饭。但我问了那个聊得来的女同事告诉我说,如果你想在这里长久的干下去,你这次还是去吧。我采取了他的意见,我老板还有三位同事5个人下了班,在这个大年初一的晚上出来找吃的.结果吃完饭之后,老板说干脆我们一起打王者荣耀吧,我当时尴尬得一匹。有一个同事他的手机没有装这个游戏,估计也不想玩,然后被逼无奈下载要好久。说实话都有点等的不耐烦,最主要是老板手机快

- Spring1-概述

Onlooker129

Springspring

目录Spring是什么Spring的狭义和广义SpringFramework特点Spring模块组成Spring是什么Spring是一款主流的JavaEE轻量级开源框架,Spring由“Spring之父”RodJohnson提出并创立,其目的是用于简化Java企业级应用的开发难度和开发周期。Spring的用途不仅限于服务器端的开发。从简单性、可测试性和松耦合的角度而言,任何Java应用都可以从Sp

- PDF怎么测量尺寸

时间的回忆88

PDF文件在使用的时候里面也会有图片与图形,我们需要测量其中尺寸的时候应该怎么做呢?估计各位小伙伴们也都很好奇吧,今天就一起来看看吧!1.首先要选择合适的PDF编辑软件,百度里搜索PDF编辑器http://bianji.xjpdf.com/,然后把这款软件安装在电脑中。编辑器安装完成之后打开运行迅捷PDF编辑器,在编辑器中打开需要测量的PDF图纸文件。2.尺寸的测量需要测量工具,找到编辑器中的工具

- 9.11事件背后的阴谋

250e4f21a70d

美国以本·拉登策划了“911”事件为由发动了阿富汗战争。可是,战争已经过去10多年了。“9.11”事件还有许多谜底至今尚未被解开。在2001年9月11日,美国东部时间约早上8时50分,纽约市曼哈顿区遭到恐怖袭击。世贸中心被两架遭恐怖分子劫持的民航客机相继冲击,两座大厦随即起火并冒出大量浓烟稍后相继倒下,伤亡人数难以估计。此外,世贸中心倒塌后大约一小时,位于华盛顿的五角大楼被第三架飞机撞击,两度爆炸

- 【山西定襄实验小学星空班一日叙事2022.1.8 张凯博】

Z飞雪

平凡的一天作者:张凯博睡梦中听到有脚步声响,还没有睁眼的我,心里突然想起昨天老师给我布置的语文作业。睁开眼看到爸爸已经穿好衣服,估计是去锻炼身体,我转过脑袋,望着窗外黑乎乎的一片,觉得时间还早,“老爸,几点了?”我嘶哑的嗓子里努力地蹦出了一句。“噢——不到七点!”为了完成老师布置的任务,我下定决心咬了咬牙,把衣服穿上,天好冷,毕竟是三九的天了,不是有句俗语说“三九四九门缝叫狗……”吗?爸爸用好奇的

- 可爱的学生

秋秋历史苑

上午,上完两节课后,本想在办公室休息一下,正遇上另一位老师临时有急事,她的一个学生交给我帮她管一下,很简单,也就是督促孩子记下词语,多音字以及练习题批改。二年级的一个小男孩,挺腼腆的。自己默默地在本子上记着七八个词语,过了一会儿,告诉我可以听写了。我接过孩子的书就开始了报词语。刚刚记忆了片刻,而且还抄写了几遍,居然合书即忘。其实大人也一样,一个生字,刚学会了它的读音及写法,呆会儿听写估计也得望。我

- 逛夜

顽石的青果花园

如果逛街就总会有点事做,我就是去逛夜,和街没有点滴关系。临出门看下手机的电量,如果不够所有的歌播两遍,就先充电。单单就音乐来说,我跟现在确实是脱节的,估计那些歌同龄人都不大听。路线由脚去选,能找到回家的路就行,不过速度是一贯的慢悠悠。至于脑子里想什么,我也不知道,工作是一定会想,也会琢磨文字,有巧妙的文字蹦出来,也会自顾自的嘚瑟好一会。逛夜是一定不能有坏情绪的,表情尽可以丰富。于我,乌托邦啊世外桃

- 15:00面试,15:06就出来了,问的问题有点变态。。

2401_86640859

面试职场和发展

应该考虑进行如何测试的测试方法怎样估计测试工作量?测试设计的问题当测试过程发生错误时,有哪几种解决办法?测试执行的问题测试评估的目标如何提高测试?C/S模式的优点和缺点B/S模式的优点和缺点…Linuxgrep和find的区别?grep都有哪些用法?查看IP地址?创建和删除一个多级目录?在当前用户家目录中查找haha.txt文件?如何查询出tomcat的进程并杀掉这个进程,写出linux命令?动态

- 妻子生下双胞胎女儿,婆婆催生三胎,岂料丈夫的行为让人猜不透

俺叫德玛

生下双胞胎女儿后,婆婆非常不满意,一直催我生三胎。我不同意,她就在家又吵又闹,幸好老公明事理,站我这边,并支招:下班后我俩都晚回家,保姆也下班,婆婆一人照顾俩孩子,会特别累,这估计就能断了她抱孙子的心思。我觉得老公聪明又体贴,也连续一段时候下班后就跟闺蜜嗨。直到那天,我在电影院看到了老公与别的女人……我今年34岁,线上教育公司的金牌讲师,老公36岁,企业副总,我们结婚3年,双胞胎女儿2岁。本来我们

- 徐忠顺刘友龙秦皇岛焦点解决坚持分享第66天2020.04.07

雨顺心理

助人者SFBT技术,不单纯是一个心理学技术,更是每个人生活哲学的重要组成部分。以往,看到“助人者”时,总是想到的是“咨询师”。而从生活哲学层面看“助人者”是一种广义的称呼,凡是在生活中可能提供他人协助的人都可以称为“助人者”,包括父母、教师、主管、督导、咨询师、社工人员、神职人员、义务助人工作者等;家人、同事、朋友之间,也可能互相帮助。

- [黑洞与暗粒子]没有光的世界

comsci

无论是相对论还是其它现代物理学,都显然有个缺陷,那就是必须有光才能够计算

但是,我相信,在我们的世界和宇宙平面中,肯定存在没有光的世界....

那么,在没有光的世界,光子和其它粒子的规律无法被应用和考察,那么以光速为核心的

&nbs

- jQuery Lazy Load 图片延迟加载

aijuans

jquery

基于 jQuery 的图片延迟加载插件,在用户滚动页面到图片之后才进行加载。

对于有较多的图片的网页,使用图片延迟加载,能有效的提高页面加载速度。

版本:

jQuery v1.4.4+

jQuery Lazy Load v1.7.2

注意事项:

需要真正实现图片延迟加载,必须将真实图片地址写在 data-original 属性中。若 src

- 使用Jodd的优点

Kai_Ge

jodd

1. 简化和统一 controller ,抛弃 extends SimpleFormController ,统一使用 implements Controller 的方式。

2. 简化 JSP 页面的 bind, 不需要一个字段一个字段的绑定。

3. 对 bean 没有任何要求,可以使用任意的 bean 做为 formBean。

使用方法简介

- jpa Query转hibernate Query

120153216

Hibernate

public List<Map> getMapList(String hql,

Map map) {

org.hibernate.Query jpaQuery = entityManager.createQuery(hql);

if (null != map) {

for (String parameter : map.keySet()) {

jp

- Django_Python3添加MySQL/MariaDB支持

2002wmj

mariaDB

现状

首先,

[email protected] 中默认的引擎为 django.db.backends.mysql 。但是在Python3中如果这样写的话,会发现 django.db.backends.mysql 依赖 MySQLdb[5] ,而 MySQLdb 又不兼容 Python3 于是要找一种新的方式来继续使用MySQL。 MySQL官方的方案

首先据MySQL文档[3]说,自从MySQL

- 在SQLSERVER中查找消耗IO最多的SQL

357029540

SQL Server

返回做IO数目最多的50条语句以及它们的执行计划。

select top 50

(total_logical_reads/execution_count) as avg_logical_reads,

(total_logical_writes/execution_count) as avg_logical_writes,

(tot

- spring UnChecked 异常 官方定义!

7454103

spring

如果你接触过spring的 事物管理!那么你必须明白 spring的 非捕获异常! 即 unchecked 异常! 因为 spring 默认这类异常事物自动回滚!!

public static boolean isCheckedException(Throwable ex)

{

return !(ex instanceof RuntimeExcep

- mongoDB 入门指南、示例

adminjun

javamongodb操作

一、准备工作

1、 下载mongoDB

下载地址:http://www.mongodb.org/downloads

选择合适你的版本

相关文档:http://www.mongodb.org/display/DOCS/Tutorial

2、 安装mongoDB

A、 不解压模式:

将下载下来的mongoDB-xxx.zip打开,找到bin目录,运行mongod.exe就可以启动服务,默

- CUDA 5 Release Candidate Now Available

aijuans

CUDA

The CUDA 5 Release Candidate is now available at http://developer.nvidia.com/<wbr></wbr>cuda/cuda-pre-production. Now applicable to a broader set of algorithms, CUDA 5 has advanced fe

- Essential Studio for WinRT网格控件测评

Axiba

JavaScripthtml5

Essential Studio for WinRT界面控件包含了商业平板应用程序开发中所需的所有控件,如市场上运行速度最快的grid 和chart、地图、RDL报表查看器、丰富的文本查看器及图表等等。同时,该控件还包含了一组独特的库,用于从WinRT应用程序中生成Excel、Word以及PDF格式的文件。此文将对其另外一个强大的控件——网格控件进行专门的测评详述。

网格控件功能

1、

- java 获取windows系统安装的证书或证书链

bewithme

windows

有时需要获取windows系统安装的证书或证书链,比如说你要通过证书来创建java的密钥库 。

有关证书链的解释可以查看此处 。

public static void main(String[] args) {

SunMSCAPI providerMSCAPI = new SunMSCAPI();

S

- NoSQL数据库之Redis数据库管理(set类型和zset类型)

bijian1013

redis数据库NoSQL

4.sets类型

Set是集合,它是string类型的无序集合。set是通过hash table实现的,添加、删除和查找的复杂度都是O(1)。对集合我们可以取并集、交集、差集。通过这些操作我们可以实现sns中的好友推荐和blog的tag功能。

sadd:向名称为key的set中添加元

- 异常捕获何时用Exception,何时用Throwable

bingyingao

用Exception的情况

try {

//可能发生空指针、数组溢出等异常

} catch (Exception e) {

- 【Kafka四】Kakfa伪分布式安装

bit1129

kafka

在http://bit1129.iteye.com/blog/2174791一文中,实现了单Kafka服务器的安装,在Kafka中,每个Kafka服务器称为一个broker。本文简单介绍下,在单机环境下Kafka的伪分布式安装和测试验证 1. 安装步骤

Kafka伪分布式安装的思路跟Zookeeper的伪分布式安装思路完全一样,不过比Zookeeper稍微简单些(不

- Project Euler

bookjovi

haskell

Project Euler是个数学问题求解网站,网站设计的很有意思,有很多problem,在未提交正确答案前不能查看problem的overview,也不能查看关于problem的discussion thread,只能看到现在problem已经被多少人解决了,人数越多往往代表问题越容易。

看看problem 1吧:

Add all the natural num

- Java-Collections Framework学习与总结-ArrayDeque

BrokenDreams

Collections

表、栈和队列是三种基本的数据结构,前面总结的ArrayList和LinkedList可以作为任意一种数据结构来使用,当然由于实现方式的不同,操作的效率也会不同。

这篇要看一下java.util.ArrayDeque。从命名上看

- 读《研磨设计模式》-代码笔记-装饰模式-Decorator

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

import java.io.BufferedOutputStream;

import java.io.DataOutputStream;

import java.io.FileOutputStream;

import java.io.Fi

- Maven学习(一)

chenyu19891124

Maven私服

学习一门技术和工具总得花费一段时间,5月底6月初自己学习了一些工具,maven+Hudson+nexus的搭建,对于maven以前只是听说,顺便再自己的电脑上搭建了一个maven环境,但是完全不了解maven这一强大的构建工具,还有ant也是一个构建工具,但ant就没有maven那么的简单方便,其实简单点说maven是一个运用命令行就能完成构建,测试,打包,发布一系列功

- [原创]JWFD工作流引擎设计----节点匹配搜索算法(用于初步解决条件异步汇聚问题) 补充

comsci

算法工作PHP搜索引擎嵌入式

本文主要介绍在JWFD工作流引擎设计中遇到的一个实际问题的解决方案,请参考我的博文"带条件选择的并行汇聚路由问题"中图例A2描述的情况(http://comsci.iteye.com/blog/339756),我现在把我对图例A2的一个解决方案公布出来,请大家多指点

节点匹配搜索算法(用于解决标准对称流程图条件汇聚点运行控制参数的算法)

需要解决的问题:已知分支

- Linux中用shell获取昨天、明天或多天前的日期

daizj

linuxshell上几年昨天获取上几个月

在Linux中可以通过date命令获取昨天、明天、上个月、下个月、上一年和下一年

# 获取昨天

date -d 'yesterday' # 或 date -d 'last day'

# 获取明天

date -d 'tomorrow' # 或 date -d 'next day'

# 获取上个月

date -d 'last month'

#

- 我所理解的云计算

dongwei_6688

云计算

在刚开始接触到一个概念时,人们往往都会去探寻这个概念的含义,以达到对其有一个感性的认知,在Wikipedia上关于“云计算”是这么定义的,它说:

Cloud computing is a phrase used to describe a variety of computing co

- YII CMenu配置

dcj3sjt126com

yii

Adding id and class names to CMenu

We use the id and htmlOptions to accomplish this. Watch.

//in your view

$this->widget('zii.widgets.CMenu', array(

'id'=>'myMenu',

'items'=>$this-&g

- 设计模式之静态代理与动态代理

come_for_dream

设计模式

静态代理与动态代理

代理模式是java开发中用到的相对比较多的设计模式,其中的思想就是主业务和相关业务分离。所谓的代理设计就是指由一个代理主题来操作真实主题,真实主题执行具体的业务操作,而代理主题负责其他相关业务的处理。比如我们在进行删除操作的时候需要检验一下用户是否登陆,我们可以删除看成主业务,而把检验用户是否登陆看成其相关业务

- 【转】理解Javascript 系列

gcc2ge

JavaScript

理解Javascript_13_执行模型详解

摘要: 在《理解Javascript_12_执行模型浅析》一文中,我们初步的了解了执行上下文与作用域的概念,那么这一篇将深入分析执行上下文的构建过程,了解执行上下文、函数对象、作用域三者之间的关系。函数执行环境简单的代码:当调用say方法时,第一步是创建其执行环境,在创建执行环境的过程中,会按照定义的先后顺序完成一系列操作:1.首先会创建一个

- Subsets II

hcx2013

set

Given a collection of integers that might contain duplicates, nums, return all possible subsets.

Note:

Elements in a subset must be in non-descending order.

The solution set must not conta

- Spring4.1新特性——Spring缓存框架增强

jinnianshilongnian

spring4

目录

Spring4.1新特性——综述

Spring4.1新特性——Spring核心部分及其他

Spring4.1新特性——Spring缓存框架增强

Spring4.1新特性——异步调用和事件机制的异常处理

Spring4.1新特性——数据库集成测试脚本初始化

Spring4.1新特性——Spring MVC增强

Spring4.1新特性——页面自动化测试框架Spring MVC T

- shell嵌套expect执行命令

liyonghui160com

一直都想把expect的操作写到bash脚本里,这样就不用我再写两个脚本来执行了,搞了一下午终于有点小成就,给大家看看吧.

系统:centos 5.x

1.先安装expect

yum -y install expect

2.脚本内容:

cat auto_svn.sh

#!/bin/bash

- Linux实用命令整理

pda158

linux

0. 基本命令 linux 基本命令整理

1. 压缩 解压 tar -zcvf a.tar.gz a #把a压缩成a.tar.gz tar -zxvf a.tar.gz #把a.tar.gz解压成a

2. vim小结 2.1 vim替换 :m,ns/word_1/word_2/gc

- 独立开发人员通向成功的29个小贴士

shoothao

独立开发

概述:本文收集了关于独立开发人员通向成功需要注意的一些东西,对于具体的每个贴士的注解有兴趣的朋友可以查看下面标注的原文地址。

明白你从事独立开发的原因和目的。

保持坚持制定计划的好习惯。

万事开头难,第一份订单是关键。

培养多元化业务技能。

提供卓越的服务和品质。

谨小慎微。

营销是必备技能。

学会组织,有条理的工作才是最有效率的。

“独立

- JAVA中堆栈和内存分配原理

uule

java

1、栈、堆

1.寄存器:最快的存储区, 由编译器根据需求进行分配,我们在程序中无法控制.2. 栈:存放基本类型的变量数据和对象的引用,但对象本身不存放在栈中,而是存放在堆(new 出来的对象)或者常量池中(字符串常量对象存放在常量池中。)3. 堆:存放所有new出来的对象。4. 静态域:存放静态成员(static定义的)5. 常量池:存放字符串常量和基本类型常量(public static f