李宏毅《DLHLP》学习笔记7 - Voice Conversion

视频链接:https://www.youtube.com/watch?v=Jj6blc8UijY&list=PLJV_el3uVTsO07RpBYFsXg-bN5Lu0nhdG&index=9&ab_channel=Hung-yiLee

课件链接:https://speech.ee.ntu.edu.tw/~tlkagk/courses/DLHLP20/Voice%20Conversion%20(v3).pdf

1. 语音转换分类

语音转换的用处很多,如合成其他人的声音、合成不同情绪的声音等。本节介绍的技术都是从acoustic features到acoustic features,并不是生成真实可以听的语音信号。因为从acoustic features到wave之间,还有一个vocoder的工作,这个不在本文中介绍。

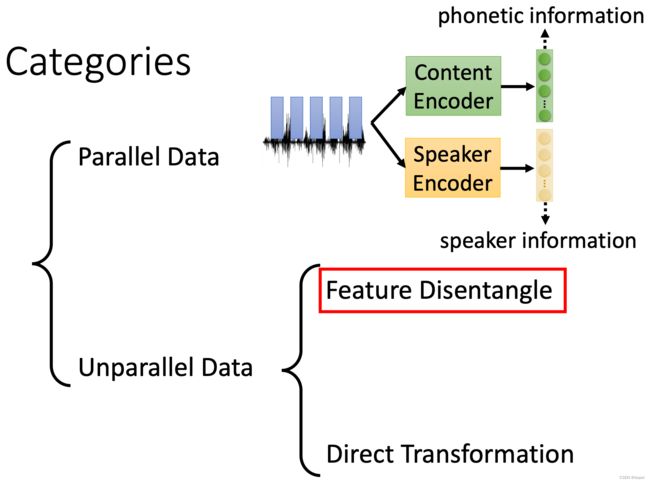

我们按图的方式进行分类,第一类是parallel data,这种事对于同一句话,有两个不同人的声音数据,这种数据是很匮乏的;第二类是unparallel data,这就不需要前面的那种成对的声音数据了。思路也是借鉴与图像的风格迁移技术。

2. Feature Disentangle

在unparallel data中,第一种技术是feature disentangle。其思想是使用两个encoder,将声音讯号中的内容信息与声纹信息区分开。

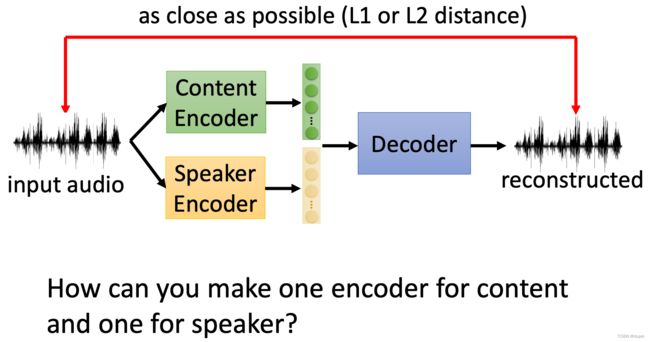

下图是将原始的acoustic features经过两个encoder,分别提取出语音内容的embedding和speaker音色的embedding,然后,再将这两个embedding拼接起来,通过decoder再解码为acoustic features。

当有这样的content encoder, speaker encoder和decoder以后,就可以从speaker A的acoustic features中抽取content信息,从speaker B的acoustic features中抽取音色信息,再将两者拼接在一起,通过decoder生成speaker B的说话内容。

那么,如何做到让一个encoder用于处理content,另一个encoder用于处理音色呢?

2.1 Speaker Encoder

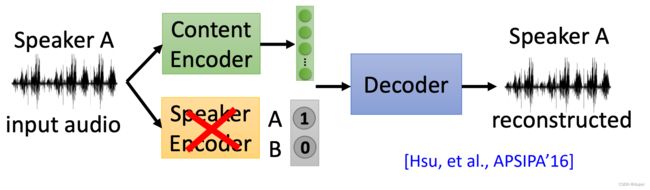

我们先从解决speaker encoder的问题开始,最简单的一种方案:使用one-hot取代speaker encoder,这样,我们就是在知道speaker encoder的前提下,去训练content encoder和decoder了。

当我们训练好content encoder和decoder以后,再使用Voice Conversion,就是简单地替换不同的speaker encoder了。当然,这里是存在一个局限的:我们可以合成的声音只能是明确已知的,也就是在one-hot中编码的。

另外,我们也可以采用预先训练模型的方式,提前训练好相应的encoder。

先来看看speaker encoder,我们可以使用各种已经公开的声纹模型,如:i-vector, d-vector, x-vectoer等。用这些声纹模型生成相应的speaker embedding,代替上面的one-hot,这样,或许可以合成出不再训练集中的声音。

2.2 Content Encoder

上面说过了speaker encoder,我们再看看content encoder。

我们可以考虑使用语音识别的模型当作content encoder,因为语音识别本身就是与speaker没有关系的。但是,语音识别模型会存在一个问题,就是输出是文字,而不是embedding。那么,我们该怎么办呢?

在介绍HMM的时候,我们说到HMM可以接DNN。在上图的右上角,DNN的输入是acoustic features,输出是属于每个status的概率,这样的话,我们就可以直接使用这个DNN来作为content encoder。

另外一种思路是使用GAN的方法,我们引入一个speaker classifier,用于识别content encoder输出的embedding是否包含speaker的特征。content encoder和speaker classifier交替进行训练。

2.3 架构设计

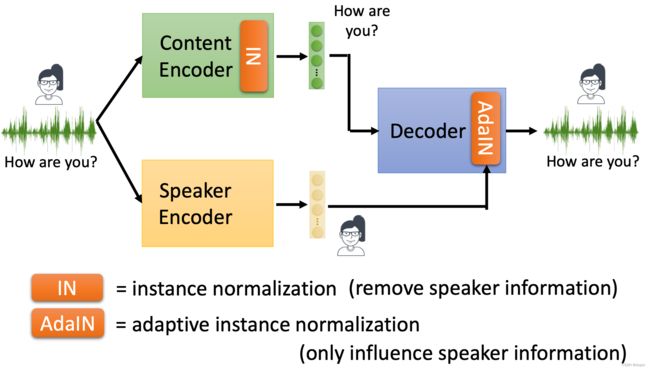

下面的技术也是借鉴与image style transformation的。

通过在content encoder中增加instance normalization以后,就可以去掉speaker 的信息了。

那么,为什么instance normalization可以去掉speaker的信息呢?

我们先以LAS中CNN版本的Encoder为例,看看Instance Normalization是如何工作的。每一个channel就是一种filter处理以后的输出,Instance normalization的作用就是在这一个channel上,计算出均值和方差,做normalize的操作。这样,经过instance normalization以后,每一个维度的均值都是0,方差都是1。

我们可以将不同的filter看作是抽取声音信号中的某种特征是否存在,如:是否是女性的声音或者是男性的声音。在没有经过instance normalization之前,某些channel是能够表现出不一样的性质的。但是,经过instance normalization以后,输出的都是类似的(均值为0,方差为1),这样,就将speaker的信息去掉了。

接下来,我们需要将speaker encoder的输出,加到decoder里,而且是只作用于speaker的特性上,使用的方法是AdaIN。

下面我们看看AdaIN的具体实现过程:

- 在Decoder中,也使用IN,将输出的特征做nomalize,去除speaker的信息,最终,生成特征向量 z 1 , z 2 , . . . , z n z_1, z_2, ..., z_n z1,z2,...,zn;

- 使用speaker encoder的输出,经过两个变换,生成两个向量 γ \gamma γ 和 β \beta β;

- 用 γ \gamma γ 和 β \beta β,对 z i z_i zi做处理, z i ′ = γ . z i + β z^{\prime}_i = \gamma . z_i + \beta zi′=γ.zi+β

接着,就像一般的auto-encoder一样,e2e的训练下去,就结束了

但是,上面介绍的过程是存在一个问题:训练阶段使用的是同一个人的声音,但是在使用阶段,却是用两个人的声音。这样,最后合成的声音效果,可能会不好。

如何解决这个问题呢?可以使用下面这种2nd stage training的方式。

在训练阶段,引入额外的criterion,譬如说,引入GAN的机制,让discriminator判断合成的语音是真实语音,还是合成的;也可以引入一个提前训练好的speaker classifier,用于判断输入的语音是哪一个speaker。

在第二阶段的训练过程,只训练一个patcher,用于合成语音,并将合成的语音与Decoder生成语音叠加在一起,合成新的语音。用这个新的合成语音,作为最终的语音。

3. Direct Transformation

下面介绍直接将speaker X的声音转换成speaker Y的声音,使用的方法就是CycleGAN。

3.1 CycleGAN

这里使用的CycleGAN就是图像风格迁移中使用的CycleGAN。

下面简单回顾一下CycleGAN的原理:

- 生成器 G X − > Y G_{X->Y} GX−>Y的作用是将speaker X的语音转成speaker Y的语音;

- Discriminator D Y D_Y DY的作用是判断生成的语音是Y的概率,越大越好;

如果仅有上述的 G X − > Y G_{X->Y} GX−>Y和 D Y D_Y DY,生成的语音很有可能会忽略掉speaker X的语音,而直接合成speaker Y常说的话,这也不是我们所期望的,那么,该怎么办呢?

解决上面问题的方法是:再引入一个生成器 G Y − > X G_{Y->X} GY−>X,作用是将Y的语音转成X的语音,最后,输入的X的语音与输出X的语音,尽可能的接近。

另一个小trick:在训练 G X − > Y G_{X->Y} GX−>Y的时候,可以输入Y的语音,输出也是Y的语音,应该让两者之间尽可能地接近,这样可以让整个训练过程比较稳定。

当然,我们也可以再引入一个反向的生成过程,就组成了完整的CycleGAN了。

3.2 StarGAN

接着,我们讲一下StarGAN,这是CycleGAN的进阶版。

在StarGAN中,我们需要对Generator和Discriminator做一些修改。

在StarGAN中,我们需要对Generator和Discriminator做一些修改。

在原先的Generator和Discriminator基础上,增加speaker的表示。这个是可以使用已经训练好的speaker encoder来完成。

接下来,我们看一下StarGAN的整体工作过程,其实,与CycleGAN就大同小异了。下图的上半部分是CycleGAN,下半部分是StarGAN

在训练StarGAN的时候,其实,还需要一个classifier,可以参看论文。

3.2 Blow

另外一种比StarGAN更进阶的技术,叫Blow

这里,就不再展开说明,可以参看论文。

关于flow-based model也可以看之前的视频介绍。