资源分享 | 情绪脑电研究公开数据集

SEED

SEED数据集是由上海交大类脑计算与机器智能研究中心(BCMI)开发的。该数据集是基于脑电的情绪分类任务而设计的数据集。该数据集记录了15名被试在观看积极、中性和消极情绪电影片段时的EEG信号,每个视频片段的时间为3-5分钟。每个参与者重复采集三天, 每次间隔天数大约一个星期。SEED数据集使用62通道的ESI NeuroScan设备以1 kHz的采样率进行记录,然后降采样至200Hz,并使用0-75Hz的带通滤波器去除EEG信号数据中的伪迹。

网址:

https://bcmi.sjtu.edu.cn/~seed/index.html

参考文献:

W.L. Zheng, J.Y. Zhu, B.L. Lu, Identifying stable patterns over time for emotion recognition from EEG, IEEE Trans. Affect. Comput. 10 (3) (2017) 417–429.

SEED-IV

SEED-IV由SEED数据集演变而来。SEED-IV使用64通道的ESI NeuroScan系统和SMI眼动仪收集了15名受试者(7位男性,8位女性)的数据。但与SEED数据集的不同之处在于,每个受试者每次实验都需要观看四种不同情绪的电影片段,其中每种情绪类别分别对应6个片段,即6个“快乐”,6个“悲伤”,6个“恐惧”和6个“中性”的电影片段,用来诱发实验所需的情绪。每个电影片段持续约2分钟。在观察过程中,受试者在观看2分钟电影片段之前收到5秒的提示,随后进行45秒的自我评估。每个参与者重复采集三天,并且每次间隔天数大约一个星期。EEG数据降采样至200Hz,并在1-70Hz的频率范围内进行带通滤波。

网址:

https://bcmi.sjtu.edu.cn/home/seed/seed-iv.html

参考文献:

W.L. Zheng, W. Liu, Y. Lu, B.L. Lu, A. Cichocki, Emotionmeter: a multimodal framework for recognizing human emotions, IEEE Trans. Cybern. 49 (3) (2018) 1110–1122.

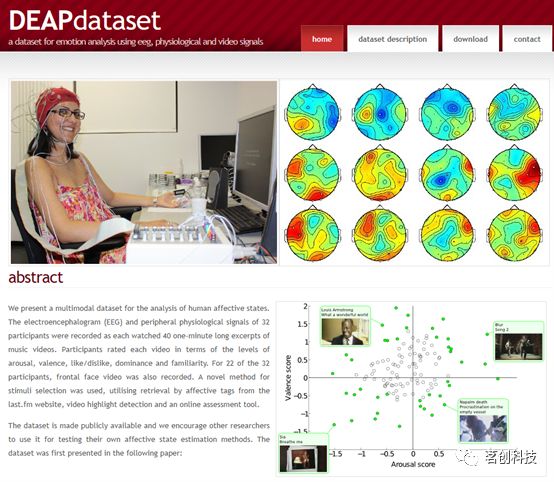

DEAP

DEAP数据集是一个较早公开的用于情绪分类的脑电数据集。DEAP数据集包含来自32名受试者的EEG和外周生理信号。根据国际上常用的10-20电极系统,记录每名受试者在观看40个1分钟的视频片段过程中产生的脑电信号,并采用Biosemi ActiveTwo设备收集数据。每个视频呈现后,让受试者根据唤醒、效价、喜爱度、优势度等方面进行自我评估。EEG数据采样率从512Hz降至128Hz,然后应用4.0-45Hz的带通滤波以消除EEG数据中的噪声。

网址:

http://www.eecs.qmul.ac.uk/mmv/datasets/deap/

参考文献:

S. Koelstra, C. Muhl, M. Soleymani, J.S. Lee, A. Yazdani, T. Ebrahimi, I. Patras, Deap: a database for emotion analysis using physiological signals, IEEE trans. affect. comput. 3 (1) (2011) 18–31.

MAHNOB-HCI

MAHNOB-HCI数据集通过多模态方法来识别情绪状态,其中包括面部视频、音频和脑电信号,以及外周/中枢神经系统生理信号。在该数据集中,通过32通道的头戴式设备以256Hz的采样率记录27名参与者在观看20个短视频(分为两个独立实验)期间的EEG信号。这些视频片段的持续时间从35到117秒不等。在第一个实验中,受试者观看了20个诱发情绪的视频,并报告他们所经历的情绪。在第二个实验中,首先呈现短视频和图像(此时并未附带任何标签),然后再次呈现带有正确和错误标签的视频和图像。需要参与者对这些标签进行判断并进行反馈,因此记录的视频和身体反应被分开并存储在数据库中。

网址:

https://mahnob-db.eu/hci-tagging/

参考文献:

M. Soleymani, J. Lichtenauer, T. Pun, M. Pantic, A multimodal database for affect recognition and implicit tagging, IEEE trans. affect. comput. 3 (1) (2011) 42–55.

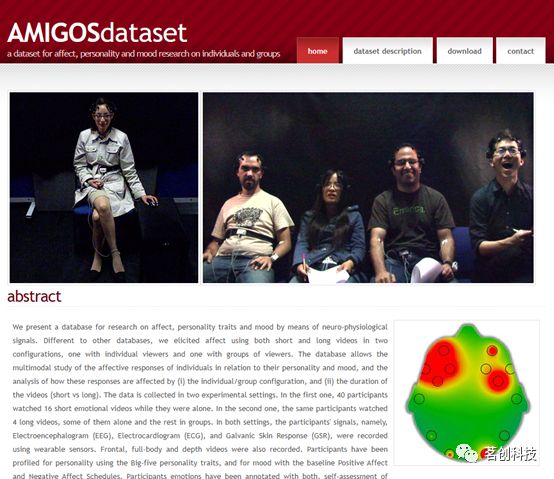

AMIGOS

AMIGOS数据集包括一个14通道的脑电信号和3个外周生理信号。数据是在两种实验设置下进行收集的,在第一阶段,包括40名受试者,要求他们观看16段情绪短片。在第二阶段,让受试者观看四段较长的视频,可以单独观看或以小组形式观看,同时记录他们的ECG、EEG和GSR信号。实验还录制了高清正面、全身和深度视频,以进行进一步的分析。在观看完视频后,受试者根据1-9级对自身的唤醒度、效价、喜好度和支配度进行了评估。在预处理过程中,将EEG信号降采样至128Hz,并应用4.0-45Hz的带通滤波以去除背景噪声。

网址:

http://www.eecs.qmul.ac.uk/mmv/datasets/amigos/index.html

参考文献:

J.A. Miranda-Correa, M.K. Abadi, N. Sebe, I. Patras, Amigos: a dataset for affect, personality and mood research on individuals and groups, IEEE Trans. Affect. Comput. 12 (2) (2018) 479–493.

MPED

MPED数据集由EEG、呼吸(RSP)和心电图(ECG)等模态生理信号组成。共包含23名受试者(其中10名男性和13名女性),他们观看了28段视频。这些视频刺激旨在诱发七种不同的情绪,即喜悦、幽默、愤怒、厌恶、恐惧、悲伤和中性。实验前,对所有刺激材料进行准确标记和评估,以确保达到预期的情绪水平。使用62通道ESI NeuroScan设备记录脑电信号,采样率为1 kHz。在预处理过程中,为了消除眼电(EOG)和肌电(EMG)伪迹,对原始EEG信号进行手动滤波处理。

网址:

https://github.com/Tengfei000/MPED

参考文献:

T. Song, W. Zheng, C. Lu, Y. Zong, X. Zhang, Z. Cui, MPED: a multi-modal physiological emotion database for discrete emotion recognition, IEEE Access 7 (2019) 12177–12191.

AffectNet

AffectNet是一个面部表情数据库。AffectNet包含100多万张面部图像,其中约一半的图像(约44万张)进行了七种离散面部表情(分类模型)以及效价和唤醒度(维度模型)的手动标注。AffectNet是迄今为止规模最大的面部表情、效价和唤醒度数据库,可以在两种不同的情绪模型中进行自动面部表情识别的研究。该研究使用两种基线深度神经网络对图像进行分类(分类模型),并预测了效价和唤醒度的强度(维度模型)。各种评估指标表明,深度神经网络性能超过了传统机器学习方法和现有的面部表情识别系统。

网址:

http://mohammadmahoor.com/affectnet/

参考文献:

Mollahosseini A, Hasani B, Mahoor M H. Affectnet: A database for facial expression, valence, and arousal computing in the wild. IEEE Transactions on Affective Computing, 2017, 10(1): 18-31.

DREAMER

DREAMER数据集是一个多模态数据集,该数据集包括来自23名受试者的EEG和ECG信号。这些信号通过14通道EEG电极进行采集,采样率为128Hz。在受试者观看18个视频片段时收集EEG数据,每个视频片段旨在引发九种基本情绪之一,即平静、愉悦、愤怒、悲伤、快乐、厌恶、兴奋、惊讶和恐惧。这些视频在65-393秒的时间内持续播放,从而诱发受试者的情绪体验。受试者在1-5级评分量表上对其唤醒度、效价和支配度进行自我评估。每位参与者的数据集分为三个部分:1)与平静相关的18个基线信号段;2)经验信号段;3)18个相关标签。

网址:

https://www.zenodo.org/record/546113

参考文献:

S. Katsigiannis, N. Ramzan, DREAMER: a database for emotion recognition through EEG and ECG signals from wireless low-cost off-the-shelf devices, IEEE j. biomed. health inf. 22 (1) (2017) 98–107.

DECAF

DECAF是一个多模态情绪数据集。与DEAP和MAHNOB-HCI等数据集不同,DECAF包含(1)使用脑磁图(MEG)传感器获取大脑信号,该传感器几乎不需要与用户的头皮进行物理接触,从而促进了更自然的情感反应;(2)30名参与者对DEAP中使用的40个一分钟音乐视频片段和36个电影片段的外显和内隐情感反应,从而实现了EEG与MEG模式以及电影与音乐刺激的情感识别比较。除MEG数据外,DECAF还包括同步记录的近红外(NIR)面部视频、水平眼电图(hEOG)、心电图(ECG)和斜方肌肌电图(tEMG)外周生理反应数据。

网址:

https://decaf-dataset.github.io/

参考文献:

M. K. Abadi, R. Subramanian, S. M. Kia, P. Avesani, I. Patras, and N. Sebe, “DECAF: MEG-based multimodal database for decoding affective physiological responses,” IEEE Trans. Affective Comput., vol. 6, no. 3, pp. 209–222, Jul. 2015.

SDEA

SDEA数据集包括30名受试者(13名男性和17名女性)的EEG信号,平均年龄为20岁。在参与者观看12个中文视频片段后记录EEG数据,这些视频旨在引发中性、幽默和愤怒三种情绪。为了诱发目标情绪状态,使用了经过心理学方法验证的MPED刺激。在采集EEG信号之前,进行主观自我评估,以确保参与者的情绪状态与刺激材料相一致。使用16通道NeuroScan设备以1 kHz的采样率记录数据。

参考文献:

T. Song, W. Zheng, S. Liu, Y. Zong, Z. Cui, Y. Li, Graph-Embedded convolutional neural network for image-based EEG emotion recognition, IEEE Trans. Emerg. Topics Comput. 10(3) (2021 Jun 8) pp. 1399-1413.

DAI-EF

DAI-EF数据集由脑电信号和面部表情组成,用于情绪识别。该数据集通过对视频片段的生理和行为反应来确定情绪。采用64通道Biosemi ActiveTwo装置采集脑电信号,并收集了GSR、呼吸、眼动和面部视频信号。在预试验期间,除了中性情绪场景外,还选择100个视频片段来引发受试者的情绪状态。这些视频是从热门商业广告和用户制作的视频中截取的短片段(1-2分钟)。然后,20名参与者基于六种基本情绪(即愤怒、厌恶、恐惧、喜悦、悲伤和惊讶)对这些视频片段进行评分(7点李克特量表)。

参考文献:

S. Rayatdoost, M. Soleymani, Cross-corpus EEG-based emotion recognition, in: 2018 IEEE 28th International Workshop on Machine Learning for Signal Processing (MLSP), IEEE, 2018, September, pp. 1–6.

LUMED

LUMED-2数据集是由英国拉夫堡大学和土耳其哈塞特佩大学合作创建的多模态情绪数据集。该数据集记录了13名受试者在接受音频和视觉刺激时的EEG信号。所有刺激的总持续时间为8分钟50秒,并从互联网上选取视频片段用于引发特定的情绪。在每个视频片段之间,会呈现一个20秒的灰屏,以让受试者有机会休息。每个阶段结束后,要求受试者根据快乐、悲伤或中性类别来表示他们的情绪状态。此外,使用640×480像素、30帧/秒的网络摄像头捕捉受试者的面部表情。EEG信号采用8通道的ENOBIO设备以500Hz的采样率进行记录,然后通过0-75Hz范围的带通滤波器进行预处理。

参考文献:

Y. Cimtay, E. Ekmekcioglu, S. Caglar-Ozhan, Cross-subject multimodal emotion recognition based on hybrid fusion, IEEE Access 8 (2020) 168865–168878.

注:以上所有脑电情绪研究的参考文献可在公众号后台回复关键词“情绪脑电”获取。同时欢迎大家在下方留言补充更多的情绪脑电研究公开数据集,感激不尽。