国科大 高级人工智能 期末复习总结

大家好!又到了期末时间,各位国科大的师弟师妹们,师兄帮你们总结了高级人工智能的考点,如果你好好复习了,那么这篇博文能帮你上90;如果没有也不要怕,认真看了这篇博文,也能保你70。下面我们开始吧,更多考试知识点请关注公众号“算法岗从零到无穷”。转载请注明出处。

目录

- 往届考试知识点

- 知识点罗列

- 概念

- 搜索

- 深度学习

- 命题逻辑与一阶谓词逻辑

- 命题逻辑

- 一阶谓词逻辑

- 群体智能

- 强化学习

- 博弈论

- 老师上课讲的考点

- 行为主义

- 符号主义

- 必复习的知识点

- 有时间可复习的知识点

- 例题讲解

- 大胆押题

- 选择题

- 计算题

- 参考博客

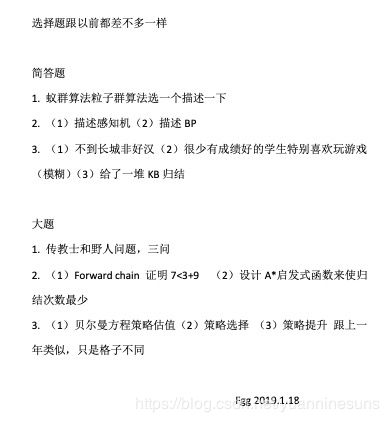

往届考试知识点

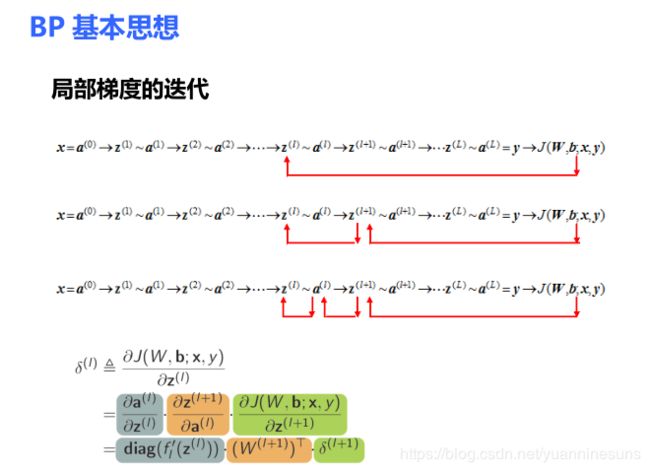

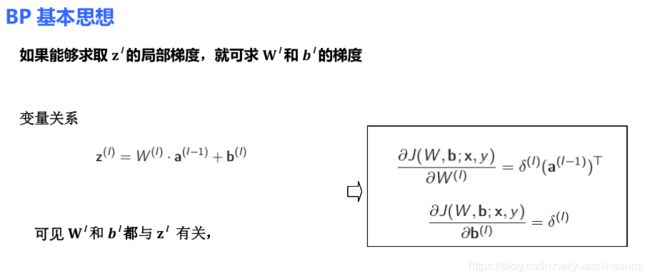

- BP

- GAN

- 搜索

- 田忌赛马

- Transaction Database

- 感知机

- 玻尔兹曼机

- A*搜索

- 语义网络:一阶谓词逻辑,模糊逻辑

- 蚁群优化算法和粒子群算法

- 网络交互博弈

- 遗传算法

- 信息熵

- deep belief networks

- 人工智能三大分支

- 野人与传教士

- 多臂赌博机

- 每年的大题都是强化学习

知识点罗列

概念

- 人工智能概念性定义:机器智能,类脑智能,群体智能

- 人工智能三大学派:符号主义学派,联结主义学派,行为主义学派

搜索

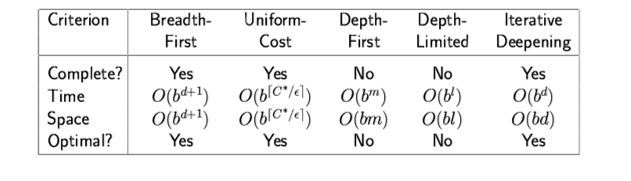

- 深搜一般来说时间复杂度大但空间复杂度小,广搜空间相反。深度优先适合深度大的树,不适合广度大的树,广度优先正相反

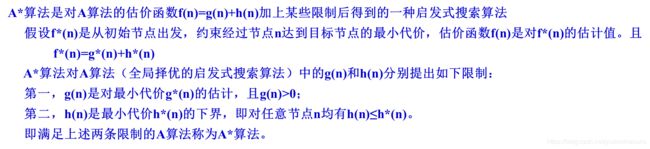

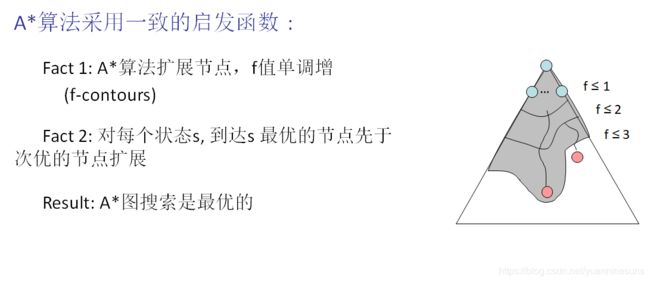

- 图A*算法是最优的条件是一致性;树A*算法是最优的条件是可采纳性

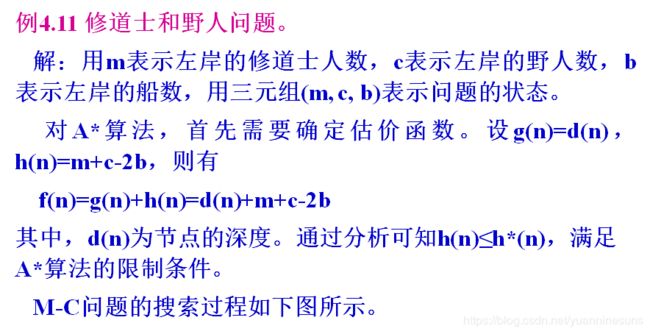

- 传教士和野人问题的A* 搜索

- 爬山法搜索

可在任意位置起始

重复: 移动到最好的相邻状态,不允许向山下移动

如果没有比当前更好的相邻状态,结束 - 当未知梯度的时候,用蚁群算法或者粒子群算法

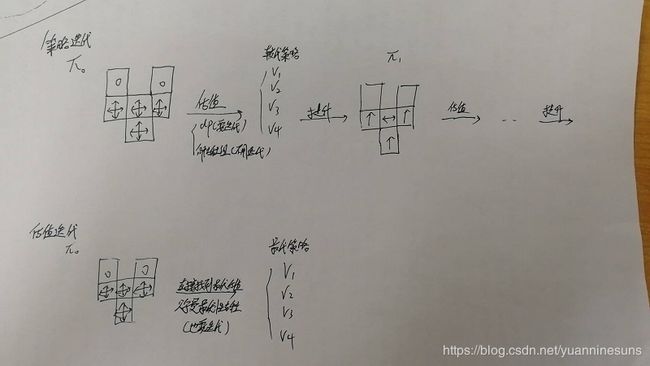

- 遗传算法

基于适应度函数,在每步中保留 N 个最好状态

配对杂交操作

产生可选的变异

问题的目标函数天然的可作为遗传算法的适应度函数 - 贪婪最佳优先搜索不是完备的

- 爬山算法与模拟退火算法:

爬山算法就是一只兔子看到一座山峰,然后跳来跳去最后跳上山顶模拟退火就是一只喝醉的兔子,一开始乱跳,过一会酒醒了,然后再跳上山顶。爬山算法也是一个用来求解最优化问题的算法,每次都向着当前上升最快的方向往上爬,但是初始化不同可能会得到不同的局部最优值。模拟退火算法就可能跳出这种局部最优解的限制。模拟退火算法也是贪心算法,但是在其过程中引入了随机因素,以一定的概率接受一个比当前解要差的解,并且这个概率随着时间的推移而逐渐降低。

深度学习

- 局部感受野的基础:图像的空间联系也是局部的像素联系较为紧密,而距离较远的像素相关性则较弱

- 局部感受野的作用:减少了需要训练的权值数目。一张图片距离很远的点关联很小,所以我们就相当于从全连接方式省下了一部分参数,只进行局部运算,所以参数就少了

- 权值共享的基础:图像的一部分的统计特性与其他部分是一样的。在输入的不同位置检测同一种特征。这也就是为什么卷积层往往会有多个卷积核(甚至几十个,上百个),因为权值共享后意味着每一个卷积核只能提取到一种特征,为了增加CNN的表达能力,当然需要多个核。

- 权值共享的作用:对于一张图像,计算的方式一样,也就是特征提取的方式一样,这个过程就是 我们拿着卷积核的那个框框 ,不断在原输入图像上滑动的过程 ,所有框框内部的数据计算方式一样,这就是 “参数共享”,这样就大大减少了参数值,毕竟权重都是一样的嘛。

- 卷积层的作用:特征提取

- padding的作用:每次卷积,图像都缩小,这样卷不了几次就没了; - 相比于图片中间的点,图片边缘的点在卷积中被计算的次数很少。这样的话,边缘的信息就易于丢失。为了解决这个问题,我们可以采用padding的方法。我们每次卷积前,先给图片周围都补一圈空白,让卷积之后图片跟原来一样大,同时,原来的边缘也被计算了更多次。

- padding的种类:0填充,边界复制,镜像,块复制

- 池化层的作用:对不同位置的特征进行聚合统计。池化层可以非常有效地缩小矩阵的尺寸,从而减少最后全链层中的参数,使用池化层既可以加快计算速度也有防止过拟合问题的作用

- 池化层的分类:最大池化用的最多,平均池化用的相对比较少

- 池化层没有需要学习的参数

- 为什么神经元要加偏置项:如果没有偏置的话,我们所有的分割线都是经过原点的,但是现实问题并不会那么如我们所愿.都是能够是经过原点线性可分的

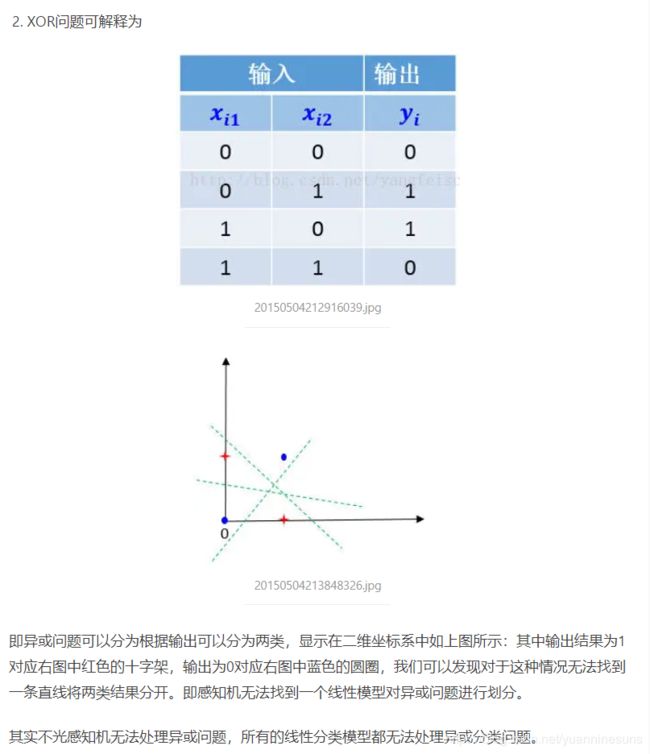

- 为什么感知机无法处理异或:

- Hopfield神经网络:Hopfield神经网络,他是反馈式类型,其神经元的结构功能及其在⽹络中的地位是⼀样的。他的学习规则是基于灌输式学习,即网络的权值不是通过训练出来的,而是按照一定规则计算出来的,将要求解的问题转化为优化问题的能量函数,⽹络的稳定状态是优化问题的解,其权值一旦确定就不在改变。

- 自编码器,RBM,DBN,DBM的概念

自编码器:我们将input输入一个encoder编码器,就会得到一个code,这个code也就是输入的一个表示,那么我们怎么知道这个code表示的就是input呢?我们加一个decoder解码器,这时候decoder就会输出一个信息,那么如果输出的这个信息和一开始的输入信号input是很像的(理想情况下就是一样的),那很明显,我们就有理由相信这个code是靠谱的。所以,我们就通过调整encoder和decoder的参数,使得重构误差最小,这时候我们就得到了输入input信号的第一个表示了,也就是编码code了。因为是无标签数据,所以误差的来源就是直接重构后与原输入相比得到。自编码器可用于深度学习参数的预训练,有稀疏自编码器、降噪自编码器等分类。

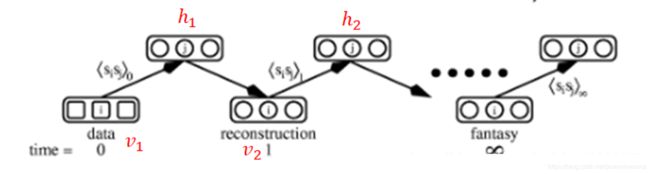

RBM:受限玻尔兹曼机,假设有一个二部图,每一层的节点之间没有链接,一层是可视层,即输入数据层(v),一层是隐藏层(h),如果假设所有的节点都是随机二值变量节点(只能取0或者1值),同时假设全概率分布p(v,h)满足Boltzmann 分布,我们称这个模型是Restricted BoltzmannMachine (RBM)。

首先在可见层输入数据data如上图的v1,刚开始网络的权值和偏置值会初始化一个值,快速学习算法就会根据这些权值在可见层已知的情况下计算每个隐层的神经元的概率,此时我就得到了所有隐层神经元的值h1,我们这时候把可见层当做是未知的,根据类似的求概率的方法求出可见层神经元的值v2,此时我们的学习算法得到了他们的差值v1-v2,然后根据这个差值进行调整权值和偏置值,这就是一次权值调整了,然后我们把v2看做已知的,按照上面类似的求法继续求出h2,然后再次求出v3,此时在和v1相减,得到误差信号,重新调整权值,然后不断的这样迭代,随着迭代的次数增加,整个系统就会达到热平衡状态,此时系统就收敛了。

DBN:深度置信网络, DBNs由多个限制玻尔兹曼机(Restricted Boltzmann Machines)层组成。这些网络被“限制”为一个可视层和一个隐层,层间存在连接,但层内的单元间不存在连接。隐层单元被训练去捕捉在可视层表现出来的高阶数据的相关性。

DBM:

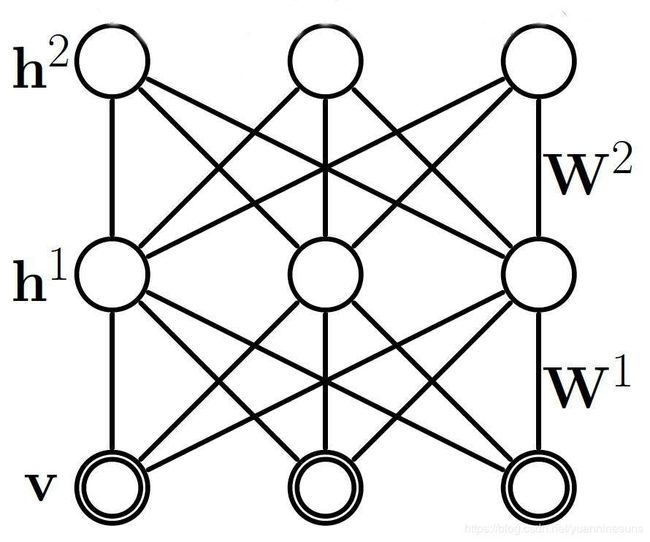

深度玻尔兹曼机是一种以受限玻尔兹曼机(RBM)为基础的深度学习模型,其本质是一种特殊构造的神经网络。深度玻尔兹曼机由多层受限玻尔兹曼机叠加而成的,不同于深度置信网络(Deep Belief Network),深度玻尔兹曼机的中间层与相邻层是双向连接的。接下来举例说明深度玻尔兹曼机的基本结构和特征。如图1所示是一个包含两个隐藏层(hidden layer)的深度玻尔兹曼机。h1和h2代表隐藏层(hidden layer)各节点的状态,W1和W2表示神经网络层间链接的权值(weights)。v表示可见层(visible layer)各节点的状态。每个节点的状态都在0和1之间二选一,也就是说v,h ∈ {0,1}。为方便显示,这里忽略了模型中各单元的偏置(bias)。

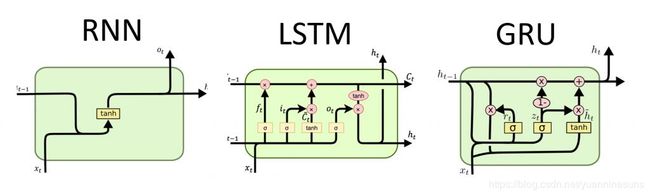

- LSTM与GRU

- GAN:GAN 的核⼼思想来源于博弈论的纳什均衡:⽣成器(⽣成⼀个数据,会被判别结果优化)+ 判别器(判断是否是⽣成器⽣成的):⽣成器的⽬的是尽量去学习真实的数据分布。把噪声数据 z(也就是我们说的假数据)通过⽣成模型 G,伪装成了真实数据 x。判别器的⽬的是尽量正确判别输⼊数据是来⾃真实数据还是来⾃⽣成器。各⾃提⾼⾃⼰的⽣成能⼒和判别能⼒, 这个学习优化过程就是寻找⼆者之间的⼀个纳什均衡

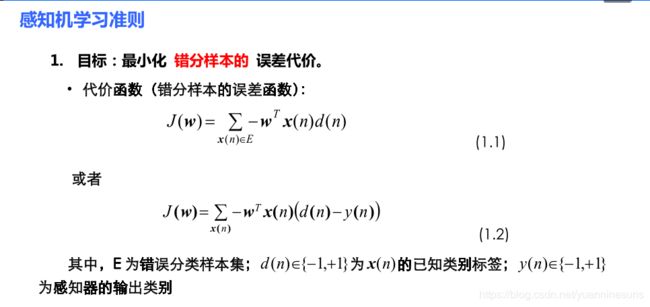

- 感知机

- DP

命题逻辑与一阶谓词逻辑

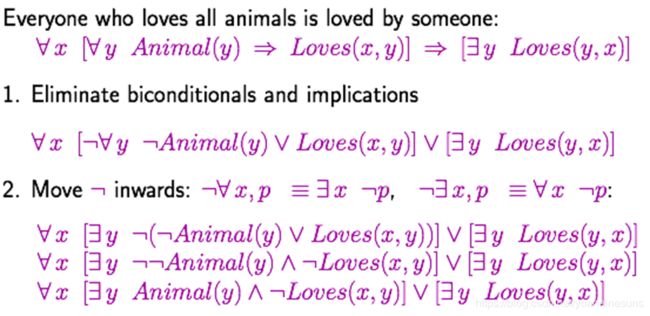

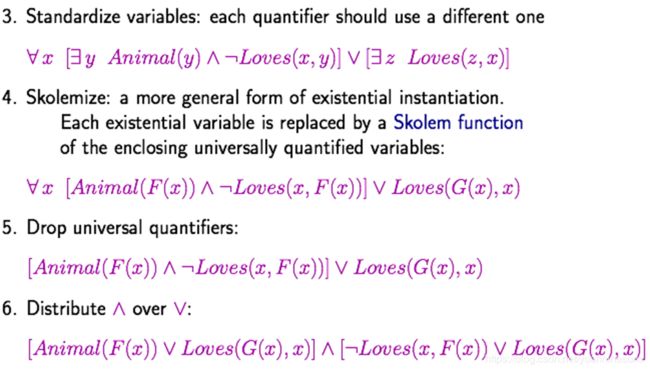

每一个逻辑都有两个内容:从语义的角度能够蕴含一些新的知识库(新的知识,是正确的)。还会从语法的角度推演,自动推演出新的知识库(每一个sen都是一堆符号,通过形式上推演,推演出新的sen,这个和语义无关,是从符号上推演出的一种规则)。所以每一个逻辑含有两个内容:语义上蕴含+形式上推演。那么我们在研究的时候会证明两个性质:可靠性和完备性。

命题逻辑

任何一个逻辑都有自己的语言,我们会看这个逻辑的syntax语法和semantics语义两个部分。命题逻辑中proposition表示一个宣告式的句子,必须为True或者False。比如P=NP,虽然没人证明,但是到底,它一定是真或者假,二者之一;所以它也是一个命题。不可能同时为true和false。

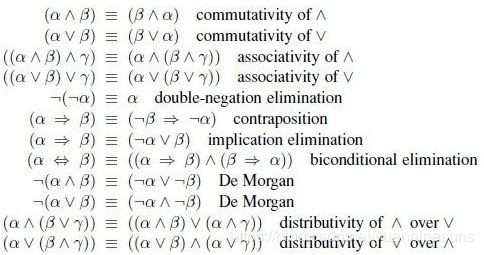

命题逻辑(proposition logic)是应用一套形式化规则对以符号表示的描述性陈述进行推理的系统。在命题逻辑中,一个或真或假的描述性陈述被称为原子命题,若干原子命题可通过逻辑运算符来构成复合命题。如果已知若干命题,则可通过命题联结词(connectives)对已有命题进行组合 , 得 到 新 命 题 。 这 些 通 过 命 题 联 结 词 得 到 的 命 题 被 称 为 复 合 命 题 (compound proposition)。【其实就是与或非条件和双向条件的来回转化或者证明】

一般会通过真值表来计算复合命题的真假。

逻辑等价:

命题逻辑中的几个证明例题:

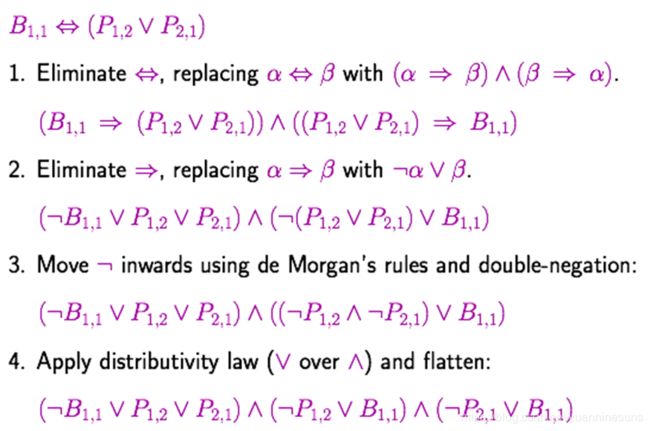

将任何式子改成合取范式的形式,先把双箭头和单箭头去掉,neg进入括号,最后只有and or的这种式子 :

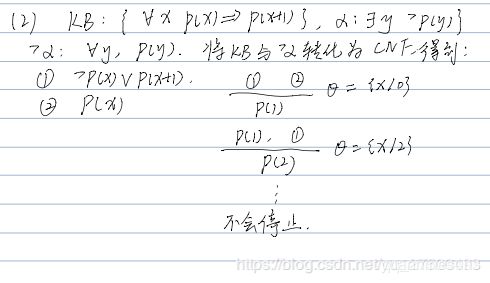

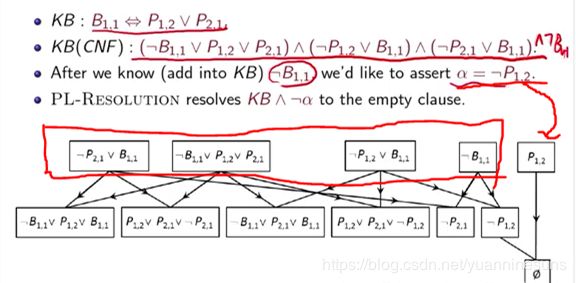

归结原理的例子:

一阶谓词逻辑

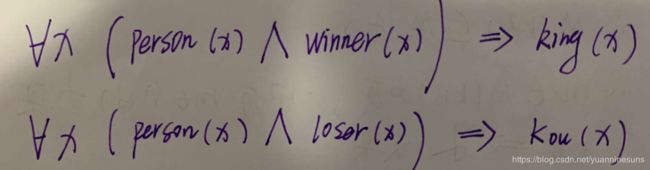

在谓词逻辑中,原子命题可分解成个体和谓词。个体是可独立存在的事或物,谓词则是用来刻划个体具有某些性质.一个陈述句可分为两个部分,分别是个体和谓词。谓词在形式上就是陈述句 中刻画关系的部分,譬如可“x<11”这句陈述分解为个体(x)和谓词(<11) 两个,其中“<11”刻画了“小于11”这种关系。谓 词 逻 辑 中 两 个 核 心 概 念 : 谓 词 ( predicate ) 和 量 词 (quantifier)。量词:存在量词(existential quantifier)和全称量词(universal quantifier)。

群体智能

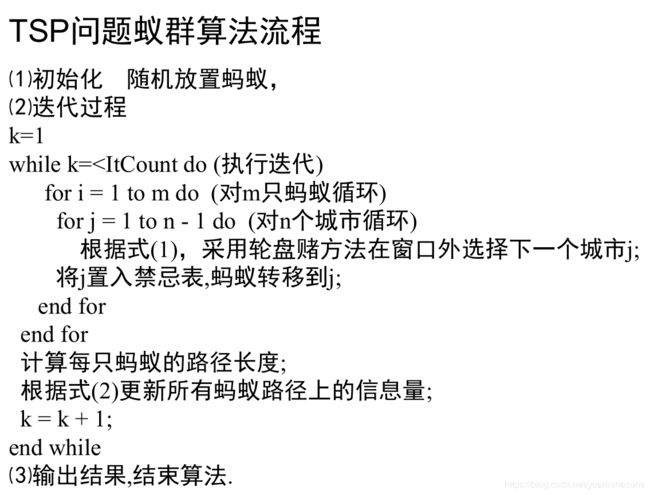

- 蚁群优化算法阐述基本原理、算法过程和适用范围

基本原理:

简单回答:蚁群优化算法是一种解空间搜索方法,利用局部随机搜索和自增强在图上寻找最优路径。个体通过释放信息素改变环境,个体能够感知环境的实时变化,个体间通过环境实现间接通信。

复杂回答:用蚂蚁的行走路径表示待优化问题的可行解,整个蚂蚁群体的所有路径构成待优化问题的解空间。路径较短的蚂蚁释放的信息素量较多,随着时间的推进,较短的路径上累积的信息素浓度逐渐增高,选择该路径的蚂蚁个数也愈来愈多。最终,整个蚂蚁会在正反馈的作用下集中到最佳的路径上,此时对应的便是待优化问题的最优解。其思想是“局部随机搜索+自增强”

算法过程:

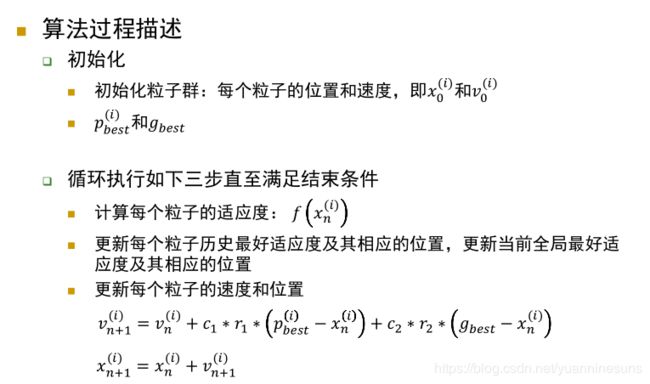

适用范围:适用于离散问题最优解 - 粒子群优化算法阐述基本原理、算法过程和适用范围

基本原理:粒子群优化算法是一种基于种群寻优的启发式搜索算法。通过粒子群在解空间中进行搜索,寻找最优解,每个粒子都可以获得其邻域内其它个体的信息,对所经过的位置进行评价,并根据这些信息,按照更新规则,改变位置和速度的状态量。随着这一过程的不断进行,粒子群最终能够找到问题的近似最优解。

算法过程:

适用范围:适用于求解连续解空间的优化问题

强化学习

-

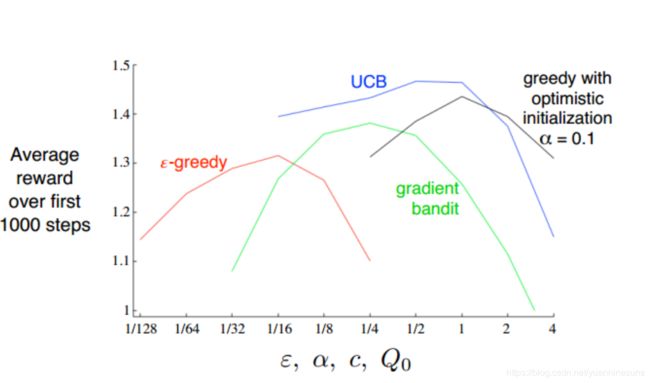

多臂赌博机

贪心策略:第t轮采取行为a的期望奖励 q ∗ ( a ) q_* \left( a \right) q∗(a)已知,每次都选最大的a

ε \varepsilon ε贪心策略: 1 − ε 1-\varepsilon 1−ε按照贪心策略进行行为选择——Exploitation,以概率 ε \varepsilon ε在所有行为中随机选择一个——Exploration, ε \varepsilon ε的取值取决于 q ∗ ( a ) q_* \left( a \right) q∗(a) 的方差,方差越大 ε \varepsilon ε取值应越大

前述贪心策略中,每个行为的初始估值为0

乐观初值法:为每个行为赋一个高的初始估值,好处是初期每个行为都有较大机会被explore

UCB:该方法选择的策略是当前估值高,且被选择的次数少的a。最终会收敛到贪心策略。

梯度赌博机算法:和前面的确定策略不同,梯度赌博机是一种随机策略。按照偏好程度,计算softmax的值,随机以概率抽样选择a

UCB表现较好

博弈论

- 以田忌赛马为例,局中人是田忌和秦王(假设局中人是自私的理性人);田忌的策略集合是{上中下、上下中、中上下、中下上、下上中、下中上}。每个局中人的目的都是最大化自己的效用函数

- 针对局中人2的策略t,若局中人1用策略s产生的收益大于或等于其任何其他策略,则称策略s是局中人1对局中人2的策略t的最佳应对

- 纳什均衡:如果一个局势下,每个局中人的策略都是相对其他局中人当前策略的最佳应对,则称该局势是一个纳什均衡。纳什均衡是一个僵局,即给定其他人不动,没有人有动的积极性;谁动谁吃亏

- 任何有限博弈都至少存在一个纳什均衡,但不一定是纯策略纳什均衡

- 社会最优的结果一定也是帕累托最优的结果,但帕累托最优不一定是社会最优

- 在性别大战案例中,纳什均衡等价于minmax策略,即抑制对手策略

- 在零和博弈情况下,minmax和maxmin是对偶的,minmax策略和maxmin策略等价于纳什均衡策略

- 最优匹配对于个体而言不一定最优,甚至是最差的

- 市场结清价格:给定买方报价的情况下,如果卖方的某种价格使得对应的买方偏好图中存在完全匹配,则称卖方的这组价格为市场结清价格。对于任意买方估价,市场结清价格一定存在

- 对于结局中 未参与配对的边,如果边的两个端点获得的收益之和小于1,则称这条边为不稳定边。如果一个结局中不存在不稳定边,则称该结局为稳定结局。给定一个结局,如果结局中的任意一个 参与配对的边都满足纳什议价解的条件,则称该结局是均衡结局。均衡结局一定是稳定结局。所以,在寻找均衡结局时,可以先寻找稳定结局,进而确定均衡结局。

老师上课讲的考点

行为主义

- 图灵测试是什么?意味着什么?图灵测试是判断一个智能体从行为上是否和人表现的一样。通过图灵测试也不一定有人的智能,只是行为表现上和人一样。

- 人工智能的三个学派,联结主义,符号主义,行为主义

- 蚁群算法(离散问题)与粒子群算法(连续问题)的理解,能简述道理,梯度不知道的情况下都可以用到

- 多臂赌博机(乐观初值法,UCB,梯度赌博机的基本原理),马尔科夫决策过程

- 强化学习考格子题。GridWorld会考一个4个参数的题,先写出估值函数,问当前的最优策略是什么,然后策略提升。题目只要两步就收敛了,而且正好是个整数

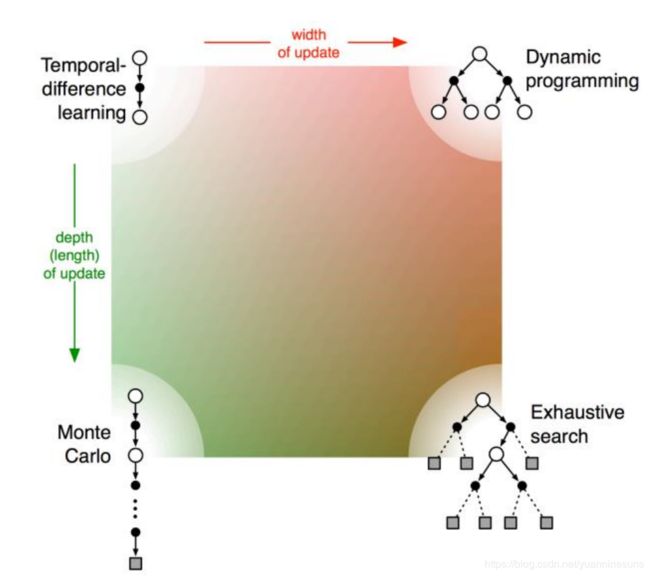

- 策略学习四个要考(dp,蒙特卡洛模拟,时序差分)(考试只会考dp)但是要知道这四个的概念

- 博弈的基本概念

- maxmin minmax的陈述,还有均衡的陈述

符号主义

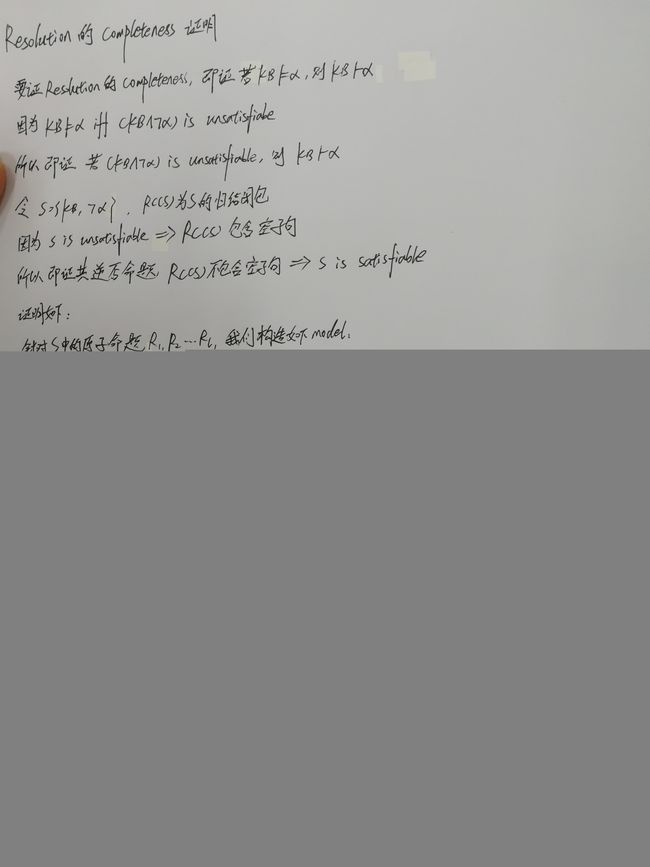

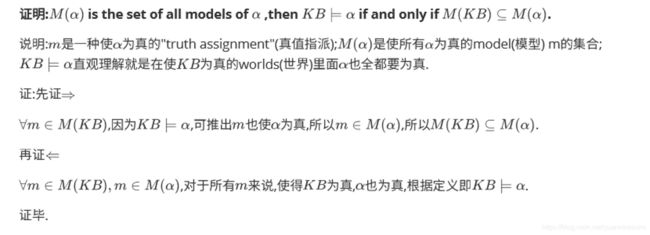

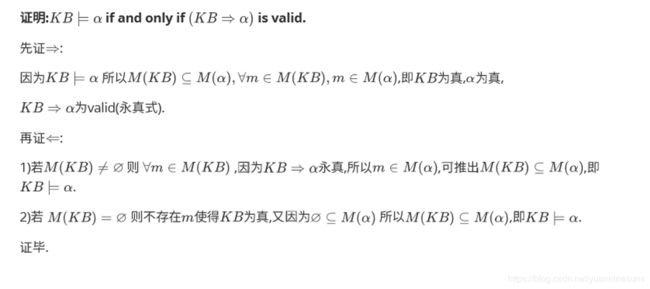

- 命题逻辑的归结原理的完备性和可靠性证明

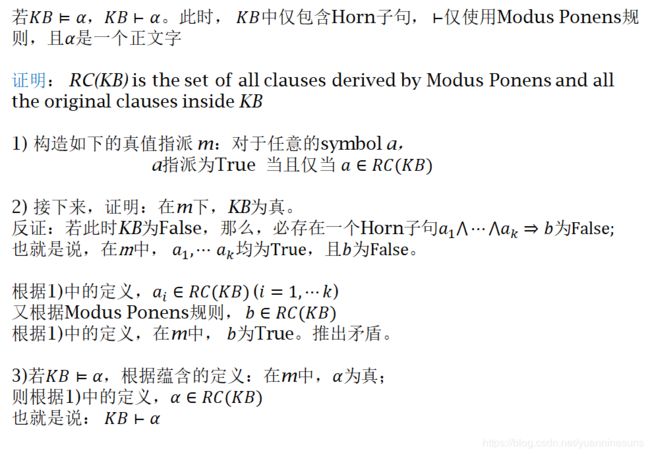

- 命题逻辑的Modus Ponens的完备性和可靠性证明

- 老师的话

我的课程讲了两部分:确定性的知识和非确定性的知识。非确定性知识,就是讲的模糊数学,主要需要掌握:如何用模糊的方法去表达一些“模糊”的概念。在确定性知识方面,主要讲了两种逻辑,命题逻辑和一阶谓词逻辑。讲授一种逻辑的时候,都遵从如下的授课思路:

- 首先定义该逻辑合法的语言:

- 定义合法的逻辑语句的语义;从而引出,逻辑蕴含的概念;

- 给出形式推演系统:归结原理和Modus Ponens for Definite Clauses;证明推演系统是可靠的和完备的

必复习的知识点

| ppt | 重点内容 | 页数 |

|---|---|---|

| new5搜索 | 搜索部分的例子,很可能会考 | |

| Search-第二讲 | 爬山,模拟退火,遗传算法可能会考 | ppt最后几页 |

| 图搜索 | 74页开始 | |

| Artificial Neural Networks | 多层感知机 | |

| BP算法 | ||

| Hopfield网络 | ||

| 深度神经网络 | 自编码器,DBN,DBM | |

| DL for image | 卷积 池化 残差 | |

| DL for sequence | beam search | |

| GAN |

有时间可复习的知识点

- 混合策略纳什均衡会出一道计算题

- 匹配市场会出一道计算题

例题讲解

-

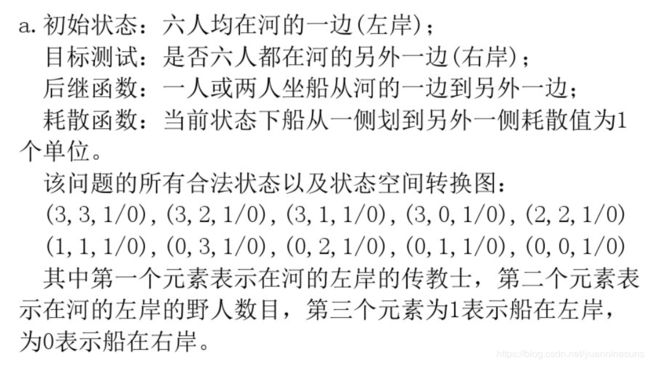

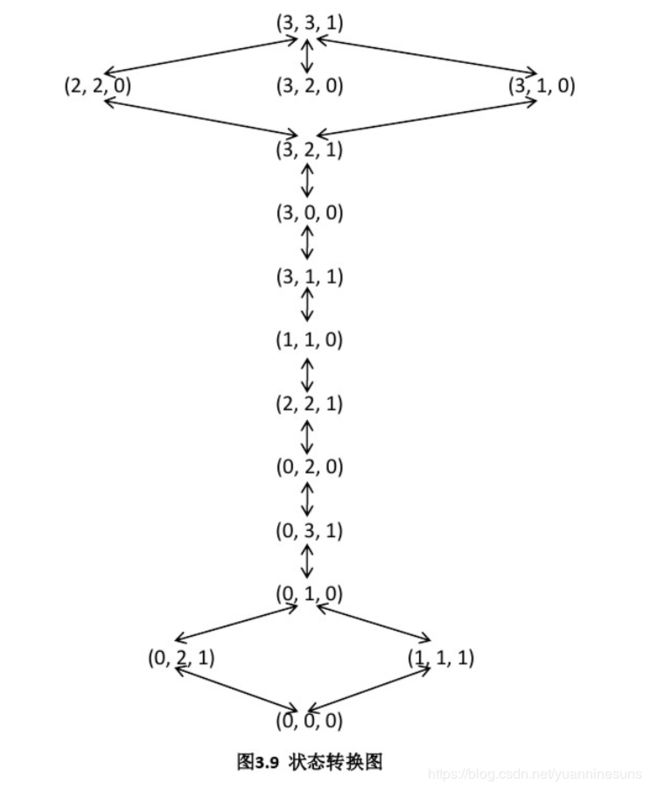

传教士和野人问题通常描述如下:三个传教士和三个野人在河的一边,还有一- 条能载-一个人或者两个人的船。找到一个办法让所有的人能渡到河的另一-岸,要求在任何地方野人数都不能多于传教士的人数。

a.精确地形式化该问题,只描述确保该问题有解所必需的特性。画出该问题的完全状态空间。

b.用一个合适的搜索算法实现和最优地求解该问题,检查重复状态是个好主意吗?

c.这个问题的状态空间如此简单,你认为为什么求解它却很困难?

-

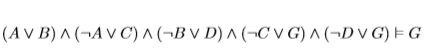

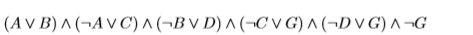

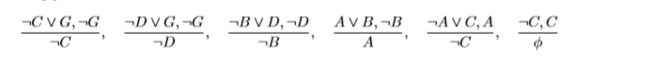

利用resolution归结原理证明下面式子

解:我们可以通过证明下面的式子是unsatisfiable的,进而证明原式:

因为,resolution归结原理是soundness可靠的,我们只需要证明归结得到的KB中包含空子句即可。归结过程如下:

证明结束。 -

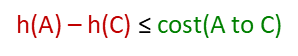

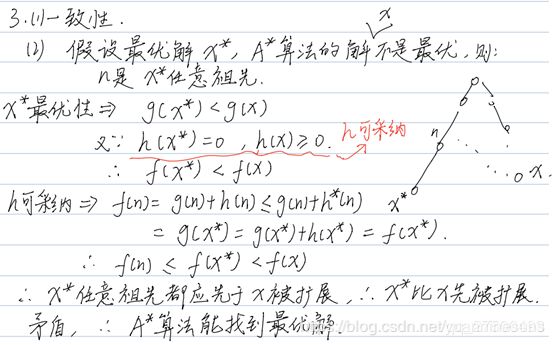

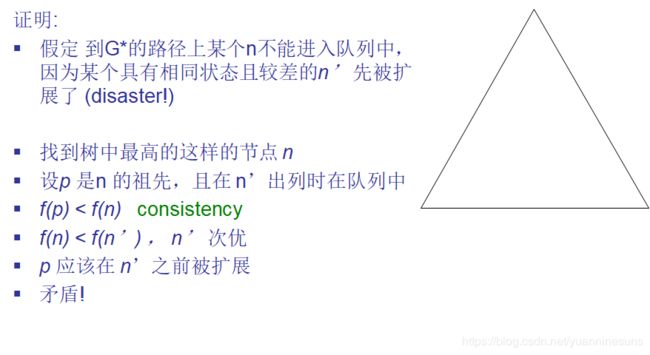

证明A*树搜索最优的条件是启发式函数h(n)是可采纳的;A*图搜索的最优性条件是启发式函数h(n)是一致性的

可采纳性的意义:

一致性的意义:

即沿路径的节点估计耗散 f 值单调递增

A*树搜索最优的条件是启发式函数h(n)是可采纳的,证明如下:

A*图搜索最优的条件是启发式函数h(n)是一致性的,证明如下:

大胆押题

选择题

- 结局的稳定性

- 纳什均衡判断

计算题

- 蚁群优化算法和粒子群优化算法选一个阐述基本原理、算法过程和适用范围

- 一阶谓词逻辑/模糊集的应用(句子转化,句子表示,模糊集表示,模糊集的交并计算)

- A*(图/树)搜索最优性证明或者传教士与野人问题

- 深度学习相关问题

- resolution或者mp的完备性证明,用归结原理推导一些东西

- 格子问题

参考博客

历届考题

知识点详细复习

师兄给各位师弟师妹推荐一个公众号——“算法岗从零到无穷”,里面有国科大各种考试的复习资料和选课指导如自然语言处理、机器学习、模式识别、图像处理、算法等等,免费阅读。另有算法岗面试技巧以及知识点,供各位求职的同学参考。