相机模型和双目立体匹配完成一个基于KITTI立体相机采集图片的立体图像匹配程序,生成视差图像和3D点云图像

机模型和双目立体匹配完成一个基于KITTI立体相机采集图片的立体图像匹配程序,生成视差图像和3D点云图像

- 一、针孔相机模型

- 二、双目相机模型

- 三、OpenCV实例实现用Pangolin生成视差图像和3D点云图像

- 1.新建一个文件夹(我的名字是test)

- 2.在test文件夹下新建一个空的CMakeLists.txt文件

- 3.在test文件夹下打开新的终端,编译

- 4.在test目录下创建一个main.cpp文件

- 5.运行方法:

一、针孔相机模型

其中P点是三维空间中的一点,P’点是P在图片上的投影点,O是相机坐标系的原点,O’是物理成像平面的原点。可得Z/f=X/X’=Y/Y’,即:X’=fX/Z,Y’=fY/Z,其中[X,Y,Z]是P点在相机坐标系的坐标。

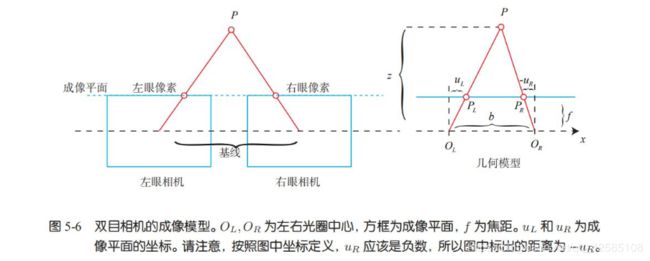

二、双目相机模型

双目相机一般由水平放置的左眼相机和右眼相机组成,可以把两个相机都看作针孔相机。因为是水平放置的,意味着两个相机的光圈中心都位于x轴上,两者之间的距离称为双目相机的基线(Baseline)。双目相机的成像模型如下:

三、OpenCV实例实现用Pangolin生成视差图像和3D点云图像

1.新建一个文件夹(我的名字是test)

2.在test文件夹下新建一个空的CMakeLists.txt文件

3.在test文件夹下打开新的终端,编译

cmake后会生成很多编译的中间文件以及makefile文件,所以一般建议新建一个新的目录,目录名为build.

make根据生成makefile文件,编译程序。

mkdir build

cd build

cmake ..

make

4.在test目录下创建一个main.cpp文件

#include 5.运行方法:

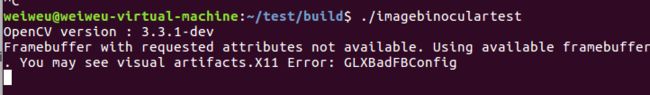

在build目录下,打开终端

./imagebinoculartest

原始左右两图: