- 最新基于MATLAB机器学习、深度学习实践技术应用

weixin_贾

python深度学习MATLAB编程matlab机器学习深度学习

近年来,MATLAB在机器学习和深度学习领域的发展取得了显著成就。其强大的计算能力和灵活的编程环境使其成为科研人员和工程师的首选工具。在无人驾驶汽车、医学影像智能诊疗、ImageNet竞赛等热门领域,MATLAB提供了丰富的算法库和工具箱,极大地推动了人工智能技术的应用和创新。系统学习机器学习和深度学习的理论知识及对应的代码实现方法,掌握图像处理的基础知识,以及经典机器学习算法和最新的深度神经网络

- sklearn kmeans 聚类中心_Kmeans聚类算法

weixin_39997695

sklearnkmeans聚类中心

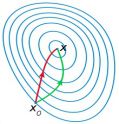

1引例经过前面一些列的介绍,我们已经接触到了多种回归和分类算法。并且这些算法有一个共同的特点,那就是它们都是有监督的(supervised)学习任务。接下来,笔者就开始向大家介绍一种无监督的(unsupervised)经典机器学习算法——聚类。同时,由于笔者仅仅只是对Kmeans框架下的聚类算法较为熟悉,因此在后续的几篇文章中笔者将只会介绍Kmeans框架下的聚类算法,包括:Kmeans、Kmea

- 机器学习算法之逻辑回归算法(Logistic Regression)

迎风斯黄

数学建模美赛机器学习算法回归

逻辑回归算法是一种用于分类问题的经典机器学习算法。虽然它的名字中带有“回归”,但实际上逻辑回归用于解决分类问题,特别是二分类问题。本篇博文将详细介绍逻辑回归算法的工作原理、应用领域以及Python示例。算法背景逻辑回归起源于20世纪初,用于分析生存率数据。随后,它被广泛应用于医学、社会科学、经济学和工程学等领域。在机器学习中,逻辑回归通常用于解决以下问题:信用评分垃圾邮件分类疾病诊断用户流失预测金

- ChatGPT4在Python数据分析、自动生成代码等方面的强大功能丨人工智能领域经典机器学习算法丨热门深度学习方法及Python、PyTorch代码实现方法

小艳加油

语言类pythonChatGPT人工智能数据分析数据可视化

帮助广大科研人员更加熟练地掌握ChatGPT4.0在数据分析、自动生成代码等方面的强大功能,同时更加系统地学习人工智能(包括传统机器学习、深度学习等)的基础理论知识,以及具体的代码实现方法,掌握ChatGPT4.0在科研工作中的各种使用方法与技巧,以及人工智能领域经典机器学习算法(BP神经网络、支持向量机、决策树、随机森林、变量降维与特征选择、群优化算法等)和热门深度学习方法(卷积神经网络、迁移学

- Python+ChatGPT,Python与ChatGPT结合进行数据分析、自动生成代码、人工智能建模、论文高效撰写等

WangYan2022

数据语言python数据分析chatgpt机器学习深度学习

熟练地掌握ChatGPT4.0在数据分析、自动生成代码等方面的强大功能,同时更加系统地学习人工智能(包括传统机器学习、深度学习等)的基础理论知识,以及具体的代码实现方法,掌握ChatGPT4.0在科研工作中的各种使用方法与技巧,以及人工智能领域经典机器学习算法(BP神经网络、支持向量机、决策树、随机森林、变量降维与特征选择、群优化算法等)和热门深度学习方法(卷积神经网络、迁移学习、RNN与LSTM

- 学习笔记:机器学习

howard2005

数据挖掘基础学习笔记机器学习

文章目录一、机器学习概述二、机器学习活跃领域(一)数据分析与数据挖掘(二)人工智能——图像和语音识别三、经典机器学习算法(一)线性回归(二)逻辑回归(三)决策树(四)随机森林(五)k-近邻(KNN)(六)支持向量机(SVM)(七)k-means四、监督学习与无监督学习(一)监督学习概念(二)无监督学习概念(三)补充学习模式1、半监督学习2、主动学习五、数据挖掘的应用(一)市场分析与管理(二)风险分

- 最新PyTorch机器学习与深度学习实践技术应用

asyxchenchong888

机器学习机器学习深度学习pytorch

近年来,随着AlphaGo、无人驾驶汽车、医学影像智慧辅助诊疗、ImageNet竞赛等热点事件的发生,人工智能迎来了新一轮的发展浪潮。尤其是深度学习技术,在许多行业都取得了颠覆性的成果。另外,近年来,Pytorch深度学习框架受到越来越多科研人员的关注和喜爱。因此,为了帮助广大科研人员更加系统地学习深度学习的基础理论知识及对应的Pytorch代码实现方法,掌握深度学习的基础知识,与经典机器学习算法

- 2018文章集合

罗罗攀

2018年公众号文章集合,过年在家系统学习下。机器学习实战该系列讲解了经典机器学习算法的原理(KNN,决策树,SVM,k-means,pca等),并从伪代码入手,一步步深入到各种算法的Python实现。机器学习实战之KNN算法机器学习实战之朴素贝叶斯机器学习实战之决策树机器学习实战之Logistic回归机器学习实战之AdaBoost元算法机器学习实战之线性回归机器学习实战之树回归机器学习实战之K-

- 【量子机器学习】量子机器学习的介绍

gezigezao

机器学习量子计算人工智能

量子机器学习:解锁未来的计算潜能随着科技的迅速进步,量子机器学习(QML)作为量子计算和机器学习的完美融合,为我们带来了前所未有的计算潜能。在这个新兴领域中,量子神经网络(QNN)是一个备受关注的算法,与传统的经典机器学习算法有着明显的不同。1.量子神经网络(QNN)与经典机器学习的对比1.1信息处理单位QNN:使用量子比特(qubit)作为信息处理的基本单元,允许信息在0和1的状态中叠加。经典机

- IBM Qiskit量子机器学习教程翻译:第三章 数据编码

溴锑锑跃迁

机器学习人工智能量子力学量子计算python量子机器学习

数据编码在这一页中,我们将介绍量子机器学习的数据编码问题,然后描述和实现各种数据编码方法。介绍数据表示对于机器学习模型的成功至关重要。对于经典机器学习来说,问题是如何用数字表示数据,以便经典机器学习算法对数据进行最好的处理。对于量子机器学习来说,这个问题是类似的,但更基本:如何将数据表示并有效地输入到量子系统中,从而可以通过量子机器学习算法进行处理。这通常称为数据编码,但也称为数据嵌入或加载。这个

- 【PyTorch】深度学习实践 1. Overview

令夏二十三

NLP学习路线深度学习人工智能

目录人工智能概述课程前置知识人工智能问题分类推理类预测类算法分类传统算法与智能算法人工智能领域细分学习系统的发展基于规则的系统经典机器学习算法表示学习方法维度诅咒说明解决方法第一代第二代(深度学习)传统机器学习策略神经网络基础基本原理正向传播和反向传播正向传播反向传播小结人工智能概述课程前置知识线性代数+概率论(不要有路径依赖,遇到不会的就现学)Python基础人工智能问题分类人工智能,实际上就是

- 准备好春招了么?上科大小哥的面试题与复习资料祝你寒假无忧

计算机与软件考研

选自Github转载于机器之心去年上海科技大学AI实验室开源了一份深度学习面试题集锦,它从数学基础、经典机器学习算法、深度学习算法以及编程语言等方面提供了众多面试题。此外,这一个项目是作者在准备2018年春招实习过程中的总结,内容以计算机书籍的学习笔记为主,在整理重点知识的同时会尽量保证知识的系统性。读者们快来试试能闯过多少道春招面试题吧!项目地址:https://github.com/Shang

- Java应用|使用Apache Spark MLlib构建机器学习模型

青年老年程序员

javaapachespark-ml

如果您觉得本博客的内容对您有所帮助或启发,请关注我的博客,以便第一时间获取最新技术文章和教程。同时,也欢迎您在评论区留言,分享想法和建议。谢谢支持!一、引言1.1SparkMLlib简介ApacheSparkMLlib(MachineLearninglibrary)是一个开源机器学习框架,建立在ApacheSpark之上,支持分布式计算和大规模数据处理。它提供了许多经典机器学习算法和工具,如分类、

- 传统机器学习

aaa小菜鸡

2019-06-23PCA主成分分析法PrincipleComponentsAnalysis逻辑清晰,入门理解一下:深入了解一下十大经典机器学习算法之一:PCA算法简单实例理解一下:PCA降维实例分析是一种降维手段,在保留数据绝大多数信息的情况下。第一个轴是方差最大的,第二个轴是与第一个轴正交且方差最大的轴,第三个轴是与前两个轴正交且方差最大的轴。AdaBoost看里面的例子回忆了一下:AdaBo

- 机器学习十大经典算法

智慧医疗探索者

经典机器学习算法机器学习算法人工智能

机器学习算法是计算机科学和人工智能领域的关键组成部分,它们用于从数据中学习模式并作出预测或做出决策。本文将为大家介绍十大经典机器学习算法,其中包括了线性回归、逻辑回归、支持向量机、朴素贝叶斯、决策树等算法,每种算法都在特定的领域发挥着巨大的价值。1线性回归线性回归算得上是最流行的机器学习算法之一,它是利用数理统计中回归分析,来确定两种或两种以上变量间相互依赖的定量关系的一种统计分析方法,目前线性回

- 经典机器学习算法的极简实现(Python+NumPy)

木亦有知

大三的时候曾花两个星期学习了几个经典的机器学习算法,学习方法主要是白天参考《统计学习方法》推导公式,晚上利用公式编写实现。在参考GitHub上算法实现时,我发现其中大多数都比较繁杂冗长,很难体现出算法的核心思想。因此我特地找出了以前的机器学习算法实现,在修改整理后分享给大家(GitHub地址)。所有算法的实现都没有使用其他机器学习库。希望可以帮助大家对机器学习算法及其本质原理有个基本的了解,但并不

- 制定机器学习规划路线:从入门到专业

小馒头学python

机器学习机器学习人工智能

文章目录第一阶段:入门基础了解机器学习概念学习编程和数学基础探索经典机器学习算法完成实践项目第二阶段:深入学习掌握深度学习基础学习深度学习框架探索最新研究进展完成高级项目第三阶段:专业实践深入研究特定领域参与开源项目或竞赛深度优化和调优关注伦理问题和社会影响结论第一阶段:入门基础了解机器学习概念首先,对机器学习的基本概念进行学习。了解监督学习、无监督学习、强化学习等的原理和应用领域。学习编程和数学

- 经典机器学习算法之GBDT算法

今天上上签

小白的经典机器学习算法机器学习算法决策树

本篇文章旨在让完全不懂的小伙伴对该算法有一个初步认识与理解,只适用于小白文章目录1.基本概念和基本原理2.形式描述基本形式描述目标函数描述优化求解描述3.构造GBDT1.基本概念和基本原理GBDT(GradientBoostingDecisionTrees,梯度提升决策树)是一种迭代的决策树算法,由多棵决策树组成,所有树的结论累加起来作为最终答案,我们根据其名字来展开推导过程是一种集成学习方法,通

- 《机器学习算法的数学解析与Python实现》读书笔记:第11章 集成学习方法

非文的NLP修炼笔记

#机器学习集成学习python

目录第11章集成学习方法11.1集成学习方法:三个臭皮匠赛过诸葛亮11.1.1集成学习方法与经典机器学习算法的关系11.1.2集成学习的主要思想11.1.3几种集成结构11.2集成学习方法的具体实现方式11.2.1Bagging算法11.2.2Boosting算法11.2.3Stacking算法11.3在Python中使用集成学习方法11.4集成学习方法的使用场景第11章集成学习方法在学习的时候,

- 一文全解经典机器学习算法之支持向量机SVM(关键词:SVM,对偶、间隔、支持向量、核函数、特征空间、分类)

快乐江湖

机器学习支持向量机算法

文章目录一:概述二:间隔与支持向量三:对偶问题(1)什么是对偶问题(2)SVM对偶问题(3)SMO算法四:核函数(1)核函数的概述和作用(2)求解之前所介绍的逻辑回归是基于似然度的分类方法,通过对数据概率进行建模来得到软输出。但这种分类方法其实稍加“繁琐”,因为要估计数据的概率分布作为中间步骤。这就像当一个人学习英语时,他只要直接报个班或者自己看书就行了,而不需要先学习诘屈聱牙的拉丁语作为基础。既

- 2-5.2 经典机器学习算法-SVM算法优缺点、超参数调节、核函数选择、软硬间隔的推导过程

沉睡的小卡比兽

AI基础知识支持向量机SVMSVM硬间隔SVM软间隔核函数

1、SVM算法的优缺点2、SVM的超参数C如何调节3、SVM核函数如何选择4、简述SVM硬间隔推导过程5、简述SVM软间隔推导过程1、SVM算法的优缺点优点:(1)可以解决高维特征的分类和回归问题(2)模型最终结果无需依赖全体样本,只需依赖支持向量(3)有已经研究好的核技巧可以使用,可以应对线性不可分的问题(4)样本量中等偏小的情况也有较好的效果,有一点泛化能力和鲁棒性。这也是深度学习热门起来之前

- PyTorch机器学习与深度学习技术方法与案例

xiao5kou4chang6kai4

生态遥感水文深度学习机器学习pytorch

近年来,随着AlphaGo、无人驾驶汽车、医学影像智慧辅助诊疗、ImageNet竞赛等热点事件的发生,人工智能迎来了新一轮的发展浪潮。尤其是深度学习技术,在许多行业都取得了颠覆性的成果。另外,近年来,Pytorch深度学习框架受到越来越多科研人员的关注和喜爱旨在帮助广大科研人员更加系统地学习深度学习的基础理论知识及对应的Pytorch代码实现方法帮助您掌握深度学习的基础知识,与经典机器学习算法的区

- 【代码实现】最新PyTorch机器学习与深度学习技术方法

weixin_贾楠

python深度学习MATLAB编程PythonMATLAB经验分享python深度学习机器学习c语言

近年来,随着AlphaGo、无人驾驶汽车、医学影像智慧辅助诊疗、ImageNet竞赛等热点事件的发生,人工智能迎来了新一轮的发展浪潮。尤其是深度学习技术,在许多行业都取得了颠覆性的成果。另外,近年来,Pytorch深度学习框架受到越来越多科研人员的关注和喜爱。本次内容在掌握深度学习的基础知识,与经典机器学习算法的区别与联系,以及最新的迁移学习、循环神经网络、长短时记忆神经网络、时间卷积网络、对抗生

- Python实现逻辑回归(Logistic Regression)

海洋.之心

机器学习经典算法实现python逻辑回归机器学习人工智能sklearn

项目专栏:【Python实现经典机器学习算法】附代码+原理介绍文章目录前言一、基于原生Python实现逻辑回归算法二、逻辑回归模型的算法原理三、算法实现3.1导包3.2定义随机数种子3.3定义逻辑回归模型3.3.1模型训练3.3.1.1初始化参数3.3.1.2正向传播3.3.1.3损失函数3.3.1.4反向传播3.3.2模型预测3.3.3模型分数3.3.4LogisticRegression模型3

- Python实现朴素贝叶斯(Naive Bayes)

海洋.之心

机器学习经典算法实现python机器学习开发语言人工智能sklearn

项目专栏:【Python实现经典机器学习算法】附代码+原理介绍文章目录前言一、基于原生Python实现朴素贝叶斯(NaiveBayes)二、常见概念介绍三、朴素贝叶斯的算法原理四、算法实现4.1导包4.2定义随机数种子4.3定义朴素贝叶斯模型4.3.1模型训练4.3.2模型预测4.3.3模型分数4.3.4NaiveBayes模型4.4导入数据4.5划分训练集、测试集4.6模型训练4.7打印结果4.

- 手推公式+项目实操复现!《机器学习》完整详解

zenRRan

算法人工智能编程语言数据分析大数据

相信很多朋友对机器学习算法都有所了解,有尝试学习并利用机器学习算法以及工具做一些AI产品!但是仅仅停留在“调包”的阶段。想去深入理解一些算法的核心内涵却被XGBoost|GBDT等算法劝退了!为了满足全民学习AI的需求,给大家推荐一款轻松入门机器学习算法课程,涵盖17大经典机器学习算法模型,21+案例练习,8大项目实战。今日开课,限100个体验名额01十七大经典算法模型|K-NN最近邻|线性回归|

- Python机器学习:多个模型的调用

紫昂张

Python机器学习pythonsklearn

在做项目的过程中一个个模型地试验太耗费时间,我们可以把多个模型封装到一个方法里,一起调用,统一输出结果,这样对比不同模型的得分就非常便捷啦。基础的分类算法大全(前8个是十大经典机器学习算法里面的):英文简称模型调用LRLogisticRegression()fromsklearn.linear_modelimportLogisticRegressionNBMultinomialNB()fromsk

- 图解十大经典机器学习算法

欣一2002

算法决策树大数据python机器学习

本文利用图解的方式介绍了10大常见的机器学习算法。在机器学习领域,有种说法叫做“世上没有免费的午餐”,简而言之,它是指没有任何一种算法能在每个问题上都能有最好的效果,这个理论在监督学习方面体现得尤为重要。举个例子来说,你不能说神经网络永远比决策树好,反之亦然。模型运行被许多因素左右,例如数据集的大小和结构。因此,你应该根据你的问题尝试许多不同的算法,同时使用数据测试集来评估性能并选出最优项。当然,

- 【综述】机器学习中的12类算法

IT农民工1

算法聚类机器学习人工智能深度学习

公众号后台回复“图书“,了解更多号主新书内容 作者:luanhz 来源:小数志导读最近在研究一些机器学习方面的论文,翻到了一篇较早的机器学习综述(2017年),虽然不是最新的研究现状,但考虑到经典机器学习算法其实发展并不像深度学习那么迅猛,所以其论述还是很有参考性。本文就其中关于机器学习算法分类的一段进行选摘翻译,以供参考。原文链接可通过阅读原文查阅。以下译文选摘自2017年发表在IJIR

- 支持向量机算法模型

帅帅de三叔

机器学习python

目录前言从数据的线性可分到间隔最大化对偶算法线性支持向量机与非线性支持向量机实践案例前言从这一期开始,我们准备介绍一系列经典机器学习算法模型,主要包括逻辑回归,支持向量机,决策树,因子分析,主成分分析,K-Means聚类,多元线性回归,时间序列,关联规则,朴素贝叶斯,隐式马尔可夫,协同过滤,随机森林,XGBoost,LightGBM等,一般会涵盖算法模型的引入背景,算法模型依赖的数学原理,算法模型

- mysql主从数据同步

林鹤霄

mysql主从数据同步

配置mysql5.5主从服务器(转)

教程开始:一、安装MySQL

说明:在两台MySQL服务器192.168.21.169和192.168.21.168上分别进行如下操作,安装MySQL 5.5.22

二、配置MySQL主服务器(192.168.21.169)mysql -uroot -p &nb

- oracle学习笔记

caoyong

oracle

1、ORACLE的安装

a>、ORACLE的版本

8i,9i : i是internet

10g,11g : grid (网格)

12c : cloud (云计算)

b>、10g不支持win7

&

- 数据库,SQL零基础入门

天子之骄

sql数据库入门基本术语

数据库,SQL零基础入门

做网站肯定离不开数据库,本人之前没怎么具体接触SQL,这几天起早贪黑得各种入门,恶补脑洞。一些具体的知识点,可以让小白不再迷茫的术语,拿来与大家分享。

数据库,永久数据的一个或多个大型结构化集合,通常与更新和查询数据的软件相关

- pom.xml

一炮送你回车库

pom.xml

1、一级元素dependencies是可以被子项目继承的

2、一级元素dependencyManagement是定义该项目群里jar包版本号的,通常和一级元素properties一起使用,既然有继承,也肯定有一级元素modules来定义子元素

3、父项目里的一级元素<modules>

<module>lcas-admin-war</module>

<

- sql查地区省市县

3213213333332132

sqlmysql

-- db_yhm_city

SELECT * FROM db_yhm_city WHERE class_parent_id = 1 -- 海南 class_id = 9 港、奥、台 class_id = 33、34、35

SELECT * FROM db_yhm_city WHERE class_parent_id =169

SELECT d1.cla

- 关于监听器那些让人头疼的事

宝剑锋梅花香

画图板监听器鼠标监听器

本人初学JAVA,对于界面开发我只能说有点蛋疼,用JAVA来做界面的话确实需要一定的耐心(不使用插件,就算使用插件的话也没好多少)既然Java提供了界面开发,老师又要求做,只能硬着头皮上啦。但是监听器还真是个难懂的地方,我是上了几次课才略微搞懂了些。

- JAVA的遍历MAP

darkranger

map

Java Map遍历方式的选择

1. 阐述

对于Java中Map的遍历方式,很多文章都推荐使用entrySet,认为其比keySet的效率高很多。理由是:entrySet方法一次拿到所有key和value的集合;而keySet拿到的只是key的集合,针对每个key,都要去Map中额外查找一次value,从而降低了总体效率。那么实际情况如何呢?

为了解遍历性能的真实差距,包括在遍历ke

- POJ 2312 Battle City 优先多列+bfs

aijuans

搜索

来源:http://poj.org/problem?id=2312

题意:题目背景就是小时候玩的坦克大战,求从起点到终点最少需要多少步。已知S和R是不能走得,E是空的,可以走,B是砖,只有打掉后才可以通过。

思路:很容易看出来这是一道广搜的题目,但是因为走E和走B所需要的时间不一样,因此不能用普通的队列存点。因为对于走B来说,要先打掉砖才能通过,所以我们可以理解为走B需要两步,而走E是指需要1

- Hibernate与Jpa的关系,终于弄懂

avords

javaHibernate数据库jpa

我知道Jpa是一种规范,而Hibernate是它的一种实现。除了Hibernate,还有EclipseLink(曾经的toplink),OpenJPA等可供选择,所以使用Jpa的一个好处是,可以更换实现而不必改动太多代码。

在play中定义Model时,使用的是jpa的annotations,比如javax.persistence.Entity, Table, Column, OneToMany

- 酸爽的console.log

bee1314

console

在前端的开发中,console.log那是开发必备啊,简直直观。通过写小函数,组合大功能。更容易测试。但是在打版本时,就要删除console.log,打完版本进入开发状态又要添加,真不够爽。重复劳动太多。所以可以做些简单地封装,方便开发和上线。

/**

* log.js hufeng

* The safe wrapper for `console.xxx` functions

*

- 哈佛教授:穷人和过于忙碌的人有一个共同思维特质

bijian1013

时间管理励志人生穷人过于忙碌

一个跨学科团队今年完成了一项对资源稀缺状况下人的思维方式的研究,结论是:穷人和过于忙碌的人有一个共同思维特质,即注意力被稀缺资源过分占据,引起认知和判断力的全面下降。这项研究是心理学、行为经济学和政策研究学者协作的典范。

这个研究源于穆来纳森对自己拖延症的憎恨。他7岁从印度移民美国,很快就如鱼得水,哈佛毕业

- other operate

征客丶

OSosx

一、Mac Finder 设置排序方式,预览栏 在显示-》查看显示选项中

二、有时预览显示时,卡死在那,有可能是一些临时文件夹被删除了,如:/private/tmp[有待验证]

--------------------------------------------------------------------

若有其他凝问或文中有错误,请及时向我指出,

我好及时改正,同时也让我们一

- 【Scala五】分析Spark源代码总结的Scala语法三

bit1129

scala

1. If语句作为表达式

val properties = if (jobIdToActiveJob.contains(jobId)) {

jobIdToActiveJob(stage.jobId).properties

} else {

// this stage will be assigned to "default" po

- ZooKeeper 入门

BlueSkator

中间件zk

ZooKeeper是一个高可用的分布式数据管理与系统协调框架。基于对Paxos算法的实现,使该框架保证了分布式环境中数据的强一致性,也正是基于这样的特性,使得ZooKeeper解决很多分布式问题。网上对ZK的应用场景也有不少介绍,本文将结合作者身边的项目例子,系统地对ZK的应用场景进行一个分门归类的介绍。

值得注意的是,ZK并非天生就是为这些应用场景设计的,都是后来众多开发者根据其框架的特性,利

- MySQL取得当前时间的函数是什么 格式化日期的函数是什么

BreakingBad

mysqlDate

取得当前时间用 now() 就行。

在数据库中格式化时间 用DATE_FORMA T(date, format) .

根据格式串format 格式化日期或日期和时间值date,返回结果串。

可用DATE_FORMAT( ) 来格式化DATE 或DATETIME 值,以便得到所希望的格式。根据format字符串格式化date值:

%S, %s 两位数字形式的秒( 00,01,

- 读《研磨设计模式》-代码笔记-组合模式

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

import java.util.ArrayList;

import java.util.List;

abstract class Component {

public abstract void printStruct(Str

- 4_JAVA+Oracle面试题(有答案)

chenke

oracle

基础测试题

卷面上不能出现任何的涂写文字,所有的答案要求写在答题纸上,考卷不得带走。

选择题

1、 What will happen when you attempt to compile and run the following code? (3)

public class Static {

static {

int x = 5; // 在static内有效

}

st

- 新一代工作流系统设计目标

comsci

工作算法脚本

用户只需要给工作流系统制定若干个需求,流程系统根据需求,并结合事先输入的组织机构和权限结构,调用若干算法,在流程展示版面上面显示出系统自动生成的流程图,然后由用户根据实际情况对该流程图进行微调,直到满意为止,流程在运行过程中,系统和用户可以根据情况对流程进行实时的调整,包括拓扑结构的调整,权限的调整,内置脚本的调整。。。。。

在这个设计中,最难的地方是系统根据什么来生成流

- oracle 行链接与行迁移

daizj

oracle行迁移

表里的一行对于一个数据块太大的情况有二种(一行在一个数据块里放不下)

第一种情况:

INSERT的时候,INSERT时候行的大小就超一个块的大小。Oracle把这行的数据存储在一连串的数据块里(Oracle Stores the data for the row in a chain of data blocks),这种情况称为行链接(Row Chain),一般不可避免(除非使用更大的数据

- [JShop]开源电子商务系统jshop的系统缓存实现

dinguangx

jshop电子商务

前言

jeeshop中通过SystemManager管理了大量的缓存数据,来提升系统的性能,但这些缓存数据全部都是存放于内存中的,无法满足特定场景的数据更新(如集群环境)。JShop对jeeshop的缓存机制进行了扩展,提供CacheProvider来辅助SystemManager管理这些缓存数据,通过CacheProvider,可以把缓存存放在内存,ehcache,redis,memcache

- 初三全学年难记忆单词

dcj3sjt126com

englishword

several 儿子;若干

shelf 架子

knowledge 知识;学问

librarian 图书管理员

abroad 到国外,在国外

surf 冲浪

wave 浪;波浪

twice 两次;两倍

describe 描写;叙述

especially 特别;尤其

attract 吸引

prize 奖品;奖赏

competition 比赛;竞争

event 大事;事件

O

- sphinx实践

dcj3sjt126com

sphinx

安装参考地址:http://briansnelson.com/How_to_install_Sphinx_on_Centos_Server

yum install sphinx

如果失败的话使用下面的方式安装

wget http://sphinxsearch.com/files/sphinx-2.2.9-1.rhel6.x86_64.rpm

yum loca

- JPA之JPQL(三)

frank1234

ormjpaJPQL

1 什么是JPQL

JPQL是Java Persistence Query Language的简称,可以看成是JPA中的HQL, JPQL支持各种复杂查询。

2 检索单个对象

@Test

public void querySingleObject1() {

Query query = em.createQuery("sele

- Remove Duplicates from Sorted Array II

hcx2013

remove

Follow up for "Remove Duplicates":What if duplicates are allowed at most twice?

For example,Given sorted array nums = [1,1,1,2,2,3],

Your function should return length

- Spring4新特性——Groovy Bean定义DSL

jinnianshilongnian

spring 4

Spring4新特性——泛型限定式依赖注入

Spring4新特性——核心容器的其他改进

Spring4新特性——Web开发的增强

Spring4新特性——集成Bean Validation 1.1(JSR-349)到SpringMVC

Spring4新特性——Groovy Bean定义DSL

Spring4新特性——更好的Java泛型操作API

Spring4新

- CentOS安装Mysql5.5

liuxingguome

centos

CentOS下以RPM方式安装MySQL5.5

首先卸载系统自带Mysql:

yum remove mysql mysql-server mysql-libs compat-mysql51

rm -rf /var/lib/mysql

rm /etc/my.cnf

查看是否还有mysql软件:

rpm -qa|grep mysql

去http://dev.mysql.c

- 第14章 工具函数(下)

onestopweb

函数

index.html

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DTD/xhtml1-transitional.dtd">

<html xmlns="http://www.w3.org/

- POJ 1050

SaraWon

二维数组子矩阵最大和

POJ ACM第1050题的详细描述,请参照

http://acm.pku.edu.cn/JudgeOnline/problem?id=1050

题目意思:

给定包含有正负整型的二维数组,找出所有子矩阵的和的最大值。

如二维数组

0 -2 -7 0

9 2 -6 2

-4 1 -4 1

-1 8 0 -2

中和最大的子矩阵是

9 2

-4 1

-1 8

且最大和是15

- [5]设计模式——单例模式

tsface

java单例设计模式虚拟机

单例模式:保证一个类仅有一个实例,并提供一个访问它的全局访问点

安全的单例模式:

/*

* @(#)Singleton.java 2014-8-1

*

* Copyright 2014 XXXX, Inc. All rights reserved.

*/

package com.fiberhome.singleton;

- Java8全新打造,英语学习supertool

yangshangchuan

javasuperword闭包java8函数式编程

superword是一个Java实现的英文单词分析软件,主要研究英语单词音近形似转化规律、前缀后缀规律、词之间的相似性规律等等。Clean code、Fluent style、Java8 feature: Lambdas, Streams and Functional-style Programming。

升学考试、工作求职、充电提高,都少不了英语的身影,英语对我们来说实在太重要