Subgradient

1、次梯度定义:

2、次梯度是一个集合。

经常用在凸优化问题中,我们经常想要求一个函数对某个变量的梯度,但如果这个函数是不可微分的呢。就可以采用次梯度方法

一个函数的次梯度是一个集合[a,b],a表示导数的左极限,b表示导数的右极限,就是这么一个区间的集合。

如果函数可微,那么次梯度集合里面只有一个元素,就是梯度本身。

g2和g3都是属于函数在点x2上的次梯度

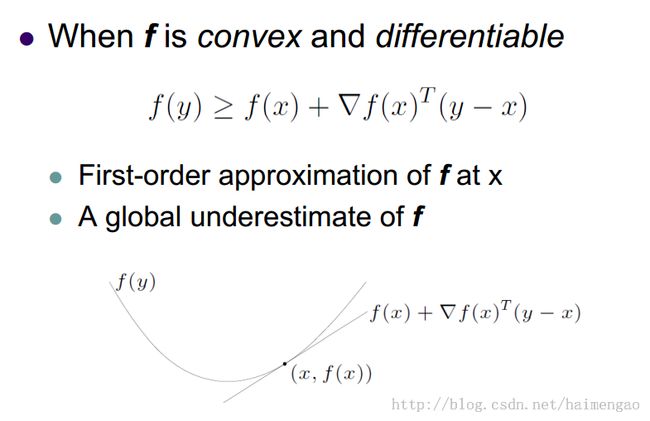

3、凸函数可微的情况:导数是直线的斜率,凸函数,那么符合则为大于号。

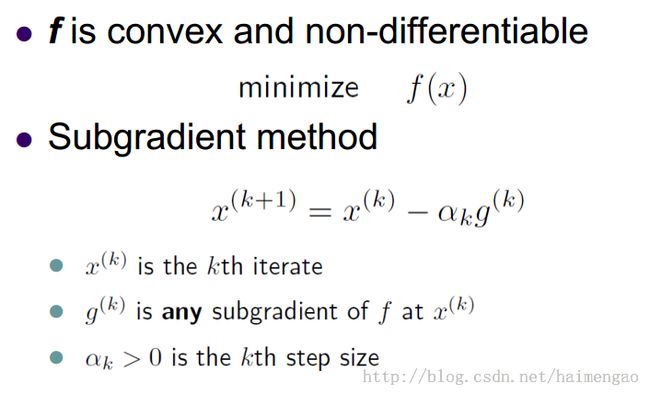

4、次梯度基本算法:

注意any...................g只是选取次梯度集合中的某一个元素,可以是任意一个。

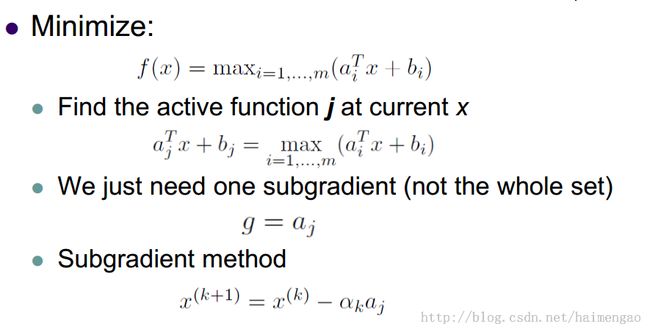

5、例子1:

先找到符合条件的函数,确定j,那么g也就随之确定了。次梯度有很多值,但是我们迭代的时候只需要其中的一个值。

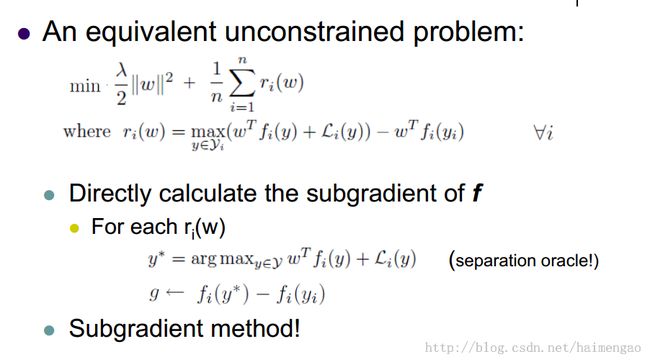

6、例子2:

在之前的paper里面:(Online) Subgradient Methods for Structured Prediction

在这里,![]() 表示的是未满足条件的y的最大值,

表示的是未满足条件的y的最大值,![]() 表示的是符合条件的最大值,例如在paper:learning continuous phrase representations and syntactic parsing with recursive neural networks里面,那么符合条件的即是正确的parse trees。

表示的是符合条件的最大值,例如在paper:learning continuous phrase representations and syntactic parsing with recursive neural networks里面,那么符合条件的即是正确的parse trees。

参考文献:select.cs.cmu.edu/class/10725-S10/recitations/r7/Subgradients.pdf