ROS理论与实践(以移动机器人为例)连载(七) ——机器人语音交互

文章目录

- 1. 科大讯飞开放平台使用简介

- ①如何使用科大讯飞开放平台

- ②对SDK中提供的源码进行简要分析

- 2. ROS语音识别与语音输出

- ①语音识别

- - 具体实现

- ②语音输出

- - 具体实现

- ③语音识别和语音合成的匹配

- 3. ROS机器人语音交互

1. 科大讯飞开放平台使用简介

①如何使用科大讯飞开放平台

- 登录/注册 科大讯飞开放平台;

- 打开控制台创建新应用;

- 语音听写和语音合成SDK下载;

- 包含五个文件夹:

- bin: 最后生成的可执行文件

- doc: API的使用文档和说明手册

- include: 头文件

- libs: 语音识别相关的链接库文件

- samples: 例程

- iat_online_record_sample:语音听写的例程包

- tts_online_sample:语音输出,将某个字符串通过语音生成

- 编译iat_online_record_sample

linuxrec.c:12:28: fatal error: alsa/asoundlib.h: No such file or directory

则执行

sudo apt-get install libasound2-dev

- 执行bin文件夹目录下的可执行文件; 选择不提供使用者词库,麦克风输入音频;

- 编译tts_online_sample并执行可执行文件; 会生成一个Wav文件,里面是对科大讯飞的介绍;

②对SDK中提供的源码进行简要分析

我们可以打开iat_online_record_sample文件夹下的iat_online_record_sample.c文件(由于文件300多行这里就不粘贴了),熟悉一下里面核心的API。

大体上main函数里包括这些:

- 对appid的配置;

- 登录用户名;

- 上传用户的words列表;

- 选择语音从哪里来;

- demo_mic函数具体实现识别功能。

demo_mic:

static void demo_mic(const char* session_begin_params)

{

int errcode;

int i = 0;

struct speech_rec iat;

struct speech_rec_notifier recnotifier = {

on_result,

on_speech_begin,

on_speech_end

};

errcode = sr_init(&iat, session_begin_params, SR_MIC, &recnotifier);

if (errcode) {

printf("speech recognizer init failed\n");

return;

}

errcode = sr_start_listening(&iat);

if (errcode) {

printf("start listen failed %d\n", errcode);

}

/* demo 15 seconds recording */

while(i++ < 15)

sleep(1);

errcode = sr_stop_listening(&iat);

if (errcode) {

printf("stop listening failed %d\n", errcode);

}

sr_uninit(&iat);

}

我们需要关注里面的 on_result 的结果是如何发布的:

void on_result(const char *result, char is_last)

{

if (result) {

size_t left = g_buffersize - 1 - strlen(g_result);

size_t size = strlen(result);

if (left < size) {

g_result = (char*)realloc(g_result, g_buffersize + BUFFER_SIZE);

if (g_result)

g_buffersize += BUFFER_SIZE;

else {

printf("mem alloc failed\n");

return;

}

}

strncat(g_result, result, size);

show_result(g_result, is_last);

}

}

从代码中我们猜想只要拿到这里的 g_result 这个全局变量就可以拿到最终的识别结果。

再来看一看tts_online_sample.c中的代码,text_to_speech是语音合成关键的函数:

const char* filename = "tts_sample.wav"; //合成的语音文件名称

const char* text = "亲爱的用户,您好,这是一个语音合成示例,感谢您对科大讯飞语音技术的支持!科大讯飞是亚太地区最大的语音上市公司,股票代码:002230"; //合成文本

ret = text_to_speech(text, filename, session_begin_params);

通过这些代码结合用户登录和函数text_to_speech等,将text内的文字转换成了语音保存到了filename的文件中。

当然,我们可以修改代码,将语音直接输出出来。在文件末173行左右:

printf("合成完毕\n");

popen("play tts_sample.wav","r");

//就是这句话很关键,但是需要提前确认Linux系统可以使用play

所以我们安装play相关的工具:(第一句话因SDK包名而异)

$ cd cd Linux_iat1227_tts_online1227_5e9199eb/libs/x64

$ sudo cp libmsc.so /usr/lib/

$ sudo apt install sox

$ sudo apt install libsox-fmt-all

科大讯飞的SDK带有ID号,每个人每次下载后的ID都不相同,更换SDK之后需要修改代码中的APPID。APPID可以在SDK包的名字后几位可以看到。

2. ROS语音识别与语音输出

①语音识别

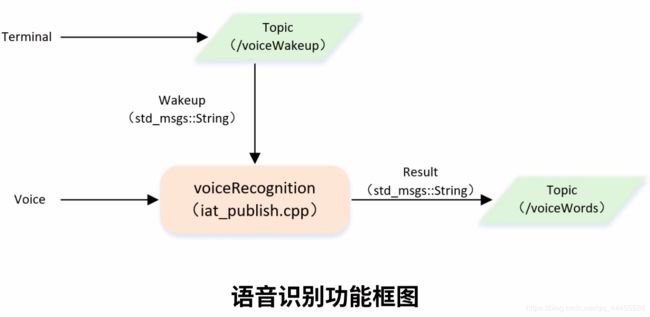

通过修改上面提供的SDK源码文件,改成可以在ROS环境下使用的功能包,达成语音识别的目的。这个功能框图,描述了我们将通过一个唤醒词,就像“Hi Siri”一样,这里通过一个std_msgs::String的话题消息唤醒语音识别的功能,而不是执行一次./iat_online_record_sample识别一次;随后通过Result将识别后的文字包装成话题发布出去,可供其他操作者调用。

- 具体实现

- subscriber:接收唤醒信号,将wakeupFlag变量置位;

- publisher:主循环中调用SDK的语音识别功能,识别成功后置位resultFlag变量,将识别出来的字符串发布。

步骤:

- 创建功能包;

- 将SDK内的头文件复制粘贴在新创建的功能包内,包括include文件夹内的和samples/iat_online_record_sample文件夹下的.h文件;

- 将samples/iat_online_record_sample文件夹下的iat_online_record_sample.c,linuxrec.c和speech_recognizer.c文件放入新建功能包的src文件夹目录下,并把iat_online_record_sample.c文件扩展名改为cpp,因为我们将用到C++的语法;并创建launch文件夹;

- 修改iat_online_record_sample.cpp文件,这里我们可以发现ROS可以通过其他不同平台的已经实现功能的代码,经过修改达成ROS机器人使用的目的。

这里我把iat_publish.cpp全部代码都粘贴到了页面上,大家可以对比下载下来的SDK中iat_online_record_sample.c文件。多数代码都是讯飞提供的SDK的内容,我会解读其中修改的重要的部分:(解读的部分都由注释放置到对应的位置)

/*

* 语音听写(iFly Auto Transform)技术能够实时地将语音转换成对应的文字。

*/

#include 好了,那我们现在开始配置编译文件CMakeLists.txt。我们需要开启c++11和头文件包含

add_definitions(-std=c++11)

include_directories(

${catkin_INCLUDE_DIRS}

include

)

并对三个c/c++文件添加可执行文件和链接库依赖

add_executable(iat_publish

src/iat_publish.cpp

src/speech_recognizer.c

src/linuxrec.c)

target_link_libraries(

iat_publish

${catkin_LIBRARIES}

libmsc.so -ldl -lpthread -lm - lrt -lasound

)

这里需要注意需要把speech_recognizer.c和linuxrec.c中的包含的头文件(在robot_voice/include/robot_voice目录下的那几个),修改为include “robot_voice/{文件名}”。

②语音输出

- 具体实现

- subscriber: 订阅voiceWords话题,接收输入的字符串;

- voiceWordsCallback: 使用SDK接口将字符串转换成中文语音。

步骤:

- 将tts_online_sample.c文件复制粘贴到/robot_voice/src目录下,改名为tts_publish.cpp;

- 修改该文件。头文件我们都是已经放置好了。

文件我也全部粘贴到了这里,同样和SDK中的原文件进行比对。重要的部分同样在代码中指定位置注释:(和上个例子相似的地方就不做解释了)

/*

* 语音合成(Text To Speech,TTS)技术能够自动将任意文字实时转换为连续的

* 自然语音,是一种能够在任何时间、任何地点,向任何人提供语音信息服务的

* 高效便捷手段,非常符合信息时代海量数据、动态更新和个性化查询的需求。

*/

#include 代码无法直接使用的原因是APPIP没有修改,按照上面提示的APPIP的修改方式改一下就好了。

需要对该文件进行编译,编译文件这样改:

add_executable(tts_subscribe src/tts_subscribe.cpp)

target_link_libraries(

tts_subscribe

${catkin_LIBRARIES}

libmsc.so -ldl -pthread

)

emmm…效果图都是语音就没法发GIF了。

③语音识别和语音合成的匹配

即我说一句,机器人说一句。

由于我们上述的两段代码都是使用的统一话题名,即voiceWords,有语音识别发布,语音合成订阅,所以我们可以写一个launch文件将两个功能都包含进去。

<launch>

<node name="iat_publish" pkg="robot_voice" type="iat_publish" output="screen"/>

<node name="tts_subscribe" pkg="robot_voice" type="tts_subscribe" output="screen"/>

launch>

还是可以发个哑巴图哈~大概能看出来

3. ROS机器人语音交互

这里的VoiceAssistant会识别你说出的关键词,输出匹配用户询问的回复。我们同样还使用的tts_online_sample.c文件更名为voice_assistant.cpp并对内容进行修改。

这里我们主要更改的是回调函数中的内容,其他内容和语音合成部分的示例代码相同。

更改部分:

std::string to_string(int val)

{

char buf[20];

sprintf(buf, "%d", val); //格式化输出字符,将输出的字符存入buf中

return std::string(buf);

}

void voiceWordsCallback(const std_msgs::String::ConstPtr& msg)

{

char cmd[2000];

const char* text;

int ret = MSP_SUCCESS;

const char* session_begin_params = "voice_name = xiaoyan, text_encoding = utf8, sample_rate = 16000, speed = 50, volume = 50, pitch = 50, rdn = 2";

const char* filename = "tts_sample.wav"; //合成的语音文件名称

std::cout<<"I heard :"<<msg->data.c_str()<<std::endl;

std::string dataString = msg->data;

if(dataString.find("你是谁") != std::string::npos

|| dataString.find("名字") != std::string::npos)

{

char nameString[100] = "我是你的语音小助手,你可以叫我小R";

text = nameString;

std::cout<<text<<std::endl;

}

else if(dataString.find("你几岁了") != std::string::npos

|| dataString.find("年龄") != std::string::npos)

{

char eageString[100] = "我已经四岁了,不再是两三岁的小孩子了";

text = eageString;

std::cout<<text<<std::endl;

}

else if(dataString.find("你可以做什么") != std::string::npos

|| dataString.find("干什么") != std::string::npos)

{

char helpString[100] = "你可以问我现在时间";

text = helpString;

std::cout<<text<<std::endl;

}

else if(dataString.find("时间") != std::string::npos)

{

//获取当前时间

struct tm *ptm;

long ts;

ts = time(NULL);

ptm = localtime(&ts);

std::string string = "现在时间" + to_string(ptm-> tm_hour) + "点" + to_string(ptm-> tm_min) + "分";

char timeString[40] = {0};

string.copy(timeString, sizeof(string), 0);

text = timeString;

std::cout<<text<<std::endl;

}

else

{

text = msg->data.c_str();

}

/* 文本合成 */

printf("开始合成 ...\n");

ret = text_to_speech(text, filename, session_begin_params);

if (MSP_SUCCESS != ret)

{

printf("text_to_speech failed, error code: %d.\n", ret);

}

printf("合成完毕\n");

popen("play tts_sample.wav","r");

sleep(1);

}

这里使用了string::find()函数: 是一个字符或字符串查找函数,该函数有唯一的返回类型,即string::size_type,即一个无符号整形类型,可能是整数也可能是长整数。如果查找成功,返回按照查找规则找到的第一个字符或者子串的位置;如果查找失败,返回string::npos,即-1(当然打印出的结果不是-1,而是一个很大的数值,那是因为它是无符号的)。

然后我们再补充一个launch文件,启动了语音识别和语音助手:

<launch>

<node name="iat_publish" pkg="robot_voice" type="iat_publish" output="screen"/>

<node name="voice_assistant" pkg="robot_voice" type="voice_assistant" output="screen"/>

launch>

切记!使用是需要发布唤醒词,唤醒语音识别!就是在语音识别里subscribe的voiceWakeup这个话题。

其实基于这些就可以和机器人做很多交互了,比如用户说一个指令,机器人做运动,并且还可以回复命令者等等。