前言

Alluxio官方文档介绍了Hive的配置方法,也介绍了Spark的配置方法,重点介绍了Spark程序如何访问Alluxio上的文件,但是没有介绍如何配置SparkSQL(这里指纯SQL方式,不是DataFrame编程),笔者仿照Hive的方式配置SparkSQL,但数据始终无法落到内存上(load、insert都不行)。

本文重点介绍如何为SparkSQL配置Alluxio,为SparkSQL插上飞翔的翅膀。

本文的环境:

Hadoop-2.7.1

Hive-1.2

Spark-2.1.1(刚刚发布的2.2对SparkSQL又做了大量优化(如CBO等)

Alluxio-1.4

启动Alluxio的用户

Alluxio默认支持文件系统用户和权限检查。为了确保HDFS中包括用户,组和模式的文件/目录的权限信息与Alluxio一致,启动Alluxio master和worker进程的用户要求是以下任一情况:

- HDFS超级用户。即,使用启动HDFS namenode进程的同一用户也启动Alluxio master和worker进程。

- HDFS超级用户组的成员。编辑HDFS配置文件hdfs-site.xml并检查配置属性dfs.permissions.superusergroup的值。如果使用组(例如,“hdfs”)设置此属性,则将用户添加到此组(“hdfs”)以启动Alluxio进程(例如,“alluxio”);如果未设置此属性,请将一个组添加到此属性,其中Alluxio运行用户是此新添加组的成员。

注意,上面设置的用户只是用于启动Alluxio master和worker进程。一旦Alluxio服务器启动,就不必使用此用户运行Alluxio客户端应用程序。

如果Hadoop的超级用户是hdfs,而启动Alluxio的用户是root,那么你会遇到各种权限相关的异常。

解决方法:将现在启动alluxio进程root用户加入hdfs用户组中。

usermod -a -G hdfs root(注意记得加-a,否则root会从原来的组移除)

从Hive开始

Hive在Hadoop&Spark生态中已经是不成文的事实标准,大部分主流的SQL on Hadoop引擎都会或多或少的依赖Hive或可与Hive共享存储仓库和元数据库,如SparkSQL、Impala、Presto、HAWQ、Drill等等。

配置Hadoop

配置Hive之前需要配置Hadoop(前提是Hive的执行引擎是MR)

将以下三个属性添加到Hadoop的安装目录下的conf目录中的core-site.xml文件中:

fs.alluxio.impl

alluxio.hadoop.FileSystem

fs.alluxio-ft.impl

alluxio.hadoop.FaultTolerantFileSystem

fs.AbstractFileSystem.alluxio.impl

alluxio.hadoop.AlluxioFileSystem

该配置使MapReduce识别Alluxio的URI(如alluxio:// )

其次, 在conf目录中hadoop-env.sh文件中修改$HADOOP_CLASSPATH:

export HADOOP_CLASSPATH=${HADOOP_CLASSPATH}::/opt/alluxio/alluxio-1.4.0/core/client/target/alluxio-core-client-1.4.0-jar-with-dependencies.jar

分发alluxio-core-client-1.4.0-jar-with-dependencies.jar,有多种方式,可以在跑MR程序时用-libjars指定,也可以放到alluxio每个节点的置于每个MapReduce节点的$HADOOP_HOME/lib(由于版本不同也可能是$HADOOP_HOME/share/hadoop/common/lib),如果您使用的Hadoop做了些优化,将一些jar包提前放到了HDFS上,那么需要将该jar包放到hdfs上。笔者重新打包了mapreduced.tar.gz,并上传至hdfs的/hdp/apps/2.3.4.0-3485/mapreduce/目录下

配置Hive

参考官方文档配置Hive

添加以下配置项到你的Hive安装目下的conf目录里的hive-site.xml中:

fs.defaultFS

alluxio://node1:19998

使用Hive过程中遇到的异常:

Could not setMode for UFS file hdfs://node1.hde.h3c.com:8020/tmp . Aborting the setAttribute operation in Alluxio.

原因是Hive找不到alluxio的jar包,笔者更新了HDFS上Hive的jar包(/hdp/apps/2.3.4.0-3485/hive/hive.tar.gz),将alluxio-core-client-1.4.0-jar-with-dependencies.jar打到了这个tar包中

在Hive中见表,并插入一条数据(insert语句),测试发现数据缓存到了Alluxio,如下图所示:

SparkSQL相遇

启动spark-sql命令行,执行insert向刚才hive中创建的表插入一条数据:

发现在SparkSQL中插入的一条数据也存在了内存中,如下图所示:

在SparkSQL中创建一张新表,并插入数据

查看Alluxio向的缓存情况,如下图所示,数据全部落到HDFS上,并未存到内存中。

总结一下:

- Hive配置Alluxio成功后,在Hive中建表并插入数据,可存入Alluxio内存,在SparkSQL中向这个表插入数据,也能缓存到内存。

- 在SparkSQL中建表并插入数据,不能缓存到Alluxio的内存中。

如何能SparkSQL建表并插入的数据缓存到Alluxio的内存中呢?

经研究发现配置Hive时,修改的fs.defaultFS配置针对Hive是起作用的,但是SparkSQL并不解析这个配置,所以就算在spark-home/conf/hive-site.xml加上这个配置也不会起作用。

幸好,Hive提供了修改元数据属性的工具metatool,我们可以通过此工具修改fs的类型:

-listFSRoot print the current FS root locations

-updateLocation Update FS root location in the

metastore to new location.Both

new-loc and old-loc should be valid

URIs with valid host names and

schemes.When run with the dryRun

option changes are displayed but

are not persisted. When run with

the serdepropKey/tablePropKey

option updateLocation looks for the

serde-prop-key/table-prop-key that

is specified and updates its value

if found.

修改过程如下所示,通过此命令将hive的warehouse从hdfs上修改到了alluxio上。

[root@node2 hive]# bin/metatool -listFSRoot

hdfs://node1.hde.h3c.com:8020/apps/hive/warehouse/hmr.db

hdfs://node1.hde.h3c.com:8020/apps/hive/warehouse

[root@node2 hive]# bin/metatool --updateLocation alluxio://node1:19998 hdfs://node1.hde.h3c.com:8020

Updated 12 records in SDS table

[root@node2 hive]# bin/metatool -listFSRoot

alluxio://node1:19998/apps/hive/warehouse/hmr.db

alluxio://node1:19998/apps/hive/warehouse

测试是否管用,新建一张表并插入数据:

spark-sql> create table test_sparksql2(id int, name string);

Time taken: 1.023 seconds

spark-sql> insert into test_sparksql2 values(1, 'aa');

Time taken: 2.294 seconds

spark-sql> select * from test_sparksql2;

1 aa

Time taken: 0.821 seconds, Fetched 1 row(s)

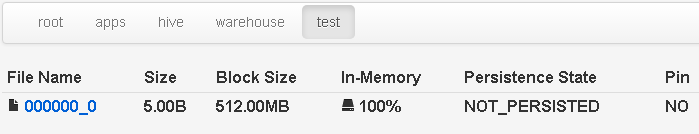

查看Alluxio的缓存情况,如下图所示,数据全部缓存到内存中。

- 我们使用SparkSQL建表,insert/load操作都能缓存到内存中。通过配置Alluxio的存储策略,大数据量的表我们也无需关心内存是否足够。如果内存足够大,SparkSQL的性能必将几何级提升。

- 不同于SparkSQL提供的cache table语句,Alluxio的方式存放数据不会随着启动SparkSQL的进程(或JDBC)的退出而消失,这对于不同进程间的数据共享,意义无疑是巨大的。