PYNQ 采集计划(二)Socket服务端与客户端的搭建,pynq到pc的数据流传输

文章目录

- 利用Socket搭建客户端和服务端

- 简易Socket收发

- 服务端的搭建

- 客户端的搭建

- 真正的视频socket收发

- 服务端

- PC端客户端

- 进行测试

- 源码github地址

利用Socket搭建客户端和服务端

我是真的不习惯jupyterNotebook编程,所以现在PC上写好两个端的程序再把服务器端弄过去吧。

简易Socket收发

服务端的搭建

先简单尝试一下怎么用Socket搭一个小服务器

老规矩,遇事不决看例程

其最简例程为

# Echo server program

import socket

HOST = '' # Symbolic name meaning all available interfaces

PORT = 50007 # Arbitrary non-privileged port

with socket.socket(socket.AF_INET, socket.SOCK_STREAM) as s:

s.bind((HOST, PORT))

s.listen(1)

conn, addr = s.accept()

with conn:

print('Connected by', addr)

while True:

data = conn.recv(1024)

if not data: break

conn.sendall(data)

所以搭建一个socket_service需要啥呢?

首先是创建一个对象

s = socket.socket(socket.AF_INET, socket.SOCK_STREAM)#############对于with那句

然后要有host和port,这个port不妨就取4000,然后host设为本机的’127.0.0.1’

s.bind(('127.0.0.1', 4000))

然后就是这个listen了参数是啥意思嘞

官方文档

给出的信息是

socket.listen([backlog])

允许服务器接受连接。如果指定了backlog,它必须至少为0(如果更低,则设置为0);它指定在拒绝新连接之前系统将允许的未接受连接的数量。如果未指定,则选择一个默认的合理值。

那我们就设置个1好了,反正自己连

s.listen(1)

最后就是accept接受数据了

接受一个连接。socket必须绑定到一个地址并监听连接。返回值是一对(conn, address),其中conn是用于在连接上发送和接收数据的新套接字对象,address是绑定到连接另一端套接字的地址。

新创建的socket不可继承。

按照例程的用法,只需要一次s.accept就可以了。

conn, addr = s.accept()

with conn:

print('Connected by', addr)

while True:

data = conn.recv(1024)

if not data: break

conn.sendall(data)

里面recv的参数在官方文档的描述为

socket.recv(bufsize[, flags])

从socket接收数据。返回值是一个字节对象,表示接收到的数据。一次接收的最大数据量由bufsize指定。有关可选参数标志的含义,请参阅Unix手册中的recv(2)页;它默认为零。

注意,为了更好地匹配硬件和网络现实,bufsize的值应该是相对较小的2的幂,例如4096。

客户端的搭建

其例程为

# Echo client program

import socket

HOST = 'daring.cwi.nl' # The remote host

PORT = 50007 # The same port as used by the server

with socket.socket(socket.AF_INET, socket.SOCK_STREAM) as s:

s.connect((HOST, PORT))

s.sendall(b'Hello, world')

data = s.recv(1024)

print('Received', repr(data))

大概意思就是我们的client端只需要进行socket对象的建立、链接、sendall命令就行了。

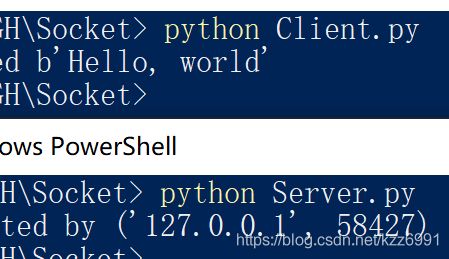

简单写一下,分别运行两个程序,我的host设置在了本机127.0.0.1上,可以看到成功运行了。

将其地址改为192.168.2.99并把server放到pynq上,也可以成功

真正的视频socket收发

主要参考这篇资料进行的视频客户端与服务端的修改。1

服务端

首先进行Server的初始化,如之前的test一样。

class SocketServer:

'''进行SocketServer的初始化配置'''

def __init__(self,addr="",port = 8880) -> None:

self.resolution = (1920,1080) # 分辨率

self.img_fps = 30 # 帧率

self.Set_Socket(addr,port) # 调用设置Socket的方法

def Set_Socket(self,addr,port):

self.server = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

self.server.setsockopt(socket.SOL_SOCKET,socket.SO_REUSEADDR,1) ## 允许端口复用

self.server.bind((addr,port))

self.server.listen(5) # 允许连接数量

print("addr:",addr,"port:",port)

接下来的重点就是将图片编码然后发出,用cv2将其编码为jpg格式然后发就行了

while(1):

# 读取一帧视频

server.img = hdmi_in.readframe()

server.img = cv2.resize(server.img, server.resolution)# 按格式生成图片

img_encode = cv2.imencode('.jpg',server.img,img_param)

img_code = numpy.array(img_encode[1])

server.img_data = img_code.tostring()

client.send(

struct.pack("lhh",len(server.img_data),server.resolution[0],server.resolution[1]) + server.img_data)

需要主要的是原文中的img_code = numpy.array(img_encode)需要修改为现在的img_code = numpy.array(img_encode[1]),看print结果可知img_encode是True和一个array合成的tuple,如果不这么写会报错。我们只需要发送array的内容就可以了。

PC端客户端

PC端前半部分配置与test类似

读取图像解码仍然需要用到cv2。这块按照大佬的程序来就可以了。

info=struct.unpack("lhh",self.client.recv(8))

buf_size=info[0] #获取读的图片总长度

if buf_size:

try:

self.buf=b"" #代表bytes类型

temp_buf=self.buf

while(buf_size): #读取每一张图片的长度

temp_buf=self.client.recv(buf_size)

buf_size-=len(temp_buf)

self.buf+=temp_buf #获取图片

data = numpy.fromstring(self.buf, dtype='uint8') #按uint8转换为图像矩阵

self.image = cv2.imdecode(data, 1) #图像解码

cv2.imshow(self.name, self.image) #展示图片

except:

pass

finally:

if(cv2.waitKey(10)==27): #每10ms刷新一次图片,按‘ESC’(27)退出

self.client.close()

cv2.destroyAllWindows()

break

进行测试

在pynq上运行服务端,在pc上运行客户端,会弹出窗口。我是把手机连了一根hdmi线到pynq上,可以看到手机内容。

理论上将只要pynq和电脑处于同一个局域网下,就能够在电脑上查看连入pynq的hdmi输出视频。

以后没有hdmi显示设备的时候可以拿电脑先看一下了。

还可以用pynq同时进行服务器视频输出和hdmi out。

这两天在搜一些关于pynq上的神经网络的资料2 3的时候,发现这个MJPG方式可能也不错,以后有空试试吧。

源码github地址

Github地址

CSDN下载地址

PYNQ-Z2调试笔记:基于PYNQ-Z2的远程人脸检测程序 ↩︎

基于PYNQ的神经网络自动驾驶小车-搭建神经网络 ↩︎

树莓派 USB摄像头 实现网络监控( MJPG-Streamer) ↩︎