我猜你不懂矩阵分析???机器人控制、SLAM先导知识 ——(1.2)线性映射

文章目录

- 1.2、线性映射

- 1.2.1 线性映射与线性变换

- ①线性和非线性映射的例子

- ②矩阵与标准线性空间之间的线性映射两事物的等同性

- 1.2.2 线性映射的矩阵表示

- 1.2.3 用坐标计算线性映射

- 1.2.4 映射的交换图

- 1.2.5 微分算子(diifferential operator)的矩阵表示

- 1.2.6 旋转变换的矩阵表示

- 1.2.7 镜面反射

- 1.2.8 矩阵的等价与相似

- 1.2.8.1 选择基,寻找“最简表示”

- 1.2.8(续) 矩阵相似

- 1.2.8.2 最简型

- 1.2.8.3 相似对角化的条件

- 1.2.9 特征值与特征向量

1.2、线性映射

1.2.1 线性映射与线性变换

设 V 1 , V 2 V_1,V_2 V1,V2是 F \Bbb F F上的线性空间, σ : V 1 → V 2 \sigma:V_1\to V_2 σ:V1→V2是映射。

- (保加性) σ ( e 1 + e 2 ) = σ ( e 1 ) + σ ( e 2 ) \sigma(e_1+e_2)=\sigma(e_1)+\sigma(e_2) σ(e1+e2)=σ(e1)+σ(e2)

- (保数乘性) σ ( e ⋅ k ) = σ ( e ) ⋅ k \sigma(e·k)=\sigma(e)·k σ(e⋅k)=σ(e)⋅k

则成 σ \sigma σ是 V 1 V_1 V1到 V 2 V_2 V2的 线性映射。

若 V 1 = V 2 = V V_1=V_2=V V1=V2=V,则称为 V V V上的 线性变换。

若线性映射 σ : V 1 → V 2 \sigma:V_1 \to V_2 σ:V1→V2是可逆映射(一一映射),则称作 线性同构。

①线性和非线性映射的例子

非线性映射例:

[ x 1 x 2 ] ↦ [ x 1 + x 2 x 1 x 2 ] \begin{bmatrix}x_1\\x_2\end{bmatrix}\mapsto\begin{bmatrix}x_1+x_2\\x_1x_2\end{bmatrix} [x1x2]↦[x1+x2x1x2]

原因:(线性映射是在一个空间内做加法或数乘,当映射到另一个空间时能够保持这两种性质仍成立)

[ 1 1 ] + [ 1 1 ] = [ 2 2 ] \begin{bmatrix}1\\1\end{bmatrix}+\begin{bmatrix}1\\1\end{bmatrix}=\begin{bmatrix}2\\2\end{bmatrix} [11]+[11]=[22]

[ 2 1 ] + [ 2 1 ] ≠ [ 4 4 ] \begin{bmatrix}2\\1\end{bmatrix}+\begin{bmatrix}2\\1\end{bmatrix}≠\begin{bmatrix}4\\4\end{bmatrix} [21]+[21]=[44]

故不是线性的。

②矩阵与标准线性空间之间的线性映射两事物的等同性

给定 A ∈ F m × n A \in \Bbb F^{m×n} A∈Fm×n,通过右乘列向量,可决定线性映射

F n → F m \Bbb F^n \to \Bbb F^m Fn→Fm x ↦ y = A x x\mapsto y=Ax x↦y=Ax

如何通过映射造出满足该映射的矩阵呢?

就是上例中,如何用 x ↦ y x \mapsto y x↦y 求出矩阵 A A A呢?

A ( x ) = A ( ϵ 1 x 1 ) + A ( ϵ 2 x 2 ) + ⋯ + A ( ϵ n x n ) \mathcal A(x)=\mathcal A(\epsilon_1x_1)+\mathcal A(\epsilon_2x_2)+\dots+\mathcal A(\epsilon_nx_n) A(x)=A(ϵ1x1)+A(ϵ2x2)+⋯+A(ϵnxn)这是 F n \Bbb F^n Fn的映射KaTeX parse error: Undefined control sequence: \mathcjuzhenbiaosal at position 2: =\̲m̲a̲t̲h̲c̲j̲u̲z̲h̲e̲n̲b̲i̲a̲o̲s̲a̲l̲ ̲A(\epsilon_1)·x… = [ A ( ϵ 1 ) A ( ϵ 2 ) … A ( ϵ n ) ] x =\begin{bmatrix}\mathcal A(\epsilon_1)&\mathcal A(\epsilon_2)&\dots&\mathcal A(\epsilon_n)\end{bmatrix}x =[A(ϵ1)A(ϵ2)…A(ϵn)]x = A x =Ax =Ax

1.2.2 线性映射的矩阵表示

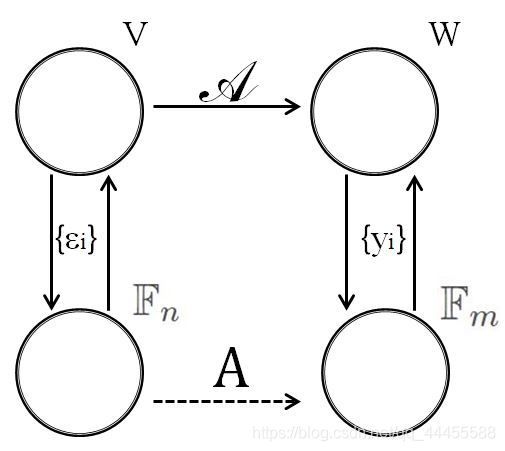

给定线性映射 A : V → W \mathcal A:V\to W A:V→W, d i m ( V ) = n dim(V)=n dim(V)=n, d i m ( W ) = m dim(W)=m dim(W)=m。

选取 V V V的基, ϵ 1 , ϵ 2 , … , ϵ n \epsilon_1,\epsilon_2,\dots,\epsilon_n ϵ1,ϵ2,…,ϵn,称作入口基; W W W的基, y 1 , y 2 , … , y m y_1,y_2,\dots,y_m y1,y2,…,ym,那就是出口基。

记第 j j j个入口基向量 ϵ j \epsilon_j ϵj的像 A ( ϵ j ) A(\epsilon_j) A(ϵj)在出口基下的坐标为 [ a 1 j a 2 j ⋮ a m j ] \begin{bmatrix}a_{1j}\\a_{2j}\\\vdots\\a_{mj}\end{bmatrix} ⎣⎢⎢⎢⎡a1ja2j⋮amj⎦⎥⎥⎥⎤

即 A ( ϵ j ) = [ y 1 y 2 … y m ] [ a 1 j a 2 j ⋮ a m j ] \mathcal A(\epsilon_j)=\begin{bmatrix}y_1&y_2&\dots&y_m\end{bmatrix}\begin{bmatrix}a_{1j}\\a_{2j}\\\vdots\\a_{mj}\end{bmatrix} A(ϵj)=[y1y2…ym]⎣⎢⎢⎢⎡a1ja2j⋮amj⎦⎥⎥⎥⎤

从这里可以看出 ϵ \epsilon ϵ的第 j j j项的矩阵表示就是,整个 V → W V\to W V→W矩阵表示的第 j j j列。

那么将 j j j从 0 → n 0\to n 0→n时就会拼成一个矩阵,这就是矩阵表示。入口基向量的项就跑到出口基空间里面去了。该矩阵的第 j j j列是第 j j j个入口基向量的像在出口基下的坐标。

A [ ϵ 1 ϵ 2 … ϵ m ] = [ y 1 y 2 … y m ] A \mathcal A\begin{bmatrix}\epsilon_1&\epsilon_2&\dots&\epsilon_m\end{bmatrix}=\begin{bmatrix}y_1&y_2&\dots&y_m\end{bmatrix}\it A A[ϵ1ϵ2…ϵm]=[y1y2…ym]A前者 A \mathcal A A是花体,表示映射关系;后者 A A A是矩阵。

也就是 [线性映射][入口基矩阵] = [出口基矩阵][矩阵表示]

1.2.3 用坐标计算线性映射

A : V → W \mathcal A:V\to W A:V→W V V V的基是 ϵ 1 , ϵ 2 , … , ϵ n \epsilon_1,\epsilon_2,\dots,\epsilon_n ϵ1,ϵ2,…,ϵn。W的基是 y 1 , y 2 , … , y m y_1,y_2,\dots,y_m y1,y2,…,ym。 A A A是映射的矩阵表示。给定 v ∈ V v\in V v∈V,其坐标为 x x x,则 A ( v ) ∈ W \mathcal A(v)\in W A(v)∈W的坐标为 A x Ax Ax。

我一次听这部分和上一部分做结合挺迷的,梳理一下就好了。

我们先对这个部分做一个推导:

- v v v是 V V V中的一个元素,它的坐标是x,那么可以表示为: v = [ ϵ 1 ϵ 2 … ϵ n ] x v=\begin{bmatrix}\epsilon_1&\epsilon_2&\dots&\epsilon_n\end{bmatrix}x v=[ϵ1ϵ2…ϵn]x那么有 A ( ϵ 1 x 1 + ⋯ + ϵ n x n ) \mathcal A(\epsilon_1x_1+\dots+\epsilon_nx_n) A(ϵ1x1+⋯+ϵnxn)进而可以写成 A ( ϵ 1 ) x 1 + … A ( ϵ n ) x n \mathcal A(\epsilon_1)x_1+\dots\mathcal A(\epsilon_n)x_n A(ϵ1)x1+…A(ϵn)xn写成矩阵的形式就是 [ A ( ϵ 1 ) … A ( ϵ n ) ] [ x 1 ⋮ x n ] \begin{bmatrix}\mathcal A(\epsilon_1)&\dots&\mathcal A(\epsilon_n)\end{bmatrix}\begin{bmatrix}x_1\\\vdots\\x_n\end{bmatrix} [A(ϵ1)…A(ϵn)]⎣⎢⎡x1⋮xn⎦⎥⎤前者是上一部分涉及的基向量经映射后的结果,就等于 [出口基矩阵][矩阵表示] 就是: [ y 1 y 2 … y m ] A \begin{bmatrix}y_1&y_2&\dots&y_m\end{bmatrix}A [y1y2…ym]A那上面这个式子就化成 [ y 1 y 2 … y m ] A x \begin{bmatrix}y_1&y_2&\dots&y_m\end{bmatrix}Ax [y1y2…ym]Ax

这里的 A x Ax Ax就是 A ( v ) ∈ W \mathcal A(v)\in W A(v)∈W的坐标 - 说到这里不知道能不能明白这部分和上部分的区别。上部分是 入口基矩阵 经过映射 得到 出口基矩阵 和 一个映射的表示矩阵。这部分是一个由 入口基矩阵 表示的 在映射变换前的线性空间内的一个元素,经过映射后 得到由出口基矩阵和原映射的表示矩阵以及这个元素在映射变换前的线性空间内的坐标。

1.2.4 映射的交换图

1.2.5 微分算子(diifferential operator)的矩阵表示

作用的空间是函数空间。

D : R 4 [ x ] → R 3 [ x ] \mathcal D:\Bbb R_4[x]\to \Bbb R_3[x] D:R4[x]→R3[x]这里的 R n [ x ] \Bbb R_n[x] Rn[x]是以 x x x为未定元,实系数次数小于 n n n次的多项式构成的空间。

R 4 [ x ] : 1 , x , x 2 , x 3 \Bbb R_4[x]:1,x,x^2,x^3 R4[x]:1,x,x2,x3 R 3 [ x ] : 1 , x , x 2 \Bbb R_3[x]:1,x,x^2 R3[x]:1,x,x2 D [ 1 x x 2 x 3 ] = [ D ( 1 ) D ( x ) D ( x 2 ) D ( x 3 ) ] = [ 0 1 2 x 3 x 2 ] = [ 1 x x 2 ] [ 0 1 0 0 0 0 2 0 0 0 0 3 ] 3 × 4 \mathcal D\begin{bmatrix}1&x&x^2&x^3\end{bmatrix}=\begin{bmatrix}\mathcal D(1)& \mathcal D(x)&\mathcal D(x^2)&\mathcal D(x^3)\end{bmatrix}=\begin{bmatrix}0&1&2x&3x^2\end{bmatrix}=\begin{bmatrix}1&x&x^2\end{bmatrix}\begin{bmatrix}0&1&0&0\\0&0&2&0\\0&0&0&3\end{bmatrix}_{3×4} D[1xx2x3]=[D(1)D(x)D(x2)D(x3)]=[012x3x2]=[1xx2]⎣⎡000100020003⎦⎤3×4可以想想看,这个矩阵 A A A是 3 × 4 3×4 3×4 的,若是上一部分↑的例子那就是 m × n m×n m×n 的矩阵,矩阵相乘计算后,就能够找到这组入口基和出口基之间的关系;延续下去,用入口基表示的一个线性空间中的向量是不是就可以用 A x Ax Ax (一个 m × n m×n m×n与 n × 1 n×1 n×1 的矩阵相乘)找出经过线性变换的关系了呢?

那么,假如要求得 1 2 x 3 + 5 x \frac{1}{2}x^3+5x 21x3+5x的微分呢,想必很简单了,如果用算子来计算呢?那就需要首先将原项在入口基下展开,那它的坐标是: [ 1 x x 2 x 3 ] [ 0 5 0 1 2 ] \begin{bmatrix}1&x&x^2&x^3\end{bmatrix}\begin{bmatrix}0\\5\\0\\\frac{1}{2}\end{bmatrix} [1xx2x3]⎣⎢⎢⎡05021⎦⎥⎥⎤ 这也是上一个部分我们讲到的 x x x,那么 A x Ax Ax 是什么呢?

A x Ax Ax在本例中就是: [ 0 1 0 0 0 0 2 0 0 0 0 3 ] 3 × 4 [ 0 5 0 1 2 ] = [ 5 0 3 2 ] \begin{bmatrix}0&1&0&0\\0&0&2&0\\0&0&0&3\end{bmatrix}_{3×4}\begin{bmatrix}0\\5\\0\\\frac{1}{2}\end{bmatrix}=\begin{bmatrix}5\\0\\\frac{3}{2}\end{bmatrix} ⎣⎡000100020003⎦⎤3×4⎣⎢⎢⎡05021⎦⎥⎥⎤=⎣⎡5023⎦⎤根据定理这就是项的坐标(出口基上的),那么沿着出口基组合,就出来了: [ 1 x x 2 ] [ 5 0 3 2 ] = 3 2 x 2 + 5 \begin{bmatrix}1&x&x^2\end{bmatrix}\begin{bmatrix}5\\0\\\frac{3}{2}\end{bmatrix}=\frac{3}{2}x^2+5 [1xx2]⎣⎡5023⎦⎤=23x2+5那么总结一下,引入线性空间的目的就是把一个相似化的问题从具象(concrete)变为抽象(abstract),用提取出的用矩阵表示的方法替代不同领域的不同解题方式。

1.2.6 旋转变换的矩阵表示

用空间几何的方法证明,可以看我的博文:四元数与三维旋转 QUATERNION&3D ROTATION。

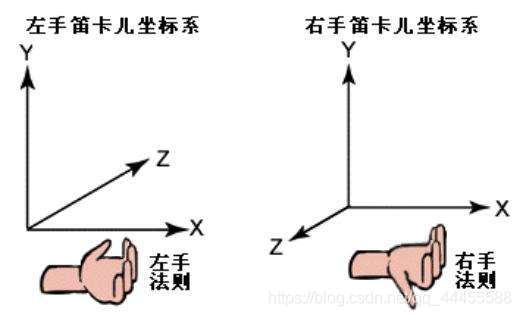

这里依照右手坐标系选择入口基。定义一个旋转映射 B \mathcal B B。

三维中绕一个维度旋转其实还是二维的旋转变换就是 [ c o s θ − s i n θ 0 s i n θ c o s θ 0 0 0 1 ] \begin{bmatrix}cos\theta&-sin\theta&0\\sin\theta&cos\theta&0\\0&0&1\end{bmatrix} ⎣⎡cosθsinθ0−sinθcosθ0001⎦⎤详细的希望大家看上面提供的那个博文,里面有详细的对四元数的推导。

1.2.7 镜面反射

我们定义这个映射为 C \mathcal C C。入口基选择镜面平面和它的法线向量。

那这个镜像反射矩阵就是 [ 1 0 0 0 1 0 0 0 − 1 ] \begin{bmatrix}1&0&0\\0&1&0\\0&0&-1\end{bmatrix} ⎣⎡10001000−1⎦⎤

1.2.8 矩阵的等价与相似

矩阵等价

A , B ∈ F m × n A,B\in \Bbb F^{m×n} A,B∈Fm×n成为等价,如果存在可逆矩阵 P ∈ F n × n P\in \Bbb F^{n×n} P∈Fn×n Q ∈ F m × m Q\in \Bbb F^{m×m} Q∈Fm×m使 A P = Q B AP=QB AP=QB。

注,线性代数是这么学的: P A Q = B PAQ=B PAQ=B是用来刻画初等行列式变换。左乘是对 行 做变换,右乘是对 列 做变换。

补充点我忘记的知识:奇异矩阵是行列式计算出等于零的矩阵,非奇异矩阵是满秩矩阵。(好我们继续)我们把这个可逆矩阵 P P P看成 F n \Bbb F^n Fn中的一组基(入口基), Q Q Q看做 F m \Bbb F^m Fm中的一组基(出口基):

A [ p 1 p 2 … p n ] = [ q 1 q 2 … q m ] B A\begin{bmatrix}p_1&p_2&\dots&p_n\end{bmatrix}=\begin{bmatrix}q_1&q_2&\dots&q_m\end{bmatrix}B A[p1p2…pn]=[q1q2…qm]B A A A和 B B B等价就有了另一种解释:

- 线性映射 A A A在入口基 P P P和出口基 Q Q Q下的矩阵表示是 B B B

1.2.8.1 选择基,寻找“最简表示”

T A S = [ I r 0 r , n − r 0 m − r , r 0 m − r , n − r ] m × n TAS=\begin{bmatrix}I_r&0_{r,n-r}\\0_{m-r,r}&0_{m-r,n-r}\end{bmatrix}_{m×n} TAS=[Ir0m−r,r0r,n−r0m−r,n−r]m×n T T T和 S S S 均是可逆矩阵, T = Q − 1 , S = P T=Q^{-1},S=P T=Q−1,S=P。 A m × n P n × n = Q m × m B m × n , B = [ I r 0 r , n − r 0 m − r , r 0 m − r , n − r ] m × n A_{m×n}P_{n×n}=Q_{m×m}B_{m×n},B=\begin{bmatrix}I_r&0_{r,n-r}\\0_{m-r,r}&0_{m-r,n-r}\end{bmatrix}_{m×n} Am×nPn×n=Qm×mBm×n,B=[Ir0m−r,r0r,n−r0m−r,n−r]m×n I r I_r Ir是 行秩=列秩= r r r 的分块矩阵的一部分。

这就是在两个基底 P P P和 Q Q Q下, A A A的矩阵表示是 B B B,同时也是以标准基表示的坐标在出口基下的矩阵表示;那么在入口基 P P P(这个 P P P不一定是标准基,可能是一般基)下的坐标,它的映射是什么呢?其实是 B x Bx Bx,这里的 x x x就是在入口基 P P P下的坐标。需要和前面的联系起来。我在理解这一块时也有很大困难。

那总这里可以看出,这样一个 n n n入 m m m出的静态的线性系统完全“解耦”成 r r r个单入单出的系统。为什么呢?

B = [ I r 0 r , n − r 0 m − r , r 0 m − r , n − r ] m × n B=\begin{bmatrix}I_r&0_{r,n-r}\\0_{m-r,r}&0_{m-r,n-r}\end{bmatrix}_{m×n} B=[Ir0m−r,r0r,n−r0m−r,n−r]m×n在 P P P这个入口基下的坐标 x x x,那么继续表示成映射的矩阵形式 B x Bx Bx就是 y = B x ⟹ y 1 = x 1 , y 2 = x 2 , … , y r = x r , y r + 1 = 0 , … , y m = 0 y=Bx\implies y_1=x_1,y_2=x_2,\dots,y_r=x_r,y_{r+1}=0,\dots,y_m=0 y=Bx⟹y1=x1,y2=x2,…,yr=xr,yr+1=0,…,ym=0

1.2.8(续) 矩阵相似

A , B ∈ F n × n A,B\in \Bbb F^{n×n} A,B∈Fn×n,如果存在n阶可逆矩阵 P P P使得 A P = P B AP=PB AP=PB,则称 A A A和 B B B相似。

注: P A P − 1 = B PAP^{-1}=B PAP−1=B A A A在入口基和出口基都是 P P P的情况下,它的矩阵表示是 B B B。

1.2.8.2 最简型

定义 (方阵的不变子空间):

A ∈ F n × n , W ⊆ F n A\in \Bbb F^{n×n},W \subseteq F^n A∈Fn×n,W⊆Fn是子空间。如果 A ( W ) ⊆ W A(W) \subseteq W A(W)⊆W,则称 W W W是 A A A的不变子空间。

注: A ( W ) = { A x ∣ x ∈ W } A(W)=\{Ax|x\in W\} A(W)={Ax∣x∈W}。

(不变子空间与相似三角化两个事物的等同性)

A P = P B AP=PB AP=PB P = [ P 1 ⏟ n 1 P 2 ] P=\left[ \begin{array}{c|c} \underbrace{P_1}_{n_1}&P_2 \end{array} \right] P=[n1 P1P2]相应的 B = [ B 11 B 12 B 21 B 22 ] B=\left[ \begin{array}{c|c} B_{11}&B_{12}\\ B_{21}&B_{22} \end{array} \right] B=[B11B21B12B22]

- B 21 = 0 B_{21}=0 B21=0(上三角矩阵) ⟺ \iff ⟺ i m P 1 imP_1 imP1是 A A A的不变子空间;

- B 12 = 0 B_{12}=0 B12=0(下三角矩阵) ⟺ \iff ⟺ i m P 2 imP_2 imP2是 A A A的不变子空间。

i m A = { { A x ∣ x ∈ … } s p a n { a 1 , a 2 , … } imA= \begin{cases} \{Ax|x\in \dots\} \\ span\{a_1,a_2,\dots\} \end{cases} imA={{Ax∣x∈…}span{a1,a2,…}

这样可以看出, i m P 1 imP_1 imP1是 P 1 P_1 P1张成的子空间,高度依然是 n 1 n_1 n1是线性无关的,是 n 1 n_1 n1维的子空间。

证:

A P 1 = [ P 1 P 2 ] [ B 11 B 21 ] AP_1=\begin{bmatrix}P_1&P_2\end{bmatrix}\begin{bmatrix}B_{11}\\B_{21}\end{bmatrix} AP1=[P1P2][B11B21]

{ A P 1 = P 1 B 11 + P 2 B 21 A P 2 = P 1 B 12 + P 2 B 22 \begin{cases} AP_1=P_1B_{11}+P_2B_{21}\\ AP_2=P_1B_{12}+P_2B_{22} \end{cases} {AP1=P1B11+P2B21AP2=P1B12+P2B22

- 假设 B 21 = 0 B_{21}=0 B21=0, A [ p 1 p 2 … p n 1 ] = [ p 1 p 2 … p n 1 ] [ b 11 … b 1 n 1 ⋮ ⋮ b n 1 1 … b n 1 n 1 ] A\begin{bmatrix}p_1&p_2&\dots&p_{n_1}\end{bmatrix}=\begin{bmatrix}p_1&p_2&\dots&p_{n_1}\end{bmatrix}\begin{bmatrix}b_{11}&\dots&b_{1n_1}\\\vdots&&\vdots\\b_{n_11}&\dots&b_{n_1n_1}\end{bmatrix} A[p1p2…pn1]=[p1p2…pn1]⎣⎢⎡b11⋮bn11……b1n1⋮bn1n1⎦⎥⎤ A p j ∈ s p a n ( P 1 ) , j = 1 , … , n 1 Ap_j\in span(P_1),j=1,\dots,n_1 Apj∈span(P1),j=1,…,n1

- B 12 = 0 B_{12}=0 B12=0同理

(双向的)有不变子空间,就一定可以相似三角化。给定一个矩阵 A A A如果能找到 A A A的一个不变子空间,就一定能把 A A A上三角化。 这是刚才讲到的逆向理解。

再重申一下: A [ P 1 P 2 ] = [ P 1 P 2 ] [ ∗ ∗ 0 ∗ ] A\begin{bmatrix}P_1&P_2\end{bmatrix}=\begin{bmatrix}P_1&P_2\end{bmatrix}\left[ \begin{array}{c|c} *&*\\ 0&* \end{array} \right] A[P1P2]=[P1P2][∗0∗∗] A A A作用在 P 1 P_1 P1基向量上的效果仍在这里面,就说明只需要这基向量的系数就行了, P 2 P_2 P2的系数就可以没有。

1.2.8.3 相似对角化的条件

A P = P [ a 1 … 0 ⋮ ⋱ ⋮ 0 … a n ] AP=P\begin{bmatrix}a_{1}&\dots&0\\\vdots&\ddots&\vdots\\0&\dots&a_n\end{bmatrix} AP=P⎣⎢⎡a1⋮0…⋱…0⋮an⎦⎥⎤这是上一题的延续 ⟺ i m P j \iff imP_j ⟺imPj是 A A A的不变子空间, j = 1 , 2 , ⋯ , n j=1,2,\cdots,n j=1,2,⋯,n。

一个矩阵相似的条件 —— 可逆矩阵P是这个矩阵的不变子空间。

1.2.9 特征值与特征向量

A P = P λ AP=P\lambda AP=Pλ A ∈ F n × n , P ∈ F n , λ ∈ F A\in \Bbb F^{n×n},P\in \Bbb F^n,\lambda\in \Bbb F A∈Fn×n,P∈Fn,λ∈F则成 λ \lambda λ为 A A A的一个特征值, P P P为相应的一个特征向量。

注:一维不变子空间的概念就导致了特征值与特征向量的概念。

(定理) A A A可以相似对角化 ⟺ \iff ⟺ A A A有一个由特征向量构成的基底。或者说有 n n n个线性无关的特征向量,也就是上面的 P P P中的每一个列向量都是一个特征向量。那么上一部分的 a j a_j aj就是特征值。

A ∈ F m × n A\in \Bbb F^{m×n} A∈Fm×n决定线性关系 F n → F m \Bbb F^n\to \Bbb F^m Fn→Fm x ↦ y = A x x \mapsto y=Ax x↦y=Ax这里的 x , y x,y x,y是线性空间中的元素(向量)

F n \Bbb F^n Fn中基 P = [ p 1 ⋯ p n ] P=\begin{bmatrix}p_1&\cdots&p_n\end{bmatrix} P=[p1⋯pn] x = P x ′ x=Px' x=Px′这里的 x ′ x' x′是 x x x在 P P P下的坐标

F m \Bbb F^m Fm中基 Q = [ q 1 ⋯ q m ] Q=\begin{bmatrix}q_1&\cdots&q_m\end{bmatrix} Q=[q1⋯qm] y = Q y ′ y=Qy' y=Qy′ y ′ y' y′是 y y y在 Q Q Q下的坐标 A P = Q B AP=QB AP=QB↑这个公式表示了两组基之间的关系

则 y ′ = B x ′ y'=Bx' y′=Bx′

再次强调 A P = Q B AP=QB AP=QB的含义是:线性映射 A A A作用在入口基向量上,在出口基上的坐标的矩阵表示是 B B B。那用入口基 坐标为 x x x表示的一个向量,经过线性映射 A A A之后得到的一个向量在 Q Q Q这个出口基下展开得到的坐标是 B x Bx Bx。

我也不知道过一阵子会不会忘记,感觉很抽象不是很好理解,现在我已经把我能想到的反复重复的记录在这篇blog里面了,也希望我乱乱的思路也能有启发性的帮助到读者。